La capacità di comprendere e riprodurre artificialmente le emozioni, al contrario di quanto si potrebbe pensare, non ha limiti teorici. All’aumentare della potenza analitica aumenta l’accuratezza con cui ciò può essere realizzato. Hanno già iniziato a essere realizzati, e potranno esserlo in modo sempre più realistico, robot con fattezze umane che si muovono come umani, che parlano come noi, comprendono quello che diciamo e sono anche in grado di controllare la comunicazione a livello emotivo, diventando quindi sempre più simili a un essere umano.

Indice degli argomenti:

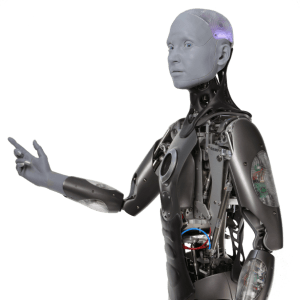

AI e sentimenti umani: il robot Ameca

Certamente questi esseri artificiali possono capire quali emozioni proviamo, sono in grado di simularle e di elaborare strategie per farcele provare. Possiamo anche far memorizzare al robot le loro e le nostre esperienze personali vissute, dandogli una sorta di identità specifica, facendo loro costruire relazioni inter-personali e/o intra-robot, con tanto di affinità, simpatie e antipatie. Non possiamo costruire persone, ma loro modelli sì; come, ad esempio, stanno facendo presso Engineered Arts, azienda britannica specializzata in robotica, che qualche tempo fa ha fatto parlare di sé per il robot umanoide Ameca, talmente simile a un essere umano da scatenare reazioni diffuse e contrastanti sul Web. Con il tempo, quindi, potremmo avere serie difficoltà a distinguere essere artificiali dagli umani. Anche perché insegnare loro, ad esempio, a esprimere rabbia e disapprovazione a fronte di comunicazioni contrarie agli obiettivi che abbiamo dato loro, o meglio, in accordo alle strategie per conseguirle, apre l’interazione a nuovi scenari.

Il robot Ameca

Una questione di fondo è quanto il robot possa essere complesso e quanto debba esserlo per assomigliarci veramente. Riguardo il primo interrogativo, la possibilità, non ci sono reali limiti se non quelli dello sviluppo teorico e tecnologico. Riguardo il secondo, la complessità, viene da dire che c’è ancora un bel po’ da lavorare, forse un abisso da colmare. O meglio, per certi aspetti ci siamo arrivati, anzi ci siamo superati, per altri meno.

L’intelligenza artificiale generale

Fino ad ora si è insegnato alle macchine a risolvere compiti; il passo successivo, in corso di studio, è insegnare loro ad apprendere automaticamente da ciò che ci circonda in modo pressoché indipendente dai problemi e ad applicare queste conoscenze per associazioni, analogie, paragoni, comparazioni, opportunità, dinamicamente, in autonomia e secondo le necessità: in poche parole, si tratta di dar vita alla cosiddetta intelligenza artificiale generale (General AI). A fronte di un particolare quesito, il cervello artificiale organizza le sue conoscenze per costruire un’istanza di algoritmo in grado di rispondere. In un certo senso si tratta di introdurre una sorta di buon senso che, come per gli umani, permetta di trovare soluzioni non solo a problemi già incontrati, ma anche ad altri nuovi, semplicemente basandosi sull’esperienza già passata, anche in campi completamente diversi. Stiamo quindi cercando di costruire macchine che imparino a imparare in modo piuttosto generale.

Il rischio di “macchine fuori controllo”

Tutto questo introduce certamente anche un certo grado di rischi. I sistemi virtuali imparano a ragionare in modo generale e, inevitabilmente, a costruire una loro personalità; tanto più si riesce a far ragionare loro come umani e su più dimensioni cognitive, quanto più è normale che questi tendano a creare meccanismi di autoconservazione e potenzialmente contrappositivi, se non adeguatamente istruiti a non farlo. Potrebbero quindi innescarsi dei processi di rapida accelerazione di intelligenze che si autoalimentano, creando una sorta di esplosione di intelligenza con “macchine” fuori controllo (superintelligence control problem).

Alle competenze tecnologiche è quindi necessario che si affianchino anche quelle epistemiologiche per lo studio e il controllo delle implicazioni della AI. Tuttavia, non basta, serve anche chiamare in causa l’etica (così come sta succedendo in Europa e, da qualche tempo, anche in Italia) per l’identificazione delle regole e dei principi secondo i quali queste invenzioni possano avvenire in modo corretto, affinché siano benefiche per l’umanità, centrandole sull’uomo e sul rispetto dei suoi valori. È necessario, insomma, mantenere ben presente che, per quanto con sembianze e fattezze umane e di ingente valore economico, si tratterà pur sempre e solo di macchine e non di individui.