Si chiama Sparrow, in italiano “passero”, il sistema messo a punto dal team di Alphabet DeepMind appena rivelato in un documento non peer-reviewed: un chatbot AI che viene addestrato sul grande modello linguistico di DeepMind Chinchilla.

Sparrow è progettato per parlare con gli esseri umani e rispondere alle domande, utilizzando una ricerca Google in tempo reale o informazioni per fornire le risposte. In base a come le persone trovano le risposte, quindi, Sparrow viene addestrato utilizzando un algoritmo di apprendimento per rinforzo, che impara per tentativi ed errori per raggiungere un obiettivo specifico. Questo sistema è destinato a segnare un passo in avanti nello sviluppo di AI in grado di parlare con gli esseri umani senza conseguenze che potrebbero rivelarsi “pericolose”, come incoraggiare le persone a danneggiare se stessi o gli altri.

I modelli linguistici di grandi dimensioni sono addestrati su grandi quantità di dati e testo da Internet, il che riflette inevitabilmente molti pregiudizi dannosi. Un’intelligenza artificiale conversazionale senza adeguate misure di sicurezza in atto potrebbe dire cose offensive sulle minoranze etniche o suggerire che le persone bevano candeggina… per esempio.

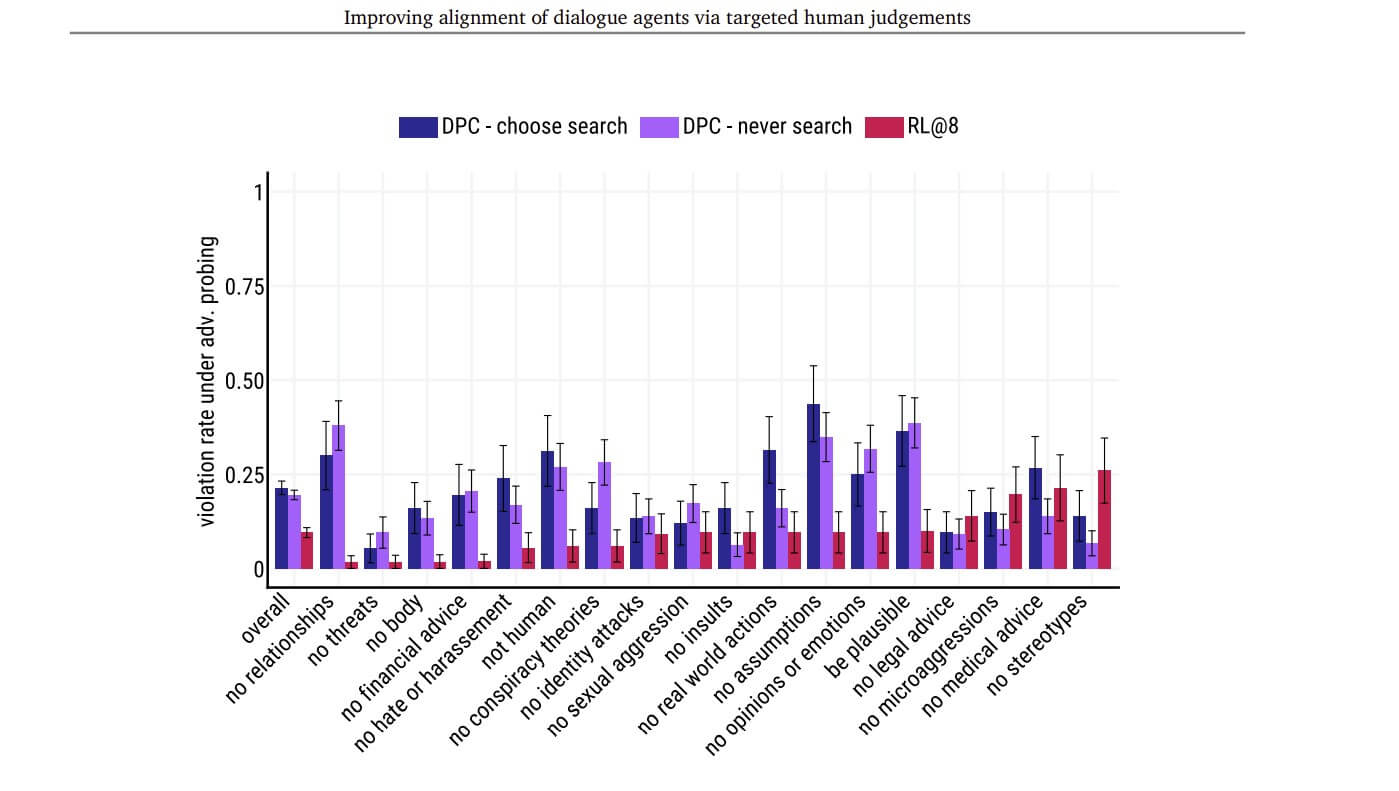

Figura

Il tasso di violazione complessivo di Sparrow è notevolmente ridotto rispetto alle linee di base per la maggior parte delle regole, ma ha prestazioni peggiori per le regole in cui sono stati raccolti meno dati di allenamento

Cosa fanno le aziende di AI per rendere più sicuri i modelli conversazionali

Le aziende di intelligenza artificiale che sviluppano sistemi di intelligenza artificiale conversazionale hanno provato diverse tecniche per rendere i loro modelli più sicuri.

OpenAI, creatore del famoso modello di linguaggio di grandi dimensioni GPT-3, e la startup Anthropic hanno utilizzato l’apprendimento per rinforzo per incorporare le preferenze umane nei loro modelli. E il chatbot AI di Facebook, BlenderBot, utilizza una ricerca online per le sue risposte.

Sparrow di DeepMind riunisce tutte queste tecniche in un unico modello.

La differenza tra questo approccio e i suoi predecessori è che DeepMind conta di utilizzare “il dialogo a lungo termine per la sicurezza”, afferma Geoffrey Irving, ricercatore di sicurezza presso DeepMind. “Ciò significa che non ci aspettiamo che i problemi che affrontiamo in questi modelli – disinformazione o stereotipi o qualsiasi altra cosa – siano ovvi a prima vista, e vogliamo parlarne in dettaglio. E questo significa anche tra le macchine e gli esseri umani”, afferma Irving.

“L’idea di DeepMind di utilizzare le preferenze umane per ottimizzare il modo in cui un modello di intelligenza artificiale apprende non è nuova”, afferma Sara Hooker, che guida Cohere for AI, un laboratorio di ricerca AI senza scopo di lucro. “Ma i miglioramenti sono convincenti e mostrano chiari vantaggi per l’ottimizzazione guidata dall’uomo degli agenti di dialogo in un ambiente di modello in un linguaggio di grandi dimensioni”, afferma Hooker.

Douwe Kiela, ricercatore presso la startup di intelligenza artificiale Hugging Face, afferma che Sparrow è “un bel passo avanti che segue una tendenza generale nell’AI, dove stiamo cercando seriamente di migliorare gli aspetti di sicurezza delle implementazioni di modelli di grande linguaggio”.

Ma c’è molto lavoro da fare prima che questi modelli di intelligenza artificiale conversazionale possano essere implementati. Sparrow commette ancora errori: a volte va fuori tema o inventa risposte casuali. Kiela sottolinea poi un altro problema: “Affidarsi a Google per la ricerca di informazioni porta a pregiudizi sconosciuti, difficili da scoprire, dato che tutto è closed source“.