Potenziare le risorse hardware non è più abbastanza, la computer grafica ha bisogno delle capacità predittive delle reti neurali per continuare la sua evoluzione verso il futuro. Se prima era sufficiente aumentare la quantità di RAM video e le performance delle GPU, adesso è necessario andare oltre. Aumentare le capacità computazionali significa anche moltiplicare le richieste di energia e, di conseguenza, anche il calore generato: un contesto incompatibile con device che si fanno sempre più piccoli e orientati alla mobilità. Il Neural Rendering può essere la risposta dell’AI alle necessità della computer grafica, consentendo di incrementare le performance dei sistemi fino a 5 volte, mantenendo comunque un elevato profilo di efficienza.

I risultati ottenuti da questa tecnologia destano stupore anche tra gli addetti ai lavori.

Indice degli argomenti:

Cos’è il Neural Rendering

Il rendering è un processo di generazione di immagini a due o tre dimensioni attraverso algoritmi che sfruttano modelli matematici per calcolare posizioni, geometrie, strutture dei materiali, luci, ombre, e riflessi di una scena complessa.

Il Neural Rendering utilizza reti neurali profonde per coadiuvare o addirittura sostituire i motori fisici nella generazione di queste immagini, creando informazioni sintetiche (ovvero pixel) che si basano sul training effettuato con immagini e video esistenti. Una delle architetture più utilizzate per tale scopo è la Generative Adversarial Network (GAN), composta da un modello generativo che produce nuovi dati elaborati partendo dal dataset di addestramento, e da un modello discriminativo che stima la qualità del risultato del modello generativo. La rete viene considerata addestrata quando il risultato del modello generativo riesce a ingannare il modello discriminativo.

Utilizzando il Neural Rendering per la gestione delle scene, cambiano del tutto i parametri per stabilire la potenza di calcolo richiesta. La velocità d’esecuzione, infatti, non dipende più strettamente dalla complessità della scena, ma dalle dimensioni della rete neurale che genera i contenuti sintetici. Questo significa che scenari complessi con un elevato numero di oggetti, luci e materiali, potranno essere renderizzati con frame rate elevatissimi, generando video di altissima qualità.

Dal Deep Learning Super Sampling al Neural Graphic Framework

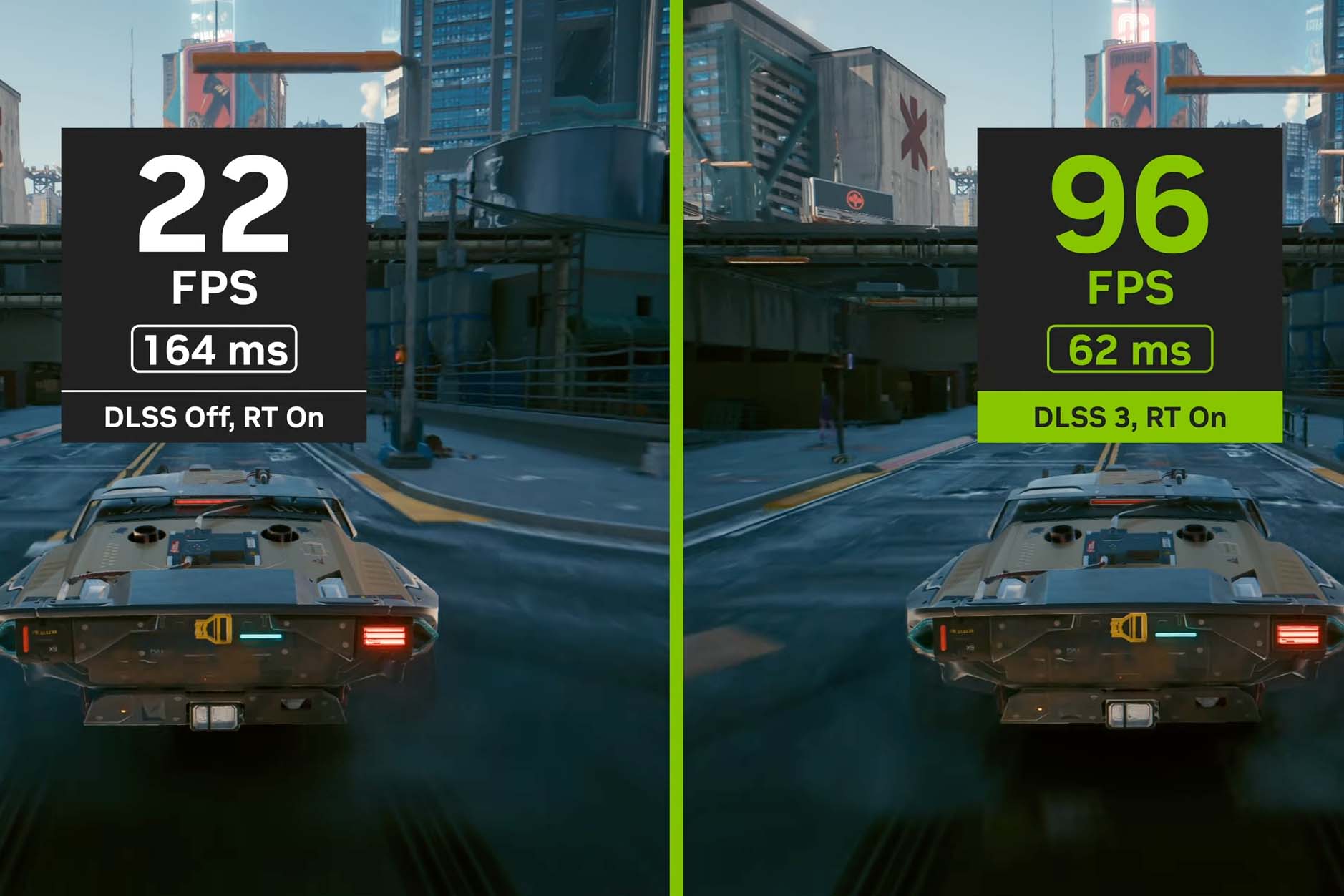

La prossima generazione di schede grafiche NVidia sfrutterà il Neural Rendering come non era mai stato fatto finora. La tecnologia proprietaria DLSS3 promette prestazioni fino a 5 volte più elevate, cambiando i paradigmi con i quali era stato affrontato, fino ad oggi, il problema della crescita esponenziale dello sforzo computazionale richiesto dai videogame e dai software di prossima generazione.

La prima generazione di Deep Learning Super Sampling (DLSS) di NVidia era una tecnologia che riusciva a ricreare immagini ad alta risoluzione partendo da contenuti a una risoluzione inferiore. Questo consentiva di alleggerire il compito della GPU, calcolando una minore quantità di dati con i sistemi di rendering tradizionale.

La seconda generazione di DLSS, grazie all’introduzione del Neural Graphic Framework, ha consentito di superare il problema dell’addestramento. Infatti, non è più necessario addestrare l’AI con un training set specifico per ogni software supportato. La rete neurale diventa, così, in grado, partendo da un modello generico, di ricreare scene di qualsiasi tipo. L’AI è anche in grado di confrontare retroattivamente gli ultimi frame generati, migliorando la precisione della ricostruzione delle immagini successive.

Con la terza generazione, che verrà resa presto disponibile, i frame ibridi renderizzati in parte dall’AI e in parte dagli algoritmi tradizionali, verranno alternati a fotogrammi che sono interamente generati dalla rete neurale. Questa tecnica consente di ridurre drasticamente il lavoro di calcolo della CPU, soprattutto nel caso di scenari molto complessi che richiedono simulazioni articolate composte da migliaia di elementi differenti.

Oltre all’esperienza accumulata dall’AI nella ricostruzione dell’immagine con il Super Resolution, che arriva adesso a generare gran parte dei pixel a schermo, questa nuova versione introduce un processo di generazione dell’intero frame, cosa che permetterà di incrementare le prestazioni in maniera ancora più netta.

DreamFusion apre alla sintesi 3D

Ma la tecnologia NVidia potrebbe essere soltanto il punto di partenza di una nuova generazione di sistemi di computer grafica interamente basati sulle capacità generative dell’intelligenza artificiale. Gli ultimi sviluppi dei sistemi in grado di sintetizzare scene complesse a partire dal testo aprono la strada a una nuova classe di tecnologie, in grado di generare intere scene senza il supporto dei sistemi di rendering tradizionale.

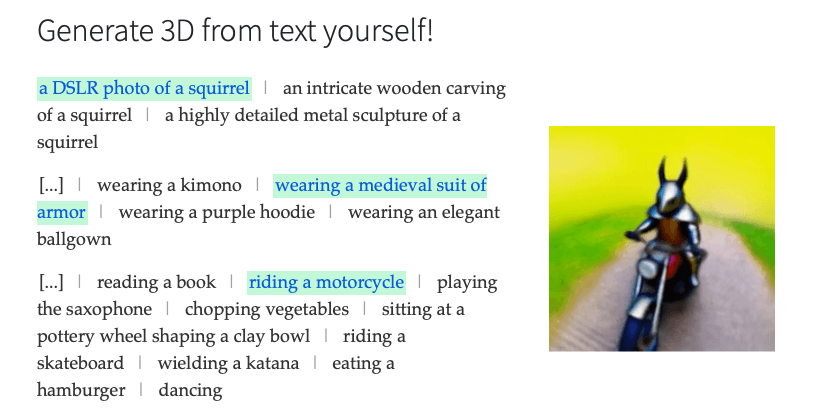

Progetti come DreamFusion 3D puntano a creare modelli 3D, generati da descrizioni testuali, che possano essere visualizzati da qualsiasi angolazione e con qualsiasi diffusione luminosa. Questa classe di AI ha il potenziale per rivoluzionare l’esperienza in tre dimensioni, semplificando la creazione di contenuti di alta qualità. La generazione di interi mondi virtuali potrebbe essere alla portata di tutti: sarebbe semplice come generare un’immagine in 2D a partire da una descrizione testuale. Al momento, è già possibile assaporare le potenzialità di DreamFusion generando scene coerenti, per quanto bizzarre, immaginando, ad esempio, uno scoiattolo fotorealistico che indossa un’armatura medievale, alla guida di una motocicletta.

Questo approccio non richiede un addestramento specifico e supera tutti gli ostacoli di performance che devono affrontare le tecnologie ibride basate su motori di rendering tradizionali. E i vantaggi vanno parecchio al di là delle sole performance, perché l’accesso alla creazione di questi scenari sarebbe alla portata di tutti; allo stesso modo, le applicazioni vanno molto oltre i videogame o i software di grafica 3D. La sintesi 3D apre le porte a scenari utilizzativi completamente nuovi e, forse, potrebbero essere un passo avanti verso la definizione di un metaverso, che ancora stentiamo a delineare con precisione.

La legge di Moore si sta esaurendo?

Gordon Moore, cofondatore di Intel, nel 1975 suppose che la complessità dei microprocessori sarebbe raddoppiata ogni anno. Questa previsione fu corretta a fine anni ’80, portando a 18 mesi il tempo di raddoppio del numero di transistor per chip.

Oggi ci si chiede se la legge di Moore sia ancora valida o se, invece, stia raggiungendo il suo limite naturale rendendo necessaria l’applicazione di nuovi concept per lo sviluppo tecnologico del futuro. Servono soluzioni che consentano di incrementare le performance e la qualità delle scene simulate, senza dover per forza raddoppiare il numero di transistor contenuti nelle unità di elaborazione. Come afferma Bryan Catanzaro, VP della divisione Deep Learning di Nvidia “La legge di Moore si sta esaurendo… la mia convinzione personale è che la grafica post-Moore sia grafica neurale.”

Nel panorama IT ci sono anche voci opposte, come quelle di Anton Kaplanyan, VP del Graphics Research Department di Intel, che resta conservativo sull’efficacia della legge di Moore pur ammettendo che l’AI può comunque fare la differenza sul campo dell’efficienza, permettendo lo sviluppo di soluzioni mobili di consumo che coniugano migliori performance ad una maggiore portabilità e autonomia.

Rendering neurale, un potenziale ancora da esplorare

Il rendering neurale ha un potenziale ancora da esplorare, non solo per le sue prestazioni, ma anche per la sua efficienza. Questo significa che il rendering AI-powered può ridurre il consumo energetico a una frazione di quello attualmente necessario. Questo è un dettaglio non di poco conto in un contesto dove l’attenzione all’utilizzo delle risorse e all’impatto ambientale del progresso tecnologico sta diventando un punto sempre più centrale per garantire un futuro all’umanità.

Che futuro immaginare per la computer grafica? Magari un futuro nel quale un utente, con semplicità, dal suo dispositivo mobile potrà creare mondi fantastici che, ad oggi, sono relegati all’universo cinematografico, e che richiedono investimenti da capogiro. Un futuro nel quale la fantasia e la creatività non saranno più limitati dalle performance dell’hardware