Poiché l’adozione dell’intelligenza artificiale generativa cresce a velocità record1 e le richieste di elaborazione aumentano2, l’elaborazione ibrida è più importante che mai. Ma proprio come l’informatica tradizionale si è evoluta da mainframe e thin client all’attuale mix di cloud e dispositivi edge, l‘elaborazione dell’AI deve essere distribuita tra cloud e dispositivi affinché l’AI possa scalare e raggiungere il suo pieno potenziale.

Un’architettura di AI ibrida distribuisce e coordina i carichi di lavoro dell’AI tra cloud e dispositivi edge, anziché elaborare solo nel cloud. Il cloud e i dispositivi edge – smartphone, automobili, personal computer e dispositivi Internet of Things (IoT) – lavorano insieme per offrire un’AI più potente, efficiente e altamente ottimizzata.

La motivazione principale è la riduzione dei costi. Ad esempio, si stima che il costo della ricerca basata sull’AI generativa per ogni query aumenti di 10 volte rispetto ai metodi di ricerca tradizionali3 – e questa è solo una delle tante applicazioni dell’AI generativa.

L’AI ibrida consentirà agli sviluppatori e ai fornitori di AI generativa di sfruttare le capacità di calcolo disponibili nei dispositivi edge per ridurre i costi. Un’architettura di AI ibrida (o l’esecuzione dell’AI solo sul dispositivo) offre i vantaggi aggiuntivi di prestazioni, personalizzazione, privacy e sicurezza su scala globale.

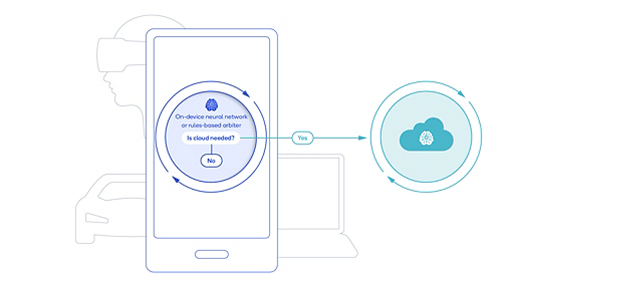

Queste architetture possono avere diverse opzioni di offload per distribuire l’elaborazione tra cloud e dispositivi, a seconda di fattori quali la complessità del modello e della query. Ad esempio, se le dimensioni del modello, la richiesta e la lunghezza della generazione sono inferiori a una certa soglia e forniscono un’accuratezza accettabile, l’inferenza può essere eseguita completamente sul dispositivo. Se il compito è più complesso, il modello può essere eseguito su cloud e dispositivi.

L’AI ibrida consente persino ai dispositivi e al cloud di eseguire i modelli in modo simultaneo, con i dispositivi che eseguono versioni leggere del modello mentre il cloud elabora più token del modello completo in parallelo e corregge le risposte del dispositivo, se necessario.

Scalare l’AI generativa con i dispositivi edge

Il potenziale dell’AI ibrida cresce ulteriormente man mano che i potenti modelli di AI generativa diventano più piccoli, mentre le capacità di elaborazione sui dispositivi continuano a migliorare. Modelli di AI con più di 1 miliardo di parametri sono già in esecuzione sui telefoni con prestazioni e livelli di accuratezza simili a quelli del cloud, e modelli con 10 miliardi di parametri o più sono destinati a essere eseguiti sui dispositivi nel prossimo futuro.

L’approccio all’AI ibrida è applicabile praticamente a tutte le applicazioni di AI generativa e a tutti i segmenti di dispositivi, compresi telefoni, laptop, cuffie per la realtà estesa, automobili e IoT. Questo approccio è fondamentale affinché l’AI generativa possa scalare e soddisfare le esigenze delle imprese e dei consumatori a livello globale.

References

1: Buchholz, K. (24 gennaio 2023). ChatGPT raggiunge un milione di utenti. Statista. Recuperato il 2 maggio 2023 da https://www.statista.com/chart/29174/time-to-one-million-users/

2: Sheth, S. (25 febbraio 2023). L’IA generativa porta a un’esplosione dei calcoli: L’incombente necessità di un’IA sostenibile. Silicon Angle. Recuperato il 2 maggio 2023 da https://siliconangle.com/2023/02/05/generative-ai-drives-explosion-compute-looming-need-sustainable-ai/

3: Dastin, J. et al. (22 febbraio 2023). Per i giganti tecnologici, le IA come Bing e Bard rappresentano un problema di ricerca da miliardi di dollari. Reuters. Recuperato il 2 maggio 2023 da https://www.reuters.com/technology/tech-giants-ai-like-bing-bard-poses-billion-dollar-search-problem-2023-02-22/