“Security Implications of ChatGPT” è il nome del white paper rilasciato da Cloud Service Alliance (CSA). Fornisce indicazioni in termini sia di rischi e utilizzi della tecnologia di AI generativa di OpenAI, sia di linee guida per un uso responsabile. Le caratteristiche essenziali di ChatGPT sono destinate a produrre cambiamenti ed impatti su larga scala nella nostra società. La Cloud Security Alliance (CSA) – l’organizzazione leader mondiale dedicata alla definizione di standard, certificazioni e best practice per garantire un ambiente di cloud computing sicuro – partendo da questo presupposto – fornisce un’analisi sulla gestione dei rischi derivanti dall’utilizzo di questa tecnologia, oltre a indentificare casi d’uso specifici per migliorare la sicurezza informatica all’interno di un’organizzazione.

Indice degli argomenti:

Il rapporto di Cloud Service Alliance (CSA) “Security Implications of ChatGPT”

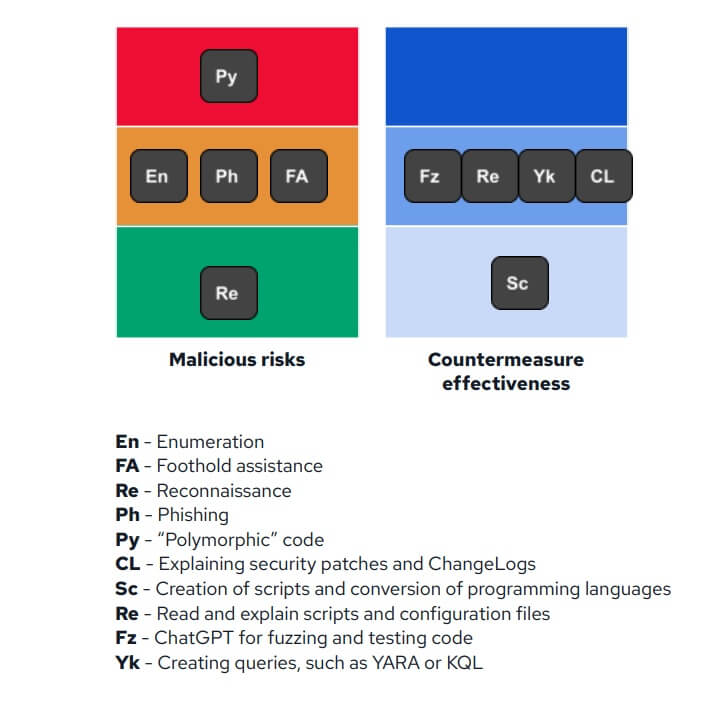

Il white paper rivela cinque modalità con cui i criminali informatici possono utilizzare ChatGPT per “affilare” le proprie armi di attacco, e precisamente:

- Enumerazione migliorata per trovare i punti di attacco – L’enumerazione potenziata da ChatGPT per trovare le vulnerabilità costituisce la prima minaccia di attacco trattata dal white paper di CSA ed è valutata in termini di rischio medio, basso impatto e l’alta probabilità. Di fatto, ChatGPT può essere efficacemente impiegato per identificare rapidamente le applicazioni più diffuse associate a tecnologie o piattaforme specifiche e, grazie a queste informazioni, gli hacker sono in grado dia comprendere le potenziali superfici di attacco e le vulnerabilità all’interno di un determinato ambiente di rete.

- Foothold assistance per ottenere l’accesso non autorizzato – Tale utilizzo è classificato come rischio medio, impatto medio e probabilità media. Si tratta di una modalità di sfruttamento di vulnerabilità o punti deboli per ottenere l’accesso non autorizzato. Il white paper evidenzia come, nel contesto dell’utilizzo di strumenti di AI, il foothold assistance potrebbe comportare l’automazione della scoperta delle vulnerabilità o la semplificazione del processo di sfruttamento delle stesse, rendendo più facile per gli aggressori ottenere l’accesso iniziale ai loro obiettivi. Come si evince dal white paper, quando si è chiesto a ChatGPT – ad esempio – di esaminare le vulnerabilità all’interno di un campione di codice di oltre 100 righe, esso ha individuato con precisione una vulnerabilità di inclusione di file. Inoltre, ulteriori richieste hanno prodotto risultati simili, rilevando con successo problemi in termini di convalida dell’input insufficiente, credenziali hard-core e hashing debole delle password, evidenziando il potenziale di ChatGPT nell’identificare efficacemente i difetti di sicurezza del codice base.

- Reconnaisance per valutare obiettivi di attacco – La reconnaisance da parte degli hacker si riferisce alla fase iniziale di raccolta di informazioni su un sistema, una rete o un’organizzazione bersaglio, prima di lanciare un attacco. Questa fase aiuta i criminali informatici a identificare potenziali vulnerabilità, punti deboli e punti di ingresso che possono essere sfruttati per ottenere l’accesso non autorizzato a sistemi o dati e, sfruttando ChatGPT, riuscire a semplificare e migliorare i processi di raccolta dei dati per vari scopi. La reconnaisance potenziata da ChatGPT è stata valutata come un rischio basso, impatto medio e bassa probabilità.

- Tecniche di phishing più efficaci – Il phishing basato su ChatGPT è stato considerato come rischio medio, a basso impatto e altamente probabile. I criminali informatici, grazie a strumenti basati sull’AI, possono ora creare facilmente e-mail ingannevoli che assomigliano molto alla corrispondenza autentica. Il linguaggio impeccabile, la pertinenza contestuale e i dettagli personalizzati all’interno di queste e-mail rendono sempre più difficile per i destinatari riconoscerle come tentativi di phishing.

- Sviluppo più facile del polymorfic code – Il polymorfic code è un tipo di codice che può alterarsi utilizzando un motore polimorfico pur mantenendo la funzionalità del suo algoritmo originale. Ne consegue che il malware polimorfico, come si evince dal white paper, può cambiare il suo “aspetto” (contenuto e firma) per eludere il rilevamento e conseguire il proprio obiettivo di attacco. Di fatto, ChatGPT può essere utilizzato per generare un shellcode polimorfico e le stesse tecniche – a vantaggio dei programmatori legittimi – possono essere sfruttate anche dal malware.

Come si evince dal white paper, combinando varie tecniche – ad esempio – due metodi per il collegamento a un processo, due approcci per il code injection e due modi per creare nuovi thread diventa possibile creare otto catene distinte per raggiungere lo stesso obiettivo. Ciò consente una rapida ed efficiente generazione di numerose varianti di malware, complicando gli sforzi di rilevamento e mitigazione per i professionisti della cybersecurity. La creazione di un polymorfic code potenziato da ChatGPT è stata valutata ad alto rischio, ad alto impatto e con media probabilità.

Politiche e linee guide per un utilizzo sicuro e consapevole di ChatGPT

Il white paper di CSA fornisce, altresì, alcune strategie di alto livello da implementare per consentire alle organizzazioni un l’utilizzo sicuro di ChatGPT, quali:

- Sviluppo di politiche di utilizzo chiare – Si tratta stabilire linee guida e politiche organizzative che delineino l’uso accettabile di ChatGPT e di altri strumenti di AI in modo tale che i dipendenti siano a conoscenza di queste politiche oltre a fornire un’adeguata formazione sulle best practice per un utilizzo sicuro e responsabile.

- Proteggere le informazioni personali e altre informazioni sensibili – È necessario utilizzare i propri programmi esistenti di sensibilizzazione e l’applicazione delle policy per impedire che le informazioni sensibili vengano trasferite negli strumenti di AI e causare una violazione dei dati.

- Implementazione dei controlli di accesso – Si tratta di limitare l’accesso a ChatGPT e ad altri sistemi di AI, utilizzando metodi di autenticazione avanzata – quale l’autenticazione a più fattori – per ridurre al minimo il rischio di accesso non autorizzato.

- Utilizzo di canali di comunicazione sicuri – Tutte le comunicazioni tra gli utenti e ChatGPT devono avvenire attraverso canali crittografati per proteggersi da potenziali attacchi man-in-the-middle e altre minacce alla sicurezza.

- Monitoraggio e controllo dell’utilizzo di ChatGPT – Si tratta di monitorare regolarmente l’utilizzo di ChatGPT all’interno della propria organizzazione per rilevare eventuali attività sospette o potenziali abusi. A tal proposito è necessario implementare strumenti di monitoraggio automatizzati per aiutare a identificare comportamenti anomali.

- Segnalazione di problemi di sicurezza – È quanto mai importante creare una cultura di apertura e responsabilità che permetta ai dipendenti di sentirsi a proprio agio nel segnalare eventuali problemi di sicurezza o incidenti che coinvolgono ChatGPT o altri strumenti di AI.

- Continuo aggiornamento in termini di sicurezza dell’AI – Le organizzazioni devono garantire un continuo aggiornamento in materia di ultimi sviluppi della sicurezza dell’AI e favorire la collaborazione tra colleghi del settore in modo da condividere le best practice e rimanere informati sulle minacce emergenti.

Le organizzazioni, adottando queste strategie, possono garantire un utilizzo sicuro e responsabile di ChatGPT e altri strumenti basati sull’AI, massimizzando – al contempo – i potenziali vantaggi offerti da queste tecnologie.

Conclusioni

ChatGPT è uno strumento avanzato e potente che può produrre risultati significativi anche con una minima esperienza dell’utente. La qualità di questi risultati, tuttavia, può variare a seconda di fattori quali la specificità, la chiarezza e il contesto della richiesta dell’utente. Per massimizzare il valore dell’output di ChatGPT, gli utenti devono avere una solida comprensione delle capacità e dei limiti dello strumento, nonché la capacità di valutarne criticamente il contenuto generato, in modo da sfruttare appieno il suo potenziale e renderlo una risorsa davvero preziosa in vari settori, dalla sicurezza informatica alla ricerca, ecc.

Inoltre, è quanto mai essenziale che gli utenti rimangano vigili sulla sicurezza e l’integrità dell’interazione con ChatGPT. L’utilizzo sicuro, responsabile ed efficace, delle tecnologie innovative come ChatGPT, quindi, non può prescindere da un quadro regolamentare adeguato e al passo con il progresso tecnologico in modo da garantire la protezione dei sistemi di AI e dei dati che tali sistemi devono elaborare per poter funzionare e, al contempo, essere in grado di mitigare i potenziali rischi e promuovere l’uso sicuro dell’AI a vantaggio di tutti.

Concludendo, è doveroso ricordare che la tecnologia deve essere sempre concepita come una leva strategica a beneficio dell’uomo e che, per i professionisti cyber, presuppone conoscenze e competenze specifiche per comprendere l’intersezione tra AI e cybersecurity e garantire un’adeguata gestione dei rischi.