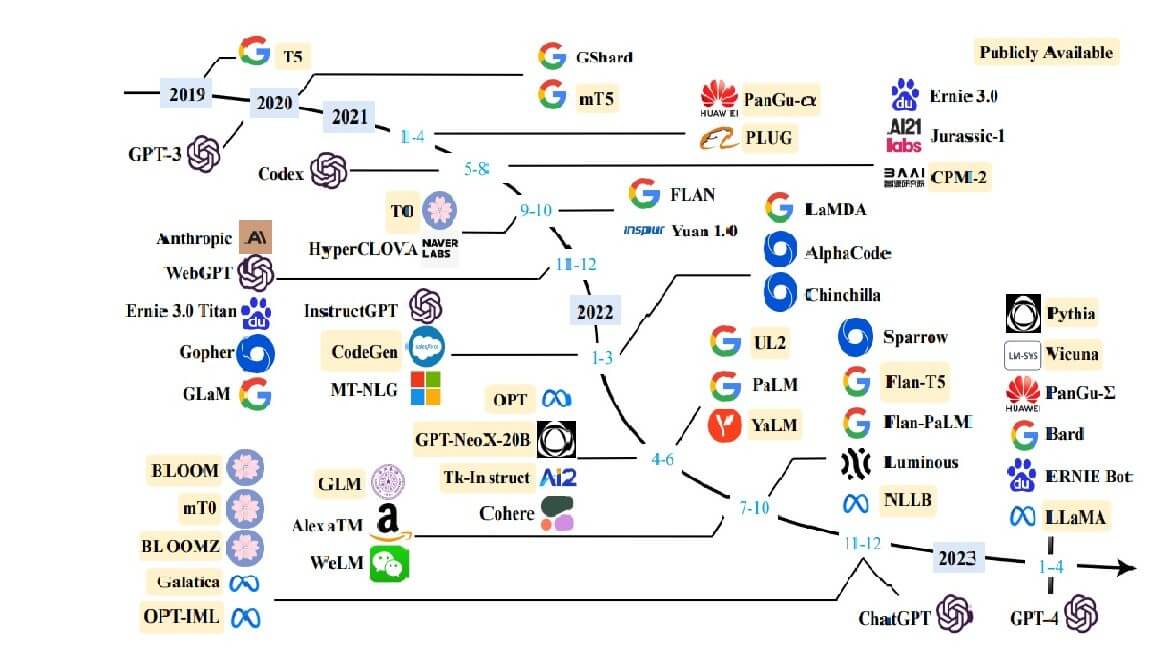

Basterebbe già il nome, LLM – “grandi modelli linguistici” – a far capire che i nuovi sistemi di intelligenza artificiale sono alimentati da vaste reti neurali artificiali. GPT-3, un LLM rilasciato nel 2020, era un colosso: 175 miliardi di “parametri”, come vengono chiamate le connessioni simulate tra i neuroni. È stato addestrato facendo scorrere a migliaia di GPU (chip specializzati che eccellono nel lavoro dell’intelligenza artificiale) centinaia di miliardi di parole di testo nel corso di diverse settimane. Si ritiene che tutto ciò sia costato almeno 4,6 milioni di dollari.

Indice degli argomenti:

LLM, il problema del gigantismo

Questo gigantismo sta diventando un problema. Se la cifra del raddoppio decennale di Epoch AI è corretta, i costi di formazione potrebbero superare il miliardo di dollari entro il 2026, sempre che i modelli non esauriscano prima i dati. Un’analisi pubblicata nell’ottobre del 2022 prevede che le scorte di testo di alta qualità per l’addestramento potrebbero esaurirsi nello stesso periodo. E anche una volta completato l’addestramento, l’utilizzo effettivo del modello risultante può essere costoso. Più il modello è grande, più costa farlo funzionare. All’inizio di quest’anno la banca Morgan Stanley ha ipotizzato che, se la metà delle ricerche di Google fosse gestita da un programma di tipo GPT, l’azienda potrebbe spendere altri 6 miliardi di dollari all’anno. Man mano che i modelli diventano più grandi, questa cifra probabilmente aumenterà.

Molti nel settore pensano quindi che l’approccio “più grande è meglio” si stia esaurendo. Se si vuole che i modelli di AI continuino a migliorare – per non parlare di realizzare i sogni legati all’AI che stanno attualmente travolgendo l’industria tecnologica – i loro creatori dovranno trovare il modo di ottenere maggiori prestazioni con meno risorse. Come ha detto Altman in aprile, riflettendo sulla storia dell’AI di dimensioni gigantesche: “Penso che siamo alla fine di un’era”.

Modelli più piccoli con un addestramento più lungo

Al contrario, i ricercatori stanno iniziando a prestare attenzione a rendere i loro modelli più efficienti, piuttosto che semplicemente più grandi. Un approccio consiste nel fare dei compromessi, riducendo il numero di parametri ma addestrando i modelli con più dati. Nel 2022 i ricercatori di DeepMind, divisione di Google, hanno addestrato Chinchilla, un LLM con 70 miliardi di parametri, su un corpus di 1,4 trilione di parole. Il modello ha superato GPT-3, che ha 175 miliardi di parametri addestrati su 300 miliardi di parole. Se si alimenta un LLM più piccolo con un maggior numero di dati, l’addestramento è più lungo. Ma il risultato è un modello più piccolo, più veloce e più economico da usare.

Un’altra opzione è quella di rendere i calcoli più confusi. Tracciare un numero inferiore di cifre decimali per ogni numero nel modello – arrotondando, in altre parole – può ridurre drasticamente i requisiti hardware. A marzo i ricercatori dell’Institute of Science and Technology in Austria hanno dimostrato che l’arrotondamento può ridurre la quantità di memoria consumata da un modello simile a GPT-3, consentendo l’esecuzione del modello su una sola GPU di fascia alta anziché su cinque, con un “degrado trascurabile della precisione”.

LLM tarati su compiti specifici

Alcuni utenti mettono a punto LLM generici per concentrarsi su un compito specifico, come la generazione di documenti legali o l’individuazione di fake news. Si tratta di un’operazione meno onerosa rispetto alla formazione di un LLM, ma può essere comunque costosa e lenta. La messa a punto di LLaMA, un modello open-source con 65 miliardi di parametri costruito da Meta, la società madre di Facebook, richiede a più GPU da alcune ore a qualche giorno.

Guanaco, un LLM su singola GPU

I ricercatori dell’Università di Washington hanno inventato un metodo più efficiente che ha permesso loro di creare un nuovo modello, Guanaco, da LLaMA su una singola GPU in un giorno senza sacrificare molto, se non per nulla, le prestazioni. Parte del trucco consisteva nell’utilizzare una tecnica di arrotondamento simile a quella degli austriaci. Ma hanno anche utilizzato una tecnica chiamata “adattamento a basso rango”, che prevede il congelamento dei parametri esistenti di un modello e l’aggiunta di una nuova serie di parametri più piccoli nel mezzo. La messa a punto avviene modificando solo le nuove variabili. Questo semplifica abbastanza le cose che anche computer relativamente deboli come gli smartphone potrebbero essere all’altezza del compito. Consentire agli LLM di vivere sul dispositivo dell’utente, anziché nei giganteschi centri dati che attualmente abitano, potrebbe consentire una maggiore personalizzazione e una maggiore privacy.

L’opzione di Google

Un team di Google, invece, ha proposto un’opzione diversa per chi è in grado di utilizzare modelli più piccoli. Questo approccio si concentra sull’estrazione delle conoscenze specifiche richieste da un modello grande e generico in uno più piccolo e specializzato. Il modello grande funge da insegnante e quello piccolo da studente. I ricercatori chiedono all’insegnante di rispondere alle domande e di mostrare come arriva alle sue conclusioni. Sia le risposte che il ragionamento dell’insegnante vengono utilizzati per addestrare il modello studente. Il team è riuscito ad addestrare un modello studente con soli 770 milioni di parametri, che ha superato il suo insegnante da 540 miliardi di parametri in un compito di ragionamento specializzato.

Cambiare il modo in cui vengono realizzati i modelli

Piuttosto che concentrarsi su ciò che fanno i modelli, un altro approccio è quello di cambiare il modo in cui vengono realizzati. Gran parte della programmazione dell’intelligenza artificiale avviene in un linguaggio chiamato Python. È stato progettato per essere facile da usare, liberando i programmatori dalla necessità di pensare esattamente a come i loro programmi si comporteranno sui chip che li eseguiranno. Il prezzo dell’astrazione di questi dettagli è la lentezza del codice. Prestare maggiore attenzione a questi dettagli di implementazione può portare grandi benefici. Questa è “una parte enorme del gioco al momento”, afferma Thomas Wolf, direttore scientifico di Hugging Face, azienda di intelligenza artificiale open-source.

Imparare a codificare

Nel 2022, ad esempio, i ricercatori dell’Università di Stanford hanno pubblicato una versione modificata dell'”algoritmo dell’attenzione”, che consente ai LLM di apprendere le connessioni tra parole e idee. L’idea era quella di modificare il codice per tenere conto di ciò che accade sul chip che lo esegue, e in particolare per tenere traccia di quando una determinata informazione deve essere cercata o memorizzata. Il loro algoritmo è stato in grado di accelerare di tre volte l’addestramento del GPT-2, un vecchio modello di linguaggio di grandi dimensioni. Inoltre, gli ha dato la possibilità di rispondere a interrogazioni più lunghe. A questo riguardo, è da segnalare anche phi-1 di Microsoft, basato solo su 1,3 miliardi di parametri e addestrato in appena 4 giorni, che in accuratezza batte GPT-3.5.

Da Meta una versione aggiornata di PyTorch

Un codice più elegante può derivare anche da strumenti migliori. All’inizio di quest’anno Meta ha rilasciato una versione aggiornata di PyTorch, un framework per la programmazione AI. Consentendo ai codificatori di riflettere maggiormente sul modo in cui le computazioni sono disposte sul chip reale, può raddoppiare la velocità di addestramento di un modello aggiungendo una sola riga di codice.

Modular, una startup fondata da ex ingegneri di Apple e Google, il mese scorso ha rilasciato un nuovo linguaggio di programmazione incentrato sull’intelligenza artificiale chiamato Mojo, basato su Python. Anch’esso consente ai programmatori di controllare ogni sorta di dettaglio che prima era nascosto. In alcuni casi, il codice scritto in Mojo può essere eseguito migliaia di volte più velocemente dello stesso codice in Python.

Migliorare i chip che eseguono il codice

Un’ultima opzione è quella di migliorare i chip su cui viene eseguito il codice. Le GPU sono buone solo accidentalmente per l’esecuzione di software di intelligenza artificiale: sono state originariamente progettate per elaborare la grafica sofisticata dei videogiochi moderni. In particolare, secondo un ricercatore hardware di Meta, le GPU sono progettate in modo imperfetto per il lavoro di “inferenza” (cioè l’esecuzione di un modello una volta addestrato). Alcune aziende stanno quindi progettando il proprio hardware più specializzato. Google gestisce già la maggior parte dei suoi progetti di intelligenza artificiale sui suoi chip “TPU” interni. Meta, con le sue MTIA, e Amazon, con i suoi chip Inferentia, stanno seguendo un percorso simile.

Conclusioni

Il fatto che si possano ottenere aumenti di prestazioni così consistenti da modifiche relativamente semplici, come l’arrotondamento dei numeri o il cambio di linguaggio di programmazione, può sembrare sorprendente. Ma riflette la velocità con cui sono stati sviluppati gli LLM. Per molti anni si è trattato di progetti di ricerca e il semplice fatto di farli funzionare bene era più importante che renderli eleganti. Solo di recente sono diventati prodotti commerciali e di massa. La maggior parte degli esperti ritiene che ci sia ancora molto spazio per i miglioramenti.