Intelligenza artificiale generativa (Gen AI): oltre alle questioni etiche – ci si interroga se l’eccessivo sviluppo degli attuali sistemi di AI sostituiranno totalmente il lavoro umano – e se l’AI generativa possa rivelarsi una sfida soprattutto in termini di sicurezza informatica.

Indice degli argomenti:

Comprendere l’intelligenza artificiale per utilizzarla in modo appropriato

È indubbio che l’intelligenza artificiale abbia già dato vita a profondi cambiamenti in vari settori e i crescenti livelli di sofisticazione suggeriscono un possibile effetto rivoluzionario. Da considerare, comunque, che i casi d’uso vengono scoperti nel corso del tempo e – come accade per qualsiasi nuova tecnologia – prima di trovare il modo di impiegarla correttamente in una data industry, bisogna conoscerla a fondo.

Man mano che l’AI generativa diventa sempre più sofisticata, sarà ancora più difficile riconoscere ciò che è “umano” da ciò che è “artificiale”, come dimostrano le attuali versioni di GenAI in grado di superare il test di Turing. Da qui alcune domande sorgono spontanee: cosa fare quando non si riesce a distinguere l’umano dall’artificiale? Come ci si può fidare di identità, dati o comunicazioni?

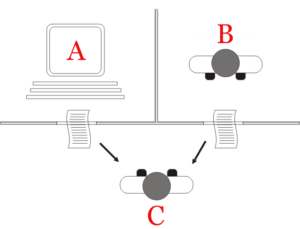

Per ovviare al problema, potrebbe essere adottata una mentalità “zero trust” in cui tutti gli utenti devono essere autenticati, autorizzati e continuamente convalidati. Il modo in cui l’AI si evolverà – e a quale velocità – è ancora da capire, ma nel frattempo ci sono alcune implicazioni attuali e potenziali per la cybersicurezza da tenere in considerazione.

Test di Turing

Aumento degli attacchi cyber su larga scala

Se si considera il contesto della cybersecurity, si nota che l’AI può essere uno strumento efficace se impiegato dai cybercriminali per aumentare il numero di attacchi. Infatti, la maggior parte delle operazioni di hacking viene eseguito manualmente, il che significa che gli eventi malevoli informatici su larga scala richiedono decine di persone.

I cosiddetti “Nation State Actor”, tra le maggiori minacce alla sicurezza informatica, hanno più probabilità di possedere le risorse per investire in una AI sofisticata al fine di scalare le incursioni informatiche. Ciò consentirebbe agli attori delle minacce di attaccare un maggior numero di obiettivi, aumentando potenzialmente le possibilità di trovare e sfruttare le vulnerabilità.

L’AI generativa richiede una continua supervisione

Non è da escludere la possibilità che utenti malintenzionati possano richiedere all’AI generativa di creare virus o truffe di phishing, anche se gli sviluppatori sostengono che la stessa non risponde a richieste di questo tipo. Tuttavia, gli hacker potrebbero essere in grado di trovare mezzi indiretti per persuadere la GenAI. È quindi necessario un regolare controllo sui suoi parametri per assicurarsi che non siano state sfruttate debolezze: la natura dinamica dell’AI richiede una continua supervisione.

Gli attori malintenzionati possono anche utilizzare l’AI generativa sfruttando l‘errore umano, uno dei principali responsabili delle falle nella sicurezza informatica. Questi soggetti potrebbero utilizzare l’AI per approfittare delle persone attraverso il social engineering, che si riferisce a un’ampia gamma di attività malevole che puntano sulla manipolazione psicologica attraverso le interazioni umane per indurre il target a violare la sicurezza. Le notevoli capacità di elaborazione del linguaggio naturale dell’AI generativa sono in grado quindi di perfezionare i tentativi di social engineering.

AI generativa alleata degli addetti alla sicurezza

Sebbene molti siano pronti a riconoscere i rischi potenziali dell’AI generativa, lo scopo che si intende raggiungere tramite la sua applicazione dipende ancora dall’uomo: un difensore della cybersecurity può utilizzarla come strumento di difesa, così come un cybercriminale potrebbe impiegarla per ideare e sferrare un attacco.

Inoltre, il fattore umano rimane ancora centrale per il successo delle violazioni: a dimostrarlo anche i risultati emersi dall’ultimo Data Breach Investigations Report (DBIR) di Verizon. Secondo l’indagine, infatti, ancora costituisce la causa della gran parte degli incidenti ed è responsabile del 74% delle violazioni, nonostante gli sforzi messi in atto dalle aziende in termini di protezione delle infrastrutture cruciali e il rafforzamento della formazione sui protocolli relativi alla cybersecurity. Le persone sono dunque suscettibili alle strategie di social engineering che l’AI generativa – guidata dai criminali tech – può effettuare su ampia scala. La capacità di aumentare in termini quantitativi le sofisticate frodi digitali espone sempre più cittadini, consumatori e imprese ai cyber crime. La minaccia è accentuata dall’evoluzione delle modalità di lavoro attuali che complicano la gestione delle credenziali di accesso dato che i lavoratori si alternano tra lo smart working e ufficio, e tra dispositivi professionali e personali.

Tale scenario conferma la necessità di un approccio alla cybersicurezza basato sul principio “verificare sempre, senza fidarsi” che riconosce la possibilità che le minacce alla sicurezza provengano da qualsiasi luogo, anche dall’interno di un’azienda stessa. L’approccio “zero trust” non solo richiede una rigorosa autenticazione degli utenti, ma prevede lo stesso grado di verifica anche per applicazioni e infrastrutture – tra cui la supply chain, il cloud, gli switch e i router.

Sebbene la costruzione di strutture fondate sul principio dello “zero trust” e l’adozione di tecnologie a supporto della difesa richieda un impegno significativo, l’intelligenza artificiale potrebbe semplificare notevolmente il processo.

Conclusioni

In altre parole, la tecnologia non è da considerarsi meramente come una minaccia estesa, bensì come uno strumento utile anche ad agevolare la realizzazione di ampi protocolli di sicurezza necessari per tenere a bada tali attacchi. La differenza risiede dunque nello scopo di impiego.