Al netto delle percepite implicazioni negative provocate dai sistemi di intelligenza artificiale, come fonte di incontrollabili discriminazioni su vasta scala, in realtà, tale tecnologia, tra i presunti benefici offerti, potrebbe ridurre i pregiudizi umani che tendono a manifestarsi per la selezione dei lavoratori da assumere nelle procedure di reclutamento del personale: lo rivela un articolo di approfondimento de “The Wall Street Journal”, secondo cui, lungi dal provocare una pericolosa contrazione della forza lavoro assorbita dai processi algoritmici di automatizzazione delle attività, i sistemi di AI sarebbero in grado di aiutare le aziende a prendere decisioni più veloci ed eque per la scelta del personale da assumere.

Mentre nella prassi tecnologica il dibattito si intensifica sulle possibili prospettive di implementazione dei sistemi di AI, sul versante legislativo, negli Usa è stato ufficialmente presentato il disegno di legge “Algorithmic Accountability Act”.

Indice degli argomenti:

Algorithmic Accountability Act

La proposta mira a garantire la trasparenza e la supervisione dei software, degli algoritmi e degli altri sistemi automatizzati, mediante l’istituzione di un archivio pubblico dei casi monitorati predisposto presso la Federal Trade Commission, ponendo altresì a carico delle aziende che si avvalgono di tali strumenti, l’obbligo di effettuare preliminarmente valutazioni d’impatto sui possibili rischi esistenti, nell’ottica di assicurare, in funzione preventiva, una tutela effettiva dai possibili pregiudizi provocati dagli algoritmi decisionali automatizzati, sull’assunto che l’uso di qualsivoglia tecnologia di AI, ove difettosa, potrebbe determinare impercettibili discriminazioni a discapito delle persone, soprattutto se si tratta di minoranze, soggetti emarginati e a rischio di esclusione sociale.

Gli errori di programmazione possono, infatti, rafforzare una discriminazione sociale già esistente, amplificando i pregiudizi sessuali, razziali ed etnici con il rischio di rendere più inique le relazioni umane, senza l’adozione di adeguate politiche di responsabilizzazione in grado di favore l’uso consapevole e sostenibile delle tecnologie.

In particolare, poiché i sistemi automatizzati sono sempre più utilizzati nella società per prendere decisioni “critiche” in rilevanti settori per la vita delle persone (salute, finanze, alloggi, opportunità educative, ecc.), esponendo potenzialmente gli individui a inediti gravi rischi da algoritmi difettosi o distorti, in assenza di adeguate garanzie di tutela per proteggere gli utenti da tali pericoli, l’Algorithmic Accountability Act 2022 richiede alle aziende di valutare gli impatti del sistemi automatizzati che usano e vendono, fornendo ai consumatori complete informazioni funzionali a fare scelte consapevoli sull’automazione di decisioni critiche.

Eliminare i pregiudizi umani, un’opportunità per l’AI

L’eliminazione del giudizio umano, per definizione soggettivo e opinabile, talvolta destinato a sfociare, mediante pregiudizi “nascosti” e occultati nella mente umana, in valutazioni discrezionali del tutto arbitrarie dalla dubbia comprensione motivazionale ben oltre i limiti della tollerabile discrezionalità, costituirebbe quindi una potenziale opportunità positiva offerta dall’intelligenza artificiale che, sostituendosi ai tradizionali parametri applicati dagli uffici di recruiting nella selezione del personale, metterebbe a disposizione l’utilizzo di algoritmi sempre più efficaci e sofisticati per la scelta asettica e neutra dei lavoratori ritenuti più adeguati alle mansioni da espletare all’interno dell’organizzazione aziendale.

A differenza dei responsabili “umani” incaricati della fase di reclutamento del personale, che potrebbero inconsciamente “affezionarsi” ai candidati più vicini ai propri orientamenti personali, o farsi guidare da fattori egoistici di tipo “clientelare” da cui discendono abusivi “favoritismi”, con il risultato di alterare quindi l’esito finale della relativa procedura, infatti, i software tecnologici consentirebbero di automatizzare le risposte fornite nel corso dei colloqui, per definire un ideale “identikit” dei lavoratori migliori da assumere con caratteristiche più eque, complete e pertinenti alle esigenze delle aziende interessate all’assunzione.

I pregiudizi delle tecnologie

Vero è che, allo stato attuale, sono frequenti i casi di distorsioni discriminatorie provocate dall’applicazione di tecnologie emergenti, al punto da rendere comprensibili le particolari cautele di fronte alla possibile diffusione di sistemi automatizzati di AI: emblematico, ad esempio, quanto accaduto in passato all’interno di Amazon.com, ove sarebbe stato scartato un algoritmo sperimentale destinato a migliorare la selezione dei migliori talenti da assumere, che poi invece avrebbe escluso dalla selezione dei candidati i curricula recanti riferimenti a frequentazioni di college femminili o a club femminili, alimentando dubbi sulle implicazioni “sessiste” codificate nella programmazione applicativa di tali sistemi.

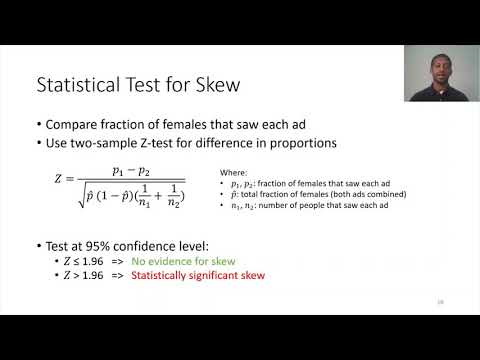

Parimenti preoccupanti risultano poi le evidenze dello studio “Auditing for Discrimination in Algorithms Delivering Job Ads”, secondo cui la pubblicità “personalizzata” utilizzata nei social network per ottenere target “mirati” di utenti potrebbe essere “distorta dal sesso o dalla razza a causa dell’ottimizzazione algoritmica nascosta da parte delle piattaforme, anche quando ciò non sia direttamente richiesto dagli inserzionisti”, determinando rilevanti effetti discriminatori nell’offerta degli annunci di lavoro disponibili online, con differenze significative nella fruizione dei relativi risultati soprattutto a discapito delle categorie protette e delle donne, escluse dalla visualizzazione delle opportunità professionali indipendentemente dalle loro qualifiche.

Video Auditing for Discrimination in Algorithms Delivering Job Ads

L’AI per valutare la personalità dei candidati

Se, da un lato, sono evidenti criticità degli algoritmi, in grado di discriminare gli annunci per età, sesso, razza, con il rischio di rafforzare, piuttosto che ridurre, i tradizionali pregiudizi legati a irragionevoli e discutibili stereotipi lavorativi, da cui discende un negativo impatto predittivo sul mercato del lavoro, come si evince dal documento “Discrimination in the Age of Algorithms”, al contempo però, dall’altro lato, sembra trovare terreno fertile un progressivo sostegno alla corrente di pensiero sempre più favorevole allo sviluppo sperimentale di tecnologie AI per valutare, grazie allo svolgimento di colloqui automatizzati, la personalità dei candidati, soprattutto in relazione al possesso delle cd. “soft skills” per aiutare le aziende a trovare lavoratori che altrimenti potrebbero essere trascurati, a prescindere dal formale percorso di studio, dal voto finale di laurea, o da qualunque altro ulteriore feedback “tradizionale” che non necessariamente può essere in grado di riflettere le abilità effettive delle persone.

Conclusioni

In un momento storico di profondi mutamenti, ove si riscontra un endemico ritardo legislativo rispetto alla rapidità dell’innovazione tecnologica, si tende spesso a descrivere, in termini di criticità e aspetti problematici, le prospettive applicative delle tecnologie AI mediante lo sviluppo evolutivo dei sistemi decisionali automatizzati in grado di produrre forme massive di sorveglianza generale, unitamente al rischio di processare i dati personali oggetto di dilagante proliferazione e di incontrollabile discriminazione dagli effetti imprevedibili.

Senza disconoscere tali pericoli, stimolando la diffusione pervasiva delle tecnologie nel rispetto di standard sicuri ed etici, al fine di garantire un uso equo e sicuro dell’intelligenza artificiale a tutela dei consumatori, sarebbe auspicabile un approccio regolatorio più adeguato alle sfide attuali della “rivoluzione digitale”, senza amplificare, più del dovuto, i possibili pregiudizi prodotti dai sistemi di AI che, in fin dei conti, potrebbero essere non più insidiosi rispetto ai pregiudizi “umani” nascosti su cui si fondano gli attuali sistemi di funzionamento delle procedure decisionali rilevanti per la vita delle persone, come dimostrano numerosi dati, evidenze e casi di cronaca sulle conseguenze inique che subiscono gli individui a causa di valutazioni “umane” talvolta censurabili e non sempre scevre da addebiti di discriminazioni e da ingiustizie sociali.