ll NIST (National Institute of Standards and Technology), agenzia del governo degli Stati Uniti, sta sviluppando un framework per gestire meglio i rischi associati all’Artificial Intelligence (AI) per individui, organizzazioni e società, i.e. il cosiddetto NIST – Artificial Intelligence Risk Management Framework (AI RMF).

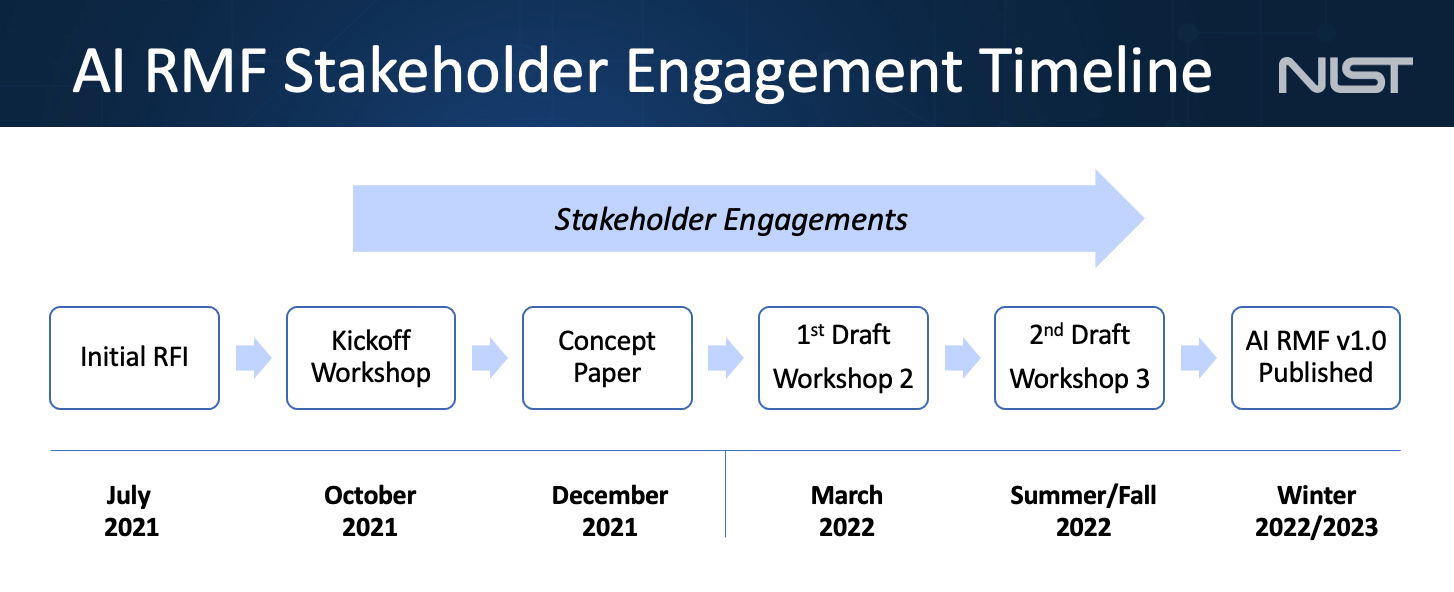

Lo scorso 17 marzo 2022 è stata pubblicata una bozza dell’AI RMF per la condivisione pubblica e la raccolta di commenti che dovranno essere fatti pervenire entro il 29 aprile p.v., in modo tale da pubblicare una seconda bozza del framework in estate o in autunno. La versione definitiva del framework è prevista a inizio 2023.

Indice degli argomenti:

Cos’è il NIST – Artificial Intelligence Risk Management Framework

La bozza del 17 marzo u.s. è scaturita dall’ampio contributo del settore privato e pubblico su una precedente richiesta di informazioni/commenti e recepito nel documento pubblicato lo scorso dicembre 2021.

Il NIST – AI RMF è destinato all’uso volontario e al miglioramento della capacità di incorporare considerazioni di affidabilità nella progettazione, nello sviluppo, nell’utilizzo e nella valutazione di prodotti, servizi e sistemi di AI.

Lo scopo della bozza è di promuovere lo sviluppo di approcci innovativi per affrontare le caratteristiche dell’affidabilità dell’AI, tra cui: accuratezza, spiegabilità e interpretabilità, affidabilità, privacy, robustezza, sicurezza (resilienza) e mitigazione di distorsioni non intenzionali e/o dannose o usi dannosi.

Il framework dovrà considerare e comprendere diversi principi, quali: trasparenza, responsabilità ed equità durante la fase di pre-progettazione, progettazione e sviluppo, distribuzione, utilizzo, test e valutazione di tecnologie e sistemi di AI.

Di fatto, l’insieme di queste caratteristiche e principi sono generalmente considerati la conditio sine qua non per l’affidabilità delle tecnologie e dei sistemi, dei prodotti e dei servizi di AI.

L’AI RMF è destinato a essere uno strumento in grado di integrare e assistere – con aspetti più ampi – la gestione del rischio a livello di organizzazioni, individui e gruppi. Ovvero, uno strumento utile che, pur utilizzando un linguaggio comprensibile da un vasto pubblico, mantiene una struttura tecnica sufficiente per essere di supporto sia a coloro che progettano, sviluppano, utilizzano o valutano le tecnologie di intelligenza artificiale sia ai professionisti. Dovrà necessariamente essere un framework scalabile per le organizzazioni di tutte le dimensioni, sia pubbliche sia private, appartenenti a qualsiasi settore e che operano sia sul territorio americano sia ad altre latitudini.

È doveroso ricordare che l’AI RMF non è una lista di controllo né un meccanismo di conformità da utilizzare isolatamente, bensì che dovrebbe essere integrato all’interno dell’organizzazione – quando si sviluppa e utilizza l’AI – ed essere incorporato nella gestione del rischio. Solo in questo modo sarà possibile garantire che i rischi dell’AI siano trattati insieme ad altri rischi critici, ottenendo, così, una gestione più integrata e una maggiore efficienza organizzativa.

Fonte: NIST

Le caratteristiche del NIST – AI RMF

Come si evince dal sito del NIST, si ritiene che l’AI RMF debba avere le seguenti caratteristiche:

- Essere guidato dal consenso, sviluppato e regolarmente aggiornato attraverso un processo aperto e trasparente

Ovvero, tutte le parti interessate dovranno contribuire allo sviluppo del framework che verrà modellato secondo il consolidato modello del NIST, basato su approcci aperti, trasparenti e collaborativi.

- Fornire definizioni comuni

Il framework dovrà: fornire definizioni e caratterizzare gli aspetti di rischio e d’affidabilità dell’IA che siano comuni e pertinenti per tutti i settori; stabilire una tassonomia comune dei rischi dell’IA, una terminologia e delle definizioni concordate, compresa quella della fiducia e dell’affidabilità.

- Utilizzare un linguaggio semplice

È necessaria l’adozione di un linguaggio che sia comprensibile da un vasto pubblico, pur mantenendo tecnicismi sufficienti per un più diretto approccio da parte ai professionisti di AI.

- Essere adattabile a diverse organizzazioni, tecnologie che si basano sull’AI, fasi del ciclo di vita, settori e usi

Il framework dovrà essere scalabile per le organizzazioni di tutte le dimensioni, sia pubbliche sia private, appartenenti a qualsiasi settore e che operano all’interno o oltre i confini nazionali. Inoltre, esso dovrebbe essere sia indipendente dalla piattaforma e dalla tecnologia utilizzata ed essere personalizzabile sia capace di soddisfare le esigenze di progettisti, sviluppatori, utenti e valutatori di AI.

- Essere basato sul rischio, focalizzato sui risultati, volontario e non prescrittivo

Il framework dovrà concentrarsi sul valore dell’affidabilità e sulle relative esigenze, capacità e risultati, fornendo un insieme di risultati e approcci da utilizzare volontariamente, piuttosto che una serie di requisiti universali, al fine di: promuovere l’innovazione nella progettazione, nello sviluppo, nell’uso e nella valutazione di sistemi di AI affidabili e responsabili; garantire l’istruzione e lo sviluppo della forza lavoro; promuovere la ricerca e l’adozione di soluzioni efficaci. Esso dovrà aiutare coloro che progettano, sviluppano, utilizzano e valutano l’AI a gestire meglio i rischi dell’AI per i casi d’uso o gli scenari previsti.

- Essere facilmente utilizzabile

Il framework dovrà essere parte della più ampia strategia e dei processi di gestione del rischio di qualsiasi azienda e facilmente utilizzabile.

- Essere coerente, per quanto possibile, con altri approcci alla gestione del rischio di AI

Il framework dovrà, ove possibile, trarre vantaggio e fornire una maggiore consapevolezza delle norme, degli orientamenti, delle migliori pratiche, delle metodologie e degli strumenti esistenti per la gestione dei rischi dell’AI. Inoltre, esso dovrà essere indipendente dalle normative e dai regolamentazioni vigenti in modo da supportare le organizzazioni ad essere conformi ai quadri legislativi e/o normative nazionali e internazionali.

- Essere un documento “vivente”

Il framework dovrà essere sine die, ovvero, in grado di essere prontamente aggiornato man mano che la tecnologia, la comprensione e gli approcci all’affidabilità e agli usi dell’AI cambiano e le parti interessate possono fare leva sulle lesson learned scaturite della gestione del rischio dell’AI.

Video: Artificial Intelligence Seminar: Emerging Capabilities of AI-Enabled Intelligent Agents – NIST

A che punto siamo in Europa?

Anche la Commissione Europea si sta adoperando per stabilire un approccio di gestione dei rischi della AI e lo scorso 21 aprile 2021 ha proposto il suo primo quadro giuridico, in termini di “Regolamento su un approccio europeo per l’intelligenza artificiale” – con l’obiettivo di convertirsi nel polo mondiale di un’AI affidabile e definire le applicazioni ad alto rischio, gli obblighi normativi per i fornitori di sistemi di AI, la sorveglianza post-commercializzazione dell’AI, la valutazione della conformità di alta applicazioni AI rischiose e la possibile creazione di un nuovo board sull’AI. Tale proposta dovrebbe convertirsi in Regolamento nel 2023.

Il nuovo quadro giuridico mira a definire un insieme di norme possiamo spianare la strada a una tecnologia etica in tutto il mondo e garantire che l’UE rimanga competitiva. Le regole saranno adeguate alle esigenze future e favorevoli all’innovazione e interverranno ove strettamente necessario: quando sono in gioco la sicurezza e i diritti fondamentali dei cittadini dell’UE.

Ovvero come per il NIST- AI RMF, si tratta di sfruttare le potenzialità dell’AI in tanti diversi settori, pur monitorando e gestendo i rischi che questa tecnologia comporta.

In particolare, il quadro Eu si prefigge di garantire un approccio univoco basato sul rischio e differenzia gli usi dell’AI a seconda che creino un rischio inaccettabile, un rischio elevato, un rischio limitato o un rischio minimo. Inoltre, prevede attenti controlli dei sistemi di AI ad “alto rischio”, atti a verificare la avvenuta conformità a obblighi, quali:

- adeguati sistemi di valutazione e mitigazione dei rischi;

- set di dati di alta qualità in modo da minimizzare i rischi e gli esiti discriminatori;

- tracciabilità dei dati attraverso registrazione delle attività;

- documentazione informativa dettagliata in termini di sistema e scopo, in modo tale da permetterne la verifica della conformità da parte delle Autorità preposte, sia ex-ante sia ex-post il lancio sul mercato;

- minimizzazione dei rischi tramite adeguate misure di sorveglianza “umana”;

- elevato livello di robustezza, sicurezza e accuratezza.

Da quanto sopra si evince che il Regolamento Europeo sull’AI è un’ulteriore prova della necessità di una modifica all’approccio al rischio in un ambito di innovazione tecnologica basata su sistemi di AI.

È doveroso ricordare che l’applicazione di normative sull’AI simili da parte di più governi può contribuire ad aumentare le probabilità di ridurre i peggiori reati da parte delle imprese internazionali. Inoltre, priorità governative coerenti inviano un chiaro segnale alla società civile e alle comunità accademiche nell’UE e negli Stati Uniti, indirizzando le indagini e la ricerca su preoccupazioni condivise.

AI e problematiche legate all’etica

L’utilizzo delle capacità dell’AI ha portato a una vasta gamma di innovazioni. I nuovi sistemi abilitati dall’AI hanno un impatto positivo su molti settori della società e dell’economia. Allo stesso tempo, le nuove tecnologie, i prodotti e i servizi basati sull’AI comportano sfide e rischi tecnici e sociali; ne consegue che diventa necessario garantire che l’AI sia anche etica.

Sebbene non esista uno standard oggettivo per i valori etici – dato che essi sono fondati sulle norme e sulle aspettative legali di società o culture specifiche – l’AI deve essere progettata, sviluppata, utilizzata e valutata in modo affidabile e responsabile per promuoverne la fiducia, ovvero, assicurando che i sistemi di AI siano consapevoli e costruiti per allinearsi con i valori fondamentali della società, in modo da ridurre al minimo i danni a individui, gruppi, comunità e società in generale.

Inoltre, è doveroso ricordare che l’AI non è destinata a sostituire in toto i vari attori della nostra società; ne consegue che dobbiamo garantire un’AI umano-centrica che, grazie a quadri normativi più strutturati, chiari ed efficienti sia in grado di gestire i risvolti etici & giuridici e garantire la salute e i diritti di ognuno di noi. Pertanto, l’AI dovrà diventare necessariamente “trustworthy”; i prodotti e i servizi dovranno essere basati su dati sicuri; le basi di dati su cui saranno addestrati gli algoritmi dovranno essere prive di bias e il loro funzionamento non più opaco, bensì trasparente e spiegabile. Si tratta, quindi, di perseguire uno sviluppo tecnologico intelligente “umano-centrico”, a misura di democrazia e diritti individuali e sociali.

Foto: NIST

Conclusioni

Sia il NIST – AI RMF sia il Regolamento EU evidenziano la necessità di integrare la gestione del rischio direttamente nella fase progettuale dei modelli di AI, in modo che la supervisione sia costante e simultanea con lo sviluppo interno e il provisioning esterno dell’AI in tutta l’organizzazione. Ovvero, come definito dalla società di consulenza McKinsey, una modalità di “derisking AI by design” per consentire agli sviluppatori e agli loro stakeholder aziendali di creare sistemi di intelligenza artificiale coerenti con i valori dell’organizzazione e la propensione al rischio utilizzando strumenti come interpretabilità del modello, rilevamento di bias e monitoraggio delle prestazioni in modo tale da garantire la supervisione costante e coerente in tutte le varie fasi del ciclo di vita del modello di AI.

Di fatto, un uso maggiormente consapevole dell’innovazione tecnologica implica sia una morale delle diverse tecnologie sia il saperne indirizzare gli effetti e le funzioni verso uno scopo responsabilmente compreso e assunto.

Concludendo, le richieste pubbliche di commenti alla bozza del AI RMF sono importanti per stimolare ulteriori discussioni e raccogliere una varietà di punti di vista su ciò che costituisce il rischio e l’affidabilità dell’AI, stabilendo il giusto equilibrio tra i vantaggi della tecnologia e la gestione dei rischi che la tecnologia comporta. Ovvero, si tratta di trovare risposte alle preoccupazioni e recepire i suggerimenti in termini di diritti e libertà civili ed equità. Inoltre, si tratterà sempre più di massimizzare l’efficacia del framework attraverso il riutilizzo delle metodologie esistenti oltre ad accelerare ulteriormente l’adozione della gestione del rischio dell’AI e, al contempo, comprendere i potenziali danni diretti individuali e sociali.