I foundation model, come ChatGPT, stanno trasformando la società con le loro notevoli capacità, i gravi rischi, la rapida diffusione, l’adozione senza precedenti e le infinite controversie. Contemporaneamente, l’Unione Europea (UE) sta portando a termine la sua legge AI Act, la prima normativa completa al mondo che regola l’intelligenza artificiale. La legge prevede obblighi espliciti per i fornitori di foundation model come OpenAI e Google.

I ricercatori della Stanford University hanno svolto un lavoro per capire se e quanto i foundation model attuali siano conformi al dettato dell’AI Act, nella forma in cui è stato approvato dal Parlamento europeo. La legge non solo imporrà requisiti per l’AI nell’UE, con i suoi 450 milioni di abitanti, ma costituirà anche un precedente per la regolamentazione dell’AI in tutto il mondo (il cosiddetto effetto Bruxelles). I politici di tutto il mondo si stanno già ispirando alla legge sull’AI e le aziende multinazionali potrebbero modificare le loro pratiche globali per mantenere un unico processo di sviluppo dell’AI. Il modo in cui saranno regolati i foundation model strutturerà la più ampia catena di fornitura digitale e darà forma all’impatto sociale della tecnologia.

I fornitori di questi modelli raramente divulgano informazioni adeguate sui dati, sul calcolo e sull’implementazione dei loro modelli, nonché sulle caratteristiche chiave dei modelli stessi. In particolare, i fornitori in genere non rispettano i requisiti della bozza per descrivere l’uso di dati di formazione protetti da copyright, l’hardware utilizzato e le emissioni prodotte nella formazione, e come valutano e testano i modelli.

Di conseguenza, i ricercatori raccomandano ai responsabili politici di dare priorità alla trasparenza, sulla base dei requisiti dell’AI Act. La loro valutazione dimostra che è attualmente possibile per i fornitori foundation model conformarsi all’AI Act e che la divulgazione relativa allo sviluppo, all’uso e alle prestazioni dei foundation model migliorerebbe la trasparenza dell’intero ecosistema.

Indice degli argomenti:

Qual è la condotta attuale dei fornitori di foundation model?

La valutazione dei ricercatori di Stanford stabilisce i fatti sullo status quo e motiva gli interventi futuri.

- Status quo. Qual è la condotta attuale dei fornitori di foundation model? E, di conseguenza, in che modo la legge europea sull’AI (quando sarà promulgata e applicata) cambierà lo status quo? La ricerca si concentra in particolare sui requisiti che attualmente mancano ai fornitori.

- Interventi futuri. Per i responsabili politici dell’UE, dove la legge sull’AI è è insufficiente rispetto ai foundation model? I responsabili politici, a livello globale, come dovrebbero cambiare le loro priorità sulla base dei risultati della ricerca? E per i fornitori di foundation model, come dovrebbero evolvere le loro pratiche commerciali per essere più responsabili? Nel complesso, la ricerca sottolinea che la trasparenza dovrebbe essere la prima priorità per responsabilizzare i fornitori di foundation model.

La metodologia impiegata dai ricercatori di Stanford

Identifica, categorizza, sintetizza e ricava i requisiti dalla bozza di legge sull’AI adottata dal Parlamento europeo

Di seguito è riportata una sintesi dell’approccio, con tutti i dettagli relativi ai documenti di riferimento.

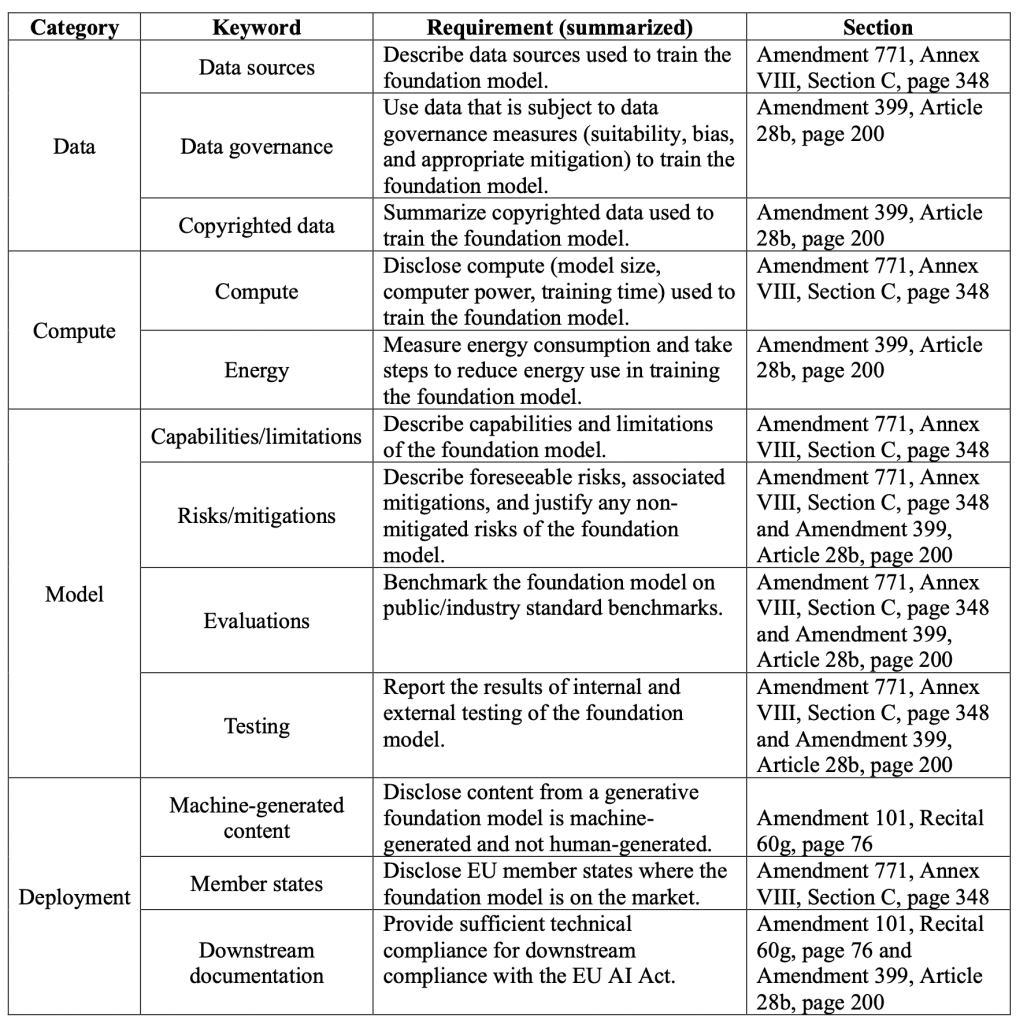

- Dalla versione del Parlamento europeo della legge sono stati estratti 22 requisiti rivolti ai fornitori di foundation model. Selezioniamo 12 dei 22 requisiti da valutare: questi requisiti sono in grado di essere valutati in modo significativo utilizzando le informazioni pubbliche.1

- Sono stati classificati i 12 requisiti come relativi a (i) risorse di dati (3), (ii) risorse di calcolo (2), (iii) il modello stesso (4) o (iv) pratiche di distribuzione (3). Molti di questi requisiti sono incentrati sulla trasparenza: per esempio, la divulgazione di quali dati sono stati utilizzati per addestrare il modello di base, come il modello si comporta su benchmark standard e dove viene distribuito. Riassumiamo i 12 requisiti nella tabella precedente.

- Per ognuno dei 12 requisiti è stata elaborata una griglia di valutazione a 5 punti. Sebbene la legge stabilisca obblighi di alto livello per i fornitori di foundation model, non precisa come questi obblighi debbano essere interpretati o applicati. Le rubriche derivano dall’esperienza sull’impatto sociale dei foundation model. Queste rubriche possono informare direttamente l’interpretazione della legge o degli standard, anche nelle aree in cui il linguaggio della legge è particolarmente poco chiaro.

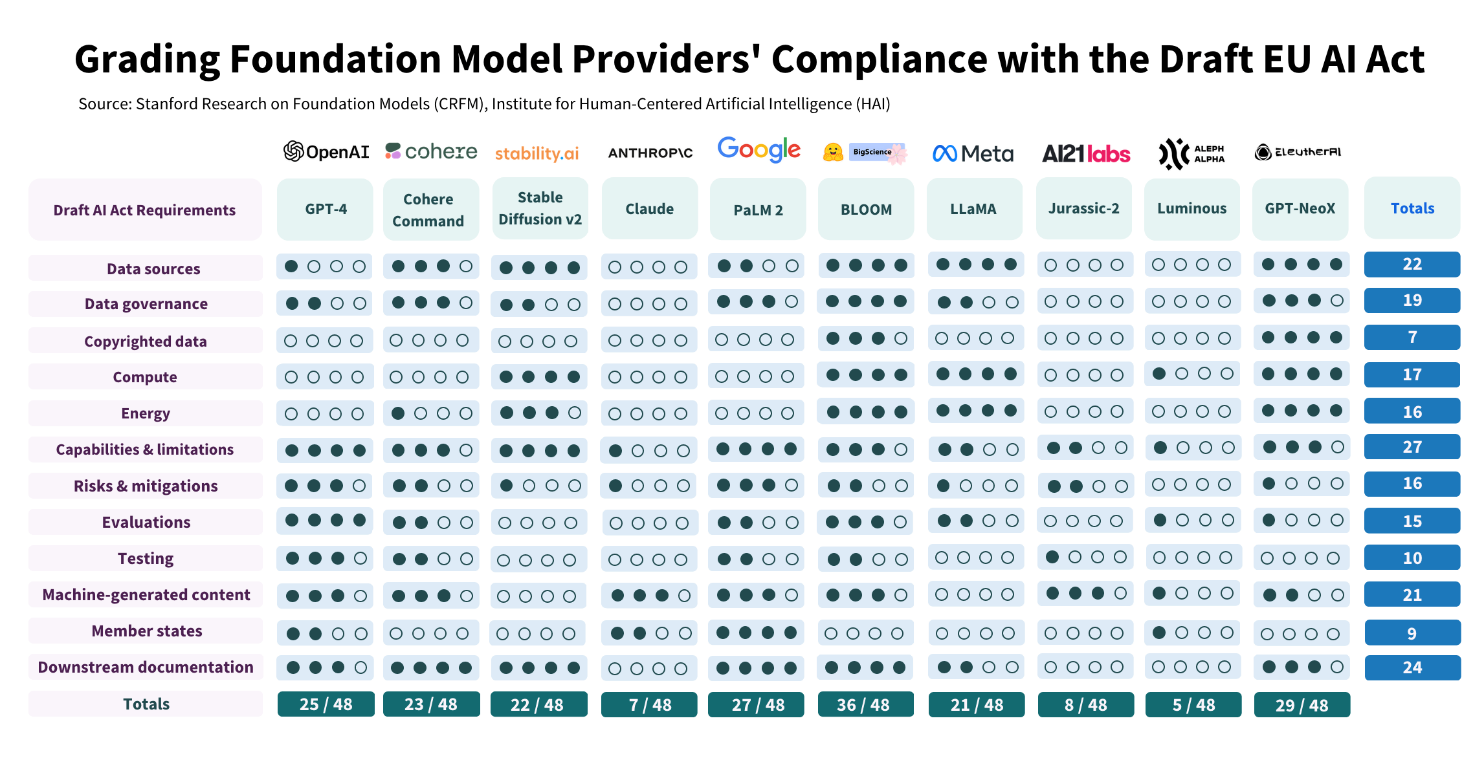

- È stata valutata la conformità di dieci fornitori di foundation model – e dei loro modelli di di punta – con 12 dei requisiti della legge per i foundation model sulla base delle rubriche. I due autori principali della ricerca hanno valutato in modo indipendente tutti i fornitori per tutti i requisiti, con una sostanziale concordanza tra gli autori (Kappa di Cohen = 0,74). Infine, i punteggi sono stati uniti attraverso una discussione di gruppo con tutti gli autori coinvolti nel lavoro. Anche se la valutazione completa della conformità a questi requisiti richiederà ulteriori indicazioni da parte dell’UE, la ricerca sulle pratiche attuali dei fornitori svolgerà un ruolo prezioso quando le autorità di regolamentazione valuteranno la conformità.

AI Act foundation model: i risultati della ricerca di Stanford

Nella figura sono visibili i punteggi finali, con la giustificazione di ogni voto resa disponibile. I risultati dimostrano un’impressionante differenza di conformità tra i fornitori di modelli: alcuni fornitori ottengono un punteggio inferiore al 25% (AI21 Labs, Aleph Alpha, Anthropic) e solo un fornitore ottiene almeno il 75% (Hugging Face/BigScience) al momento. Anche per i fornitori che hanno ottenuto i punteggi più alti, c’è ancora un significativo margine di miglioramento. Ciò conferma che la legge (se promulgata, rispettata e applicata) apporterebbe cambiamenti significativi all’ecosistema, compiendo progressi sostanziali verso una maggiore trasparenza e responsabilità.

Sfide persistenti. Vediamo quattro aree in cui molte organizzazioni ricevono punteggi scarsi (generalmente 0 o 1 su 4). Si tratta di (i) dati protetti da copyright, (ii) calcolo/energia, (iii) mitigazione del rischio e (iv) valutazione/test. Si tratta di temi consolidati nella letteratura scientifica:

- Responsabilità non chiara a causa del copyright. Pochi fornitori rivelano informazioni sullo stato del copyright dei dati di addestramento. Molti foundation model vengono addestrati su dati raccolti da Internet, una parte consistente dei quali è probabilmente protetta da copyright. La validità legale dell’addestramento su questi dati come questione di fair use, specialmente per i dati con licenze specifiche, e della riproduzione di questi dati, rimane poco chiara.

- Segnalazione disomogenea dell’uso dell’energia. I fornitori di foundation model riportano in modo incoerente l’utilizzo di energia, le emissioni, le loro strategie di misurazione delle emissioni e le misure adottate per mitigarle. Le modalità di misurazione dell’energia richiesta per l’addestramento dei foundation model sono controverse (Strubell et al., 2019Patterson et al., 2021). In ogni caso, la rendicontazione di questi costi si rivela inaffidabile, nonostante i numerosi sforzi che hanno costruito strumenti per facilitare tale rendicontazione (Lacoste et al., 2019; Henderson et al., 2020; Luccioni et al., 2023).

- Inadeguata divulgazione della mitigazione/non mitigazione del rischio. Il panorama dei rischi per i foundation model è immenso, e comprende molte forme di utilizzo doloso, danni non intenzionali e rischi strutturali o sistemici (Bender et al., 2021); Bommasani et al., 2021; Weidinger et al., 2021). Mentre molti fornitori di foundation model enumerano i rischi, relativamente pochi rivelano le misure di mitigazione che implementano e l’efficacia di tali misure. La legge richiede anche che i fornitori descrivano “i rischi non mitigati con una spiegazione del motivo per cui non possono essere mitigati”, cosa che nessuno dei fornitori da noi valutati fa.

- Assenza di standard di valutazione/ecosistema di audit. I fornitori di foundation model raramente misurano le prestazioni dei modelli in termini di danni intenzionali, come l’uso doloso, o di fattori come la robustezza e la calibrazione. Molti nella comunità hanno chiesto un maggior numero di valutazioni, ma gli standard per la valutazione dei foundation model (soprattutto per quanto riguarda i modelli linguistici) rimangono un work-in-progress (Liang et al., 2022), Bommasani et al., 2023, Solaiman et al., 2023). Negli Stati Uniti, il mandato al NIST di creare banchi di prova per l’IA ai sensi della sezione 10232 del CHIPS and Science Act identifica un percorso verso tali standard.

Modelli aperti o limitati/chiusi. Troviamo una chiara dicotomia nella conformità in funzione della strategia di rilascio, ovvero della misura in cui i fornitori di foundation model rendono i loro modelli pubblicamente disponibili. Attualmente, i fornitori di foundation model adottano una varietà di strategie di rilascio, senza norme stabilite. Sebbene le strategie di rilascio non siano binarie ed esistano su uno spettro, per semplicità consideriamo i rilasci ampiamente aperti (ad esempio GPT-NeoX di EleutherAI, BLOOM di Hugging Face/BigScience, LLaMA di Meta) rispetto a quelli ristretti/chiusi (ad esempio PaLM 2 di Google, GPT-4 di OpenAI, Claude di Anthropic). I rilasci aperti ottengono generalmente punteggi elevati per quanto riguarda i requisiti di divulgazione delle risorse (sia dati che calcolo), con EleutherAI che riceve 19/20 per queste categorie. Tuttavia, tali rilasci aperti rendono difficile il monitoraggio o il controllo della distribuzione, mentre rilasci più ristretti/chiusi portano a punteggi migliori sui requisiti relativi alla distribuzione. Ad esempio, il PaLM 2 di Google riceve 11/12 per la diffusione. Sottolineiamo che i responsabili politici dell’UE dovrebbero prendere in considerazione il rafforzamento dei requisiti di diffusione per le entità che immettono sul mercato i foundation model, per garantire una sufficiente responsabilità lungo la catena di fornitura digitale.

La relazione tra il rilascio e la conformità specifica dell’area è in qualche modo in linea con le intuizioni dei ricercatori. I rilasci aperti sono spesso effettuati da organizzazioni che enfatizzano la trasparenza, il che porta a un impegno simile nel divulgare le risorse necessarie per costruire i loro modelli di base. I rilasci limitati o chiusi, invece, coincidono spesso con i modelli che alimentano i prodotti e i servizi di punta del fornitore, il che significa che le risorse alla base del modello possono essere viste come un vantaggio competitivo (ad esempio, la decomposizione dei dati) o una responsabilità (ad esempio, i dati protetti da copyright). Inoltre, l’open-sourcing di un modello rende molto più difficile monitorare o influenzare l’uso a valle, mentre le API o l’accesso mediato dagli sviluppatori forniscono mezzi più semplici per un accesso strutturato.

Fattibilità complessiva della conformità. Nessun fornitore di foundation model raggiunge un punteggio perfetto, con ampi margini di miglioramento nella maggior parte dei casi. Pertanto, valutiamo se sia attualmente possibile per le organizzazioni conformarsi completamente a tutti i requisiti. Sebbene riteniamo che con incentivi sufficienti (ad esempio, multe per la mancata conformità) le aziende modificheranno la loro condotta, anche in assenza di una forte pressione normativa, molti fornitori potrebbero raggiungere punteggi complessivi tra i 30 e i 40 anni attraverso cambiamenti significativi, ma plausibili. Per essere concreti, il massimo di ingresso tra OpenAI e Hugging Face/BigScience è 42 (quasi il 90% di conformità). Concludiamo che l’applicazione di questi 12 requisiti della legge porterebbe a un cambiamento sostanziale, pur rimanendo alla portata dei fornitori.

I rilasci dei foundation model sono diventati generalmente meno trasparenti, come dimostrano i principali rilasci degli ultimi mesi. I rapporti per GPT-4 di OpenAI e PaLM 2 di Google dichiarano apertamente che non riportano molti aspetti rilevanti su dati e calcolo. Il documento di GPT-4 recita: “Dato il panorama competitivo e le implicazioni per la sicurezza di modelli su larga scala come GPT-4, questo rapporto non contiene ulteriori dettagli sull’architettura (comprese le dimensioni del modello), sull’hardware, sul calcolo dell’addestramento, sulla costruzione del set di dati, sul metodo di addestramento o simili”.

Una trasparenza sufficiente a soddisfare i requisiti della Legge relativi ai dati, ai calcoli e ad altri fattori dovrebbe essere commercialmente fattibile se i fornitori di foundation model agiscono collettivamente come risultato di standard o regolamenti del settore. Non vi sono ostacoli significativi che impediscano a ogni fornitore di migliorare il modo in cui discute i limiti e i rischi e di riferire sui parametri di riferimento standard. Sebbene l’open-sourcing possa rendere impegnativi alcuni aspetti della divulgazione dell’implementazione, i miglioramenti fattibili nella divulgazione dei contenuti generati dalle macchine o nella disponibilità della documentazione a valle sono numerosi. Sebbene i progressi in ciascuna di queste aree richiedano un certo lavoro, in molti casi i ricercatori ritengono che questo lavoro sia minimo rispetto alla costruzione e alla fornitura del modello di base e dovrebbe essere considerato un prerequisito per essere un fornitore di modelli responsabile e rispettabile.

Le raccomandazioni dei ricercatori di Stanford

Le raccomandazioni sono rivolte a tre parti:

- ai responsabili politici dell’UE che lavorano alla legge sull’AI dell’UE,

- ai responsabili politici globali che lavorano alla politica sull’AI

- ai fornitori di foundation model che operano nell’ecosistema.

I responsabili politici dell’UE

- L’attuazione della legge europea sull’AI e gli standard tecnici che seguiranno dovrebbero specificare le aree della legge non specificate. Data l’esperienza nelle valutazioni, si sottolinea l’importanza di specificare quali dimensioni delle prestazioni sono necessarie da divulgare per soddisfare il mandato di una “descrizione delle prestazioni del modello”. I ricercatori si dicono favorevoli a considerare necessari per la conformità diversi fattori come l’accuratezza, la robustezza, l’equità e l’efficienza (il NIST AI Risk Management Framework fornisce un elenco simile).

- L’AI Act dell’UE dovrebbe prendere in considerazione ulteriori fattori critici per garantire un’adeguata trasparenza e responsabilità dei fornitori di foundation model, tra cui la divulgazione dei modelli di utilizzo: tali requisiti rispecchierebbero le relazioni di trasparenza per le piattaforme online, la cui mancanza è stata un inibitore cronico per una politica efficace delle piattaforme. Dobbiamo capire come vengono utilizzati i foundation model (ad esempio per fornire consulenza medica, preparare documenti legali) per chiedere conto ai loro fornitori. Incoraggiamo i politici a prendere in considerazione la possibilità di applicare questi requisiti solo ai fornitori di foundation model più influenti, rispecchiando direttamente il modo in cui la legge sui servizi digitali dell’UE pone requisiti speciali alle piattaforme online molto grandi per evitare di sovraccaricare le aziende più piccole.

- Affinché l’applicazione della legge UE sull’AI cambi la condotta delle potenti organizzazioni che costruiscono i foundation model, l’UE deve mettere a disposizione delle agenzie di controllo le risorse tecniche e i talenti necessari, soprattutto in considerazione del più ampio ecosistema di controllo dell’IA previsto dalla legge. Il nostro processo di valutazione ha chiarito che le competenze tecniche sui foundation model sono necessarie per comprendere questo complesso ecosistema.

I responsabili delle politiche globali

- La trasparenza dovrebbe essere la prima priorità per gli sforzi politici: è un prerequisito essenziale per una scienza rigorosa, un’innovazione sostenuta, una tecnologia responsabile e una regolamentazione efficace. Questo lavoro dimostra che la trasparenza è attualmente disomogenea e che la legge europea sull’intelligenza artificiale porterà un chiaro cambiamento che la politica dovrebbe seguire altrove. La storia della regolamentazione dei social media fornisce chiari insegnamenti per i politici: non riuscire a garantire una sufficiente trasparenza delle piattaforme ha portato a molti dei danni dei social media; non dovremmo riprodurre questi fallimenti per la prossima tecnologia di trasformazione nei foundation model.

- La divulgazione dei dati di formazione protetti da copyright è l’area in cui, secondo la ricerca, i fornitori di foundation model ottengono la peggiore conformità. I legislatori, le autorità di regolamentazione e i tribunali dovrebbero chiarire in che modo il diritto d’autore riguarda (i) la procedura di formazione, comprese le condizioni in cui il diritto d’autore o le licenze devono essere rispettati durante la formazione, nonché le misure che i fornitori di modelli dovrebbero adottare per ridurre il rischio di violazione del diritto d’autore e (ii) l’output dei modelli generativi, comprese le condizioni in cui i contenuti generati dalle macchine violano i diritti dei creatori di contenuti nello stesso mercato.

Fornitori di foundation model

- Questo lavoro indica dove ogni fornitore di foundation model può migliorare. Evidenzia molti passi che rappresentano un frutto a portata di mano, come il miglioramento della documentazione messa a disposizione degli sviluppatori a valle che si basano sui foundation model. In diversi casi, alcuni fornitori ottengono punteggi peggiori di altri con strategie di rilascio simili (ad esempio, diversi fornitori che distribuiscono i loro foundation model tramite un’API). Pertanto, i fornitori possono e devono migliorare la conformità emulando fornitori simili che sono i migliori della categoria.

- I fornitori di foundation model dovrebbero lavorare per la definizione di standard industriali che aiutino l’intero ecosistema a diventare più trasparente e responsabile. Il processo di definizione degli standard dovrebbe coinvolgere le parti interessate al di là dei fornitori di foundation model, con particolare attenzione alle parti che possono rappresentare meglio l’interesse pubblico, come il mondo accademico e la società civile.

Limitazioni

Pur offrendo competenze sui foundation model, la lettura della bozza di legge data dai ricercatori non è una vera e propria interpretazione statutaria, anche se potrebbe essere d’aiuto (soprattutto nei casi in cui la legge non è chiara). La legge sull’AI è ancora in discussione e sarà finalizzata durante il prossimo trilogo tra Commissione, Consiglio e Parlamento dell’UE. I fornitori di modelli di base hanno anche dei requisiti ai sensi delle disposizioni della legge sull’AI che non riguardano solo i modelli di base, ad esempio quando questi sono integrati in sistemi di AI ad alto rischio. Pertanto, le nostre valutazioni potrebbero divergere dalla conformità dei fornitori di foundation model alla versione finale dell’AI Act. Dato che la valutazione si basa sulle informazioni pubblicamente disponibili ed è limitata da queste, si incoraggiano i fornitori di foundation model a fornire un feedback e a rispondere a questi punteggi.

Conclusioni

In conclusione, i ricercatori di Stanford riscontrano che i fornitori di foundation model non rispettano in modo uniforme i requisiti dichiarati nella bozza della legge europea sull’AI. L’attuazione e l’applicazione della legge comporterà un significativo cambiamento positivo nell’ecosistema dei foundation model. La conformità dei fornitori di foundation model ai requisiti in materia di copyright, energia, rischio e valutazione è particolarmente scarsa e indica le aree in cui i fornitori di modelli possono migliorare. La valutazione mostra un netto divario tra rilasci aperti e rilasci chiusi: tutti i fornitori possano migliorare la loro condotta, indipendentemente dalla loro posizione in questo spettro. Nel complesso, l’analisi si riferisce a una tendenza più ampia di diminuzione della trasparenza: i fornitori dovrebbero intervenire per definire collettivamente standard di settore che migliorino la trasparenza e i politici dovrebbero intervenire per garantire un’adeguata trasparenza alla base di questa tecnologia di uso generale.

Questo lavoro è solo l’inizio di un’iniziativa più ampia del Centro per la ricerca sui foundation model per valutare e migliorare direttamente la trasparenza dei fornitori di foundation model, a complemento degli sforzi di valutazione olistica, documentazione dell’ecosistema, sviluppo di norme, documenti politici e raccomandazioni politiche.

Gli autori della ricerca sono Rishi Bommasani, Kevin Klyman, Daniel Zhang e Percy Liang.