I modelli di linguaggio visivo (VLM) sono modelli di intelligenza artificiale che combinano capacità di visione artificiale e di elaborazione del linguaggio naturale (NLP). I VLM imparano a mappare le relazioni tra dati di testo e dati visivi come immagini o video, consentendo a questi modelli di generare testo da input visivi o di comprendere richieste di linguaggio naturale nel contesto di informazioni visive.

Combinano modelli di linguaggio di grandi dimensioni (LLM) con modelli di visione o algoritmi di apprendimento automatico visivo (ML).

Come sistemi di AI multimodali, i VLM prendono testo e immagini o video come input e producono testo come output, solitamente sotto forma di descrizioni di immagini o video, rispondendo a domande su un’immagine o identificando parti di un’immagine o oggetti in un video.

Indice degli argomenti:

Elementi di un modello linguistico di visione

I modelli linguistici di visione sono in genere costituiti da due componenti chiave:

● un codificatore linguistico

● un codificatore di visione

Codificatore linguistico

Un codificatore linguistico cattura il significato semantico e le associazioni contestuali tra parole e frasi e le trasforma in incorporamenti di testo che i modelli di intelligenza artificiale possono elaborare.

La maggior parte dei VLM utilizza un’architettura di rete neurale nota come modello di trasformatore per il proprio codificatore linguistico. Esempi di trasformatori includono BERT (Bidirectional Encoder Representations from Transformers) di Google, uno dei primi modelli di base che supportano molti degli LLM odierni, e il trasformatore preaddestrato generativo (GPT) di OpenAI.

Ecco una breve panoramica dell’architettura del trasformatore:

● I codificatori trasformano le sequenze di input in rappresentazioni numeriche chiamate incorporamenti che catturano la semantica e la posizione dei token nella sequenza di input.

● Un meccanismo di auto-attenzione consente ai trasformatori di “focalizzare la propria attenzione” sui token più importanti nella sequenza di input, indipendentemente dalla loro posizione.

● I decoder utilizzano questo meccanismo di auto-attenzione e gli embedding degli encoder per generare la sequenza di output statisticamente più probabile.

Codificatore visivo

Un codificatore visivo estrae proprietà visive vitali come colori, forme e texture da un’immagine o un input video e li converte in embedding vettoriali che i modelli di apprendimento automatico possono elaborare.

Le versioni precedenti dei VLM utilizzavano algoritmi di apprendimento profondo come reti neurali convoluzionali per l’estrazione di caratteristiche. I modelli di linguaggio visivo più moderni impiegano un trasformatore visivo (ViT), che applica elementi di un modello di linguaggio basato sul trasformatore.

Un ViT elabora un’immagine in patch e le tratta come sequenze, simili a token in un trasformatore di linguaggio. Il trasformatore visivo implementa quindi l’auto-attenzione su queste patch per creare una rappresentazione basata sul trasformatore dell’immagine di input.

Formazione di modelli di linguaggio visivo

Le strategie di formazione per i modelli di linguaggio visivo comportano l’allineamento e la fusione di informazioni provenienti sia dai codificatori visivi che da quelli linguistici in modo che il VLM possa imparare a correlare le immagini con il testo e prendere decisioni sulle 2 modalità insieme.

L’addestramento VLM di solito si basa su un mix di approcci:

● Apprendimento contrastivo

● Mascheramento

● Addestramento del modello generativo

● Modelli pre-addestrati.

Apprendimento contrastivo

L’apprendimento contrastivo mappa gli incorporamenti di testo e immagine da entrambi i codificatori in uno spazio di incorporamento congiunto o condiviso. Il VLM viene addestrato su set di dati di coppie testo-immagine e impara a ridurre al minimo la distanza tra gli incorporamenti di coppie corrispondenti e a massimizzarla per coppie non corrispondenti.

Un comune algoritmo di apprendimento contrastivo è CLIP (Contrastive Language-Image Pretraining). CLIP è stato addestrato su 400 milioni di coppie didascalie-immagine prese da Internet e ha dimostrato un’elevata accuratezza di classificazione zero-shot.1

Mascheramento

Il mascheramento è un’altra tecnica di addestramento in cui i modelli di linguaggio visivo imparano a prevedere parti oscurate casualmente di un testo o di un’immagine di input. Nella modellazione del linguaggio mascherato, i VLM imparano a riempire le parole mancanti in una didascalia di testo data un’immagine non mascherata.

Nel frattempo, nella modellazione di immagini mascherate, i VLM imparano a ricostruire i pixel nascosti in un’immagine data una didascalia non mascherata.

Un esempio di modello che utilizza il mascheramento è FLAVA (Foundational Language And Vision Alignment). FLAVA impiega un trasformatore di visione come codificatore di immagini e un’architettura di trasformazione sia per il suo codificatore di linguaggio che per il codificatore multimodale.

Il codificatore multimodale applica un meccanismo di attenzione incrociata per integrare informazioni testuali e visive. La formazione di FLAVA comprende la modellazione mascherata insieme all’apprendimento contrastivo.1

Formazione del modello generativo

La formazione del modello generativo per i VLM comporta l’apprendimento della generazione di nuovi dati. La generazione di testo in immagine produce immagini dal testo di input, mentre la generazione di immagine in testo produce testo, come didascalie, descrizioni di immagini o riepiloghi, da un’immagine di input.

Esempi di modelli testo-immagine popolari includono modelli di diffusione, come Imagen di Google, Midjourney, DALL-E di OpenAI (a partire da DALL-E 2) e Stable Diffusion di Stability AI.

Modelli pre-addestrati

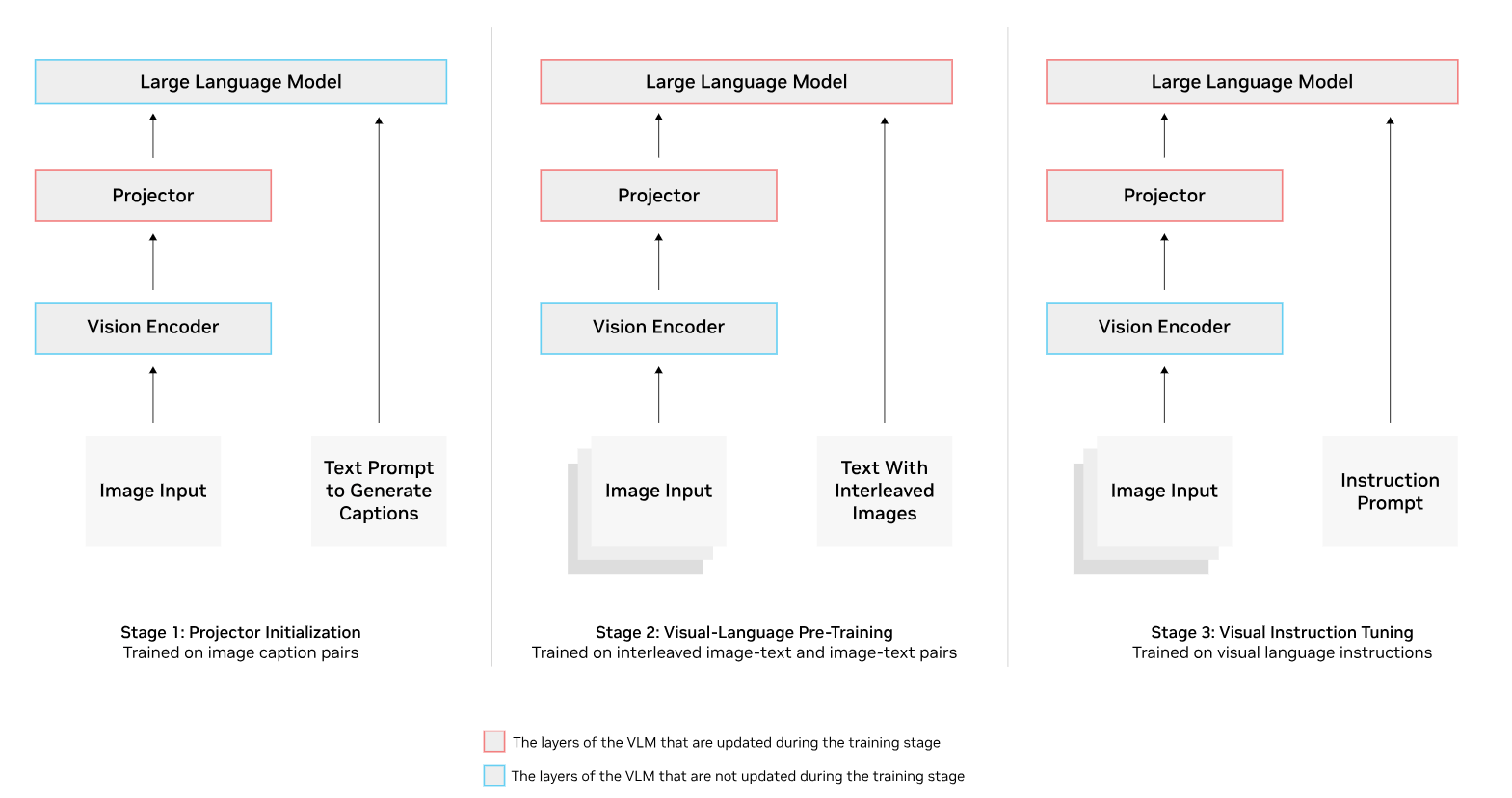

I VLM possono essere invece costruiti da modelli pre-addestrati. Possono essere utilizzati un LLM pre-addestrato e un codificatore di visione pre-addestrato, con un livello di rete di mappatura aggiunto che allinea o proietta la rappresentazione visiva di un’immagine nello spazio di input del LLM.

LLaVA (Large Language and Vision Assistant) è un esempio di un VLM sviluppato da modelli pre-addestrati. Questo modello multimodale utilizza il Vicuna LLM e il CLIP ViT come codificatore di visione, con i loro output uniti in uno spazio dimensionale condiviso utilizzando un proiettore lineare.1

Raccogliere dati di addestramento di alta qualità per i VLM può essere noioso, ma esistono set di dati che possono essere utilizzati per il pre-addestramento, l’ottimizzazione e la messa a punto per attività downstream più specifiche.

Ad esempio, ImageNet contiene milioni di immagini annotate, mentre COCO ha migliaia di immagini etichettate per didascalie su larga scala, rilevamento di oggetti e segmentazione. Allo stesso modo, il dataset Laion è composto da miliardi di coppie multilingue di testo e immagini.

Casi d’uso del modello di linguaggio della visione VLM

I VLM possono colmare il divario tra informazioni visive e linguistiche. Ciò che in precedenza richiedeva 2 modelli di intelligenza artificiale separati per ogni modalità può ora essere combinato in un modello.

I VLM possono essere utilizzati per una serie di attività di linguaggio della visione:

● Sottotitolazione e riepilogo

● Generazione di immagini

● Ricerca e recupero di immagini

● Segmentazione di immagini

● Rilevamento di oggetti

● Risposta visiva alle domande (VQA)

Sottotitolazione e riepilogo

I modelli di linguaggio della visione possono generare didascalie o descrizioni dettagliate delle immagini. Possono anche riassumere video e informazioni visive in documenti, come immagini mediche per contesti sanitari o grafici di riparazione delle apparecchiature in strutture di produzione.

Generazione di immagini

I generatori di testo in immagini come DALL-E, Imagen, Midjourney e Stable Diffusion possono aiutare a creare arte o immagini per accompagnare i contenuti scritti. Le aziende possono anche utilizzare questi strumenti durante le fasi di progettazione e prototipazione, aiutando a visualizzare le idee di prodotto.

Ricerca e recupero di immagini

I VLM possono cercare in grandi gallerie di immagini o database video e recuperare foto o video pertinenti in base a una query in linguaggio naturale. Ciò può migliorare l’esperienza utente per gli acquirenti sui siti Web di e-commerce, ad esempio, aiutandoli a trovare un articolo particolare o a navigare in un vasto catalogo.

Segmentazione delle immagini

Un modello di linguaggio visivo può suddividere un’immagine in segmenti in base alle caratteristiche spaziali che ha appreso ed estratto dall’immagine. Il VLM può quindi fornire descrizioni testuali di tali segmenti.

Può anche generare riquadri di delimitazione per localizzare oggetti o fornire altre forme di annotazione come etichette o evidenziazione colorata per specificare sezioni di un’immagine relative a una query.

Ciò può essere utile per la manutenzione predittiva, ad esempio, aiutando ad analizzare immagini o video di stabilimenti per rilevare potenziali difetti delle apparecchiature in tempo reale.

Rilevamento di oggetti

I modelli di linguaggio della visione possono riconoscere e classificare gli oggetti all’interno di un’immagine e fornire descrizioni contestuali come la posizione di un oggetto rispetto ad altri elementi visivi.

Il rilevamento di oggetti può essere utilizzato nella robotica, ad esempio, consentendo ai robot di comprendere meglio il loro ambiente e comprendere le istruzioni visive.

Risposta visiva alle domande (VQA)

I VLM possono rispondere a domande su immagini o video, dimostrando le loro capacità di ragionamento visivo. Ciò può aiutare con l’analisi di immagini o video e può persino essere esteso ad applicazioni di intelligenza artificiale agentica.

Nel settore dei trasporti, ad esempio, gli agenti di intelligenza artificiale possono essere incaricati di analizzare i video delle ispezioni stradali e identificare pericoli come segnali stradali danneggiati, semafori difettosi e buche.

Quindi, possono essere invitati a produrre un rapporto di manutenzione che delinea la posizione e la descrizione di tali pericoli.

Esempi di VLM

I modelli di linguaggio di visione stanno avanzando rapidamente, con il potenziale per essere diffusi quanto gli attuali LLM avanzati.

Ecco alcuni esempi di VLM popolari:

● GPT-4o

● NVLM

DeepSeek-VL2

DeepSeek-VL2 è un modello di linguaggio di visione open source con 4,5 miliardi di parametri della startup cinese di intelligenza artificiale DeepSeek. È composto da un codificatore di visione, un adattatore di linguaggio di visione e il DeepSeekMoE LLM, che adotta un’architettura Mixture of Experts (MoE).

DeepSeek-VL2 ha una variante minuscola con 1 miliardo di parametri e una variante piccola con 2,8 miliardi di parametri.

Gemini 2.0 Flash

Gemini 2.0 Flash fa parte della suite di modelli Google Gemini. Le modalità di input includono audio, immagine, testo e video, con un output solo testo. È in arrivo una funzionalità di generazione di immagini.

GPT-4o

GPT-4o di OpenAI è un singolo modello addestrato end-to-end su dati audio, visivi e di testo. Può accettare una combinazione di input audio, immagine, testo e video e produrre qualsiasi combinazione .

La sua controparte più piccola, GPT-4o mini, supporta sia input di immagini che di testo e genera output di testo.

Llama 3.2

I modelli open source di Llama 3.2 includono 2 VLM con dimensioni di parametri di 11 e 90 miliardi. Gli input possono essere una combinazione di testo e immagini, con un output di solo testo.3

Secondo Meta, l’architettura VLM è composta da un codificatore di immagini ViT, un adattatore video e un adattatore di immagini. L’adattatore di immagini addestrato separatamente ha una serie di livelli di attenzione incrociata che alimentano le rappresentazioni del codificatore di immagini nel LLM Llama 3.1 pre-addestrato.

NVLM

NVLM è una famiglia di modelli multimodali di Nvidia. NVLM-D è un modello solo decoder che alimenta i token di immagini direttamente nel decoder LLM. NVLM-X impiega l’attenzione incrociata per elaborare i token delle immagini ed è più efficiente per la gestione di immagini ad alta risoluzione.

NVLM-H adotta un’architettura ibrida che combina gli approcci solo decodificatore e attenzione incrociata, migliorando l’efficienza computazionale e le capacità di ragionamento.

Qwen 2.5-VL

Qwen 2.5-VL è il modello di linguaggio di visione di punta della società cinese di cloud computing Alibaba Cloud. È disponibile in dimensioni di parametri da 3 – 7 e 72 miliardi.

Il modello utilizza un codificatore di visione ViT e il Qwen 2.5 LLM. Può comprendere video lunghi più di un’ora e può navigare nelle interfacce desktop e smartphone.

Benchmark del modello di linguaggio di visione

Come gli LLM, anche i VLM hanno i propri benchmark. Ogni benchmark potrebbe avere la propria classifica, ma ci sono anche classifiche indipendenti come la OpenVLM Leaderboard ospitata su Hugging Face che classifica i modelli di linguaggio di visione open source in base a varie metriche.

Ecco alcuni benchmark comuni per i modelli di linguaggio visivo:

● MathVista è un benchmark per il ragionamento matematico visivo.

● MMBench ha una raccolta di domande a scelta multipla che coprono diverse dimensioni di valutazione, tra cui localizzazione degli oggetti, riconoscimento ottico dei caratteri (OCR) e altro.

● MMMU (Massive Multidiscipline Multimodal Understanding) contiene sfide multimodali a scelta multipla su vari argomenti per misurare la conoscenza, la percezione e le capacità di ragionamento.

● MM-Vet valuta l’integrazione di diverse capacità VLM, come la generazione del linguaggio, la consapevolezza spaziale e altro.

● OCRBench si concentra sulle capacità OCR dei VLM. È costituito da 5 componenti: VQA orientato ai documenti, riconoscimento di espressioni matematiche scritte a mano, estrazione di informazioni chiave, riconoscimento del testo e VQA incentrato sul testo della scena.

● VQA è uno dei primi benchmark VLM. Il set di dati comprende domande aperte sulle immagini. Altri derivati di VQA includono GQA (risposta alle domande su grafici di scene di immagini), OK-VQA (richiede conoscenze esterne per la risposta visiva alle domande), ScienceQA (risposta alle domande scientifiche) e TextVQA (ragionamento visivo basato sul testo nelle immagini).

Il benchmarking dei VLM può richiedere molto tempo, ma alcuni strumenti possono semplificare il processo. VLMEvalKit è un toolkit di valutazione open source che consente la valutazione dei VLM con un solo comando. Un’altra suite di valutazione è LMMs-Eval, che fornisce anche un’interfaccia a riga di comando per la valutazione.

Sfide dei VLM

Come con qualsiasi sistema di intelligenza artificiale, i VLM devono ancora fare i conti con i rischi dell’intelligenza artificiale. Le aziende devono tenerlo a mente quando prendono in considerazione l’integrazione di modelli di linguaggio di visione nei loro flussi di lavoro interni o la loro implementazione per applicazioni commerciali.

Ecco alcune sfide associate ai VLM:

● Bias

● Costi e complessità

● Generalizzazione

● Allucinazioni

Bias

I modelli di linguaggio visivo possono imparare dai bias che potrebbero essere presenti nei dati del mondo reale su cui sono addestrati o dai modelli pre-addestrati su cui sono costruiti. L’utilizzo di diverse fonti di dati e l’integrazione della supervisione umana durante tutto il processo possono aiutare a mitigare i bias.

Costi e complessità

I modelli di visione e i modelli di linguaggio sono già complessi di per sé, quindi unirli può aumentare ulteriormente la loro complessità. Questa complessità comporta la necessità di maggiori risorse di elaborazione, rendendo difficile l’implementazione dei VLM su larga scala. Le aziende devono essere pronte a investire nelle risorse necessarie per lo sviluppo, l’addestramento e l’implementazione di questi modelli.

Generalizzazione

I VLM potrebbero vacillare quando si tratta di generalizzazione, ovvero la capacità di un modello di adattarsi e fare previsioni accurate su dati nuovi e mai visti prima.

Un set di dati bilanciato che include valori anomali o casi limite e impiega l’apprendimento zero-shot può consentire ai VLM di adattarsi a nuovi concetti o combinazioni atipiche di testo e immagine.

Anche il benchmark LiveXiv di IBM per le attività di comprensione dei documenti visivi può essere utile. LiveXiv è un benchmark dinamico che viene aggiornato automaticamente ogni mese, valutando i VLM su domande e immagini che probabilmente non hanno mai visto prima.

Allucinazioni

I modelli di linguaggio visivo possono essere inclini alle allucinazioni dell’AI. La convalida dei risultati di questi modelli è un passaggio cruciale per assicurarsi che siano fattualmente accurati.

Per approfondire: