L’AI pervade sempre più le nostre vite, ne consegue che è quanto mai necessario comprenderne in modo approfondito l’emergente ecosistema e convertire questa tecnologia in una potente leva strategica al servizio dell’uomo e ridurne i rischi. A tal proposito la società americana di consulenza e ricerca Gartner Inc. ha sviluppato un framework denominato AI TRiSM – i.e. AI Trust, Risk, security Management – che supporta la governance, l’attendibilità, l’equità, l’affidabilità, la robustezza, l’efficacia e la protezione dei dati (quindi la gestione del rischio) del modello di AI.

Indice degli argomenti:

Che cos’è AI TRiSM e perché è importante nella gestione del rischio?

La società – grazie all’AI – è in grado di risolvere numerose sfide e problemi. Siamo di fronte a uno strumento potente che, tuttavia, se non gestito correttamente – secondo un approccio risk-based – può convertirsi in “arma” pericolosa con impatti negativi in termini legali, sociali ed etici.

Norma ISO 31700 e privacy by design: cosa devono sapere aziende e consulenti

Questi nuovi requisiti di gestione della fiducia, del rischio e della sicurezza dell’AI – che i controlli convenzionali non affrontano – possono essere gestiti implementando il framework ai trism (i.e. AI Trust, Risk, & Security Management).

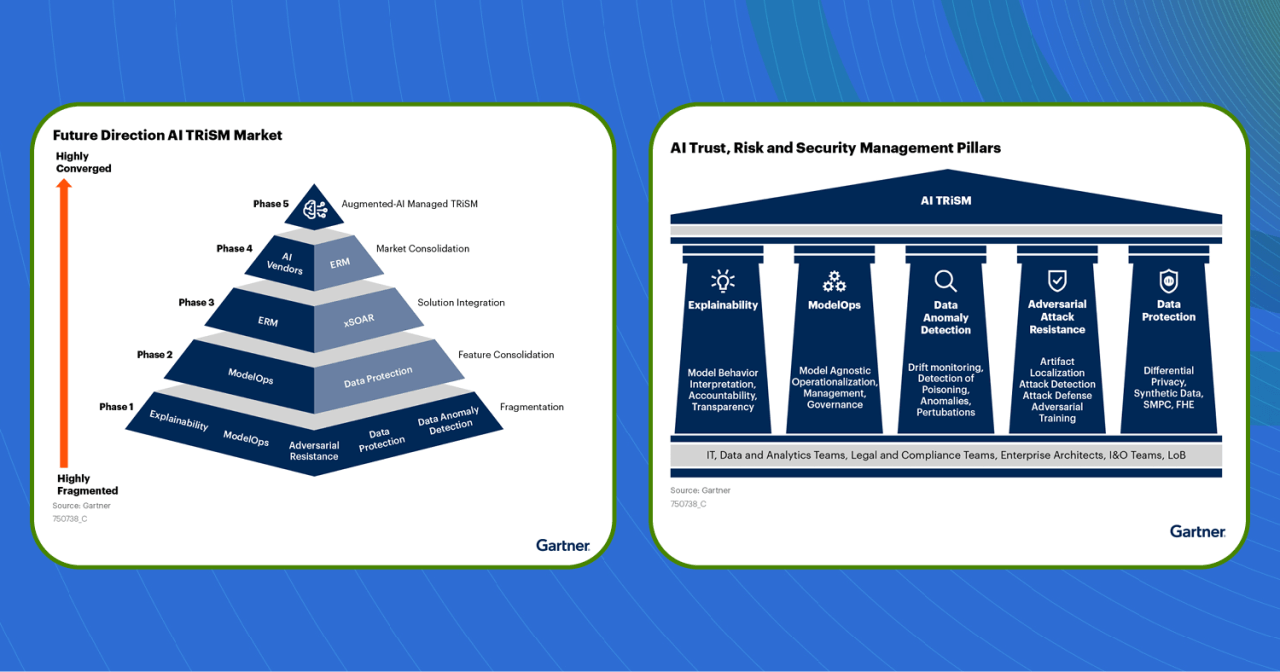

Come è strutturato AI TRiSM?

Il framework AI TRiSM si basa sui seguenti cinque pilastri atti a costruire soluzioni efficaci:

- Trasparenza e interpretabilità – Il processo decisionale di un modello di intelligenza artificiale dovrebbe essere facilmente compreso dagli utenti, quindi, il risultato è comprensibile e spiegabile.

- Modelops/Responsabilità – Poiché la tecnologia AI ha il pieno potenziale di fare più di quello per cui è stata progettata, è importante che le organizzazioni stabiliscano una governance e una gestione operativa responsabile del modello di AI.

- Rilevamento di anomalie nei dati – l’AI dovrebbe trattare i dati senza pregiudizi. Pertanto, un modello di AI dovrebbe garantire responsabilità, sicurezza e affidabilità, nonché sicurezza e privacy. Di fatto, il rilevamento di anomalie di dati nell’AI TRiSM comporta il monitoraggio della deriva e il rilevamento di anomalie, “poisoning” e “perturbation”. La protezione dei dati e la sicurezza IT del processo ML sono essenziali per supportare AI TRiSM. La sicurezza dei dati inizia con l’abilitazione di controlli di accesso granulari durante l’intero ciclo di vita del machine learning, fornendo agli utenti il giusto accesso alle informazioni e prevenendo al contempo violazioni involontarie o intenzionali. Ovvero, l’AI TRiSM aiuta l’organizzazione a migliorare le prestazioni avendo piena visibilità sui problemi dei dati di AI che possono impattare sull’efficacia del processo decisionale.

- Resistenza agli attacchi – Il sistema di AI dovrebbe essere in grado di operare in modo sicuro e affidabile in condizioni sia normali sia impreviste e resistere agli attacchi.

- Protezione dati: il sistema di AI genera e utilizza grandi quantità di dati e, inoltre, dovrebbe essere in grado di proteggere i dati sensibili. Ne consegue che la protezione dei dati è fondamentale in quanto la violazione della privacy dei dati può causare vari impatti dannosi, tra cui: perdite finanziarie, perdita di reputazione, sicurezza e minacce alla salute. Il framework AI TRiSM garantisce che la governance sia conforme a normative come il GDPR e, altresì, migliora la privacy dei dati attraverso l’uso di dati sintetici e tecniche di elaborazione sicure, tra cui Secure Multi-party Computation (SMPC) e Full Homomorphic Encryption (FHE).

Inoltre, le organizzazioni che desiderano implementare AI TRiSM dovrebbero anche garantire:

- Un sistema di documentazione e procedure standard – Si tratta di supportare l’affidabilità e documentare i dati utilizzati per addestrare il sistema di AI e, al contempo, facilitare il processo di audit della tecnologia nel caso in cui qualcosa vada storto. Inoltre, i sistemi di documentazione dovrebbero basarsi sia su orientamenti giuridici sia su valutazioni interne dei rischi oltre a includere sia processi di documentazione standardizzati sia modelli di documenti. Ancora, un sistema di documentazione dovrebbe essere coerente e intuitivo in modo da supportare sia l’AI TRiSM sia l’uso della tecnologia.

- Un sistema di controlli – Le organizzazioni devono disporre di sistemi progettati con funzionalità automatizzate per monitorare potenziali distorsioni e impedire che un sistema danneggiato causi gravi danni, oppure per intercettati e notificati set di dati incompleti, mancanti o altamente anomali.

- La trasparenza della tecnologia – Il processo decisionale dell’AI deve essere trasparente, rendendo facile per i consumatori non tecnici vedere come vengono raccolti i dati e come il sistema prende decisioni basate su tali dati.

Aspetti dell’AI TRiSM e della gestione del rischio

- Definizione ambito e utilizzo dell’AI – Le organizzazioni che utilizzano l’AI devono definire chiaramente l’ambito e gli usi della tecnologia. La definizione di un sistema di AI stabilisce una base per il quadro di gestione del rischio e delinea i vari elementi costitutivi.

- Inventario dei sistemi di AI – È necessario tenere traccia dei vari sistemi di AI che un’organizzazione ha implementato in modo da monitorare i rischi associati. Di fatto, attraverso l’inventario si definiscono i vari scopi del sistema, gli obiettivi e le eventuali restrizioni in termini di utilizzo. Un inventario può anche essere utilizzato per elencare i principali set di dati per ogni sistema di AI.

- Politiche di gestione del rischio – Le aziende gestiscono i rischi dell’AI applicando una governance rigorosa ai modelli durante l’intero ciclo di vita del machine learning, dallo sviluppo alla produzione e all’archiviazione. Le aziende dovrebbero altresì decidere se devono aggiornare le politiche di gestione del rischio esistenti o creare una serie completamente nuova di politiche per i loro sistemi di AI. Queste politiche dovrebbero essere sviluppate per incoraggiare l’uso appropriato e la scalabilità della tecnologia. Inoltre, è doveroso ricordare che non esiste una piattaforma valida per tutti quando si tratta di affrontare ogni aspetto di AI TRiSM. Le aziende devono essere in grado di strutturare varie politiche e strumenti interni ed esterni per coprire le diverse categorie di rischi e minacce, inclusi bot, errori di sistema, attacchi di query e input dannosi. Inoltre, il furto di proprietà, il danneggiamento di beni, la manipolazione di beni, il furto di modelli e il danneggiamento dei dati sono tutti potenziali tipi di danni che possono essere causati da queste minacce.

Ancora, alcune di queste minacce sono preesistenti, mentre altre prendono di mira il sistema di AI dopo l’implementazione. Pertanto, le organizzazioni devono disporre di misure di mitigazione che coprano entrambi le tipologie di minacce. Di fatto, le misure di sicurezza e affidabilità aziendale possono essere utilizzate per affrontare le minacce preesistenti, mentre le misure ModelOps possono essere utilizzate per mitigare le minacce post-implementazione.

- Strutture di gestione del rischio AI team- Le aziende, che desiderano sviluppare o perfezionare le strutture di AI, dovrebbero disporre di un team di lavoro con diversi set di competenze e provenienti da vari dipartimenti in modo tale da avere: maggiore qualità dei dati, etica dei dati, obblighi di conformità, partner di dati esistenti, potenziali partner di dati, garanzie appropriate e supervisione del sistema. L’approccio standard – per l’adozione su larga scala di strutture di gestione del rischio AI – consiste nell’implementare processi e procedure di gestione del rischio efficaci e garantire che i sistemi di AI siano sicuri e resilienti. Pertanto, per raggiungere questo obiettivo, sarebbe auspicabile la costituzione di un organismo centrale composto da esperti in materia come ingegneri di machine learning e architetti della sicurezza.

A fronte di quanto sopra, risulta quanto mai importante e strategico implementare l’AI TRiSM nell’adozione iniziale di un modello AI al fine di: proteggere meglio l’AI; creare fiducia nei consumatori, attraverso una gestione proattiva del rischio; riducendo il rischio fin dall’inizio dello sviluppo delle applicazioni AI.

Il mercato dell’AI TRiSM e trend futuri

Il framework AI TRiSM è destinato a essere implementato man mano che gli utenti rendono operativi i loro modelli di AI e soprattutto ai fini della gestione del rischio del modello e della garanzia che la loro AI sia attendibile e funzioni come progettato, evitando problemi di sicurezza o privacy.

Al momento, il mercato dell’AI TRiSM è abbastanza frammentato. Gli utenti sono indotti a selezionare più soluzioni per gestire i rischi e problemi intrinseci ai modelli di AI. Inoltre, la maggior parte dei fornitori e delle piattaforme di AI non fornisce tutte le funzionalità richieste e gli utenti sono costretti ad acquisirle da fornitori di nicchia.

Inoltre, i modelli di terze parti – i.e. prodotti avanzati di sicurezza informatica per la protezione degli endpoint e della rete – in futuro saranno sempre più gestiti dalle organizzazioni degli utenti finali in modo da comprendere maggiormente le funzioni di AI che hanno acquistato e garantire che i modelli funzionino come previsto.

Secondo Gartner Inc., le organizzazioni che, entro il 2026, saranno in grado di fornire la trasparenza, la fiducia e la sicurezza dell’AI registreranno un aumento del 50% in termini di: adozione dei propri modelli di AI, conseguimento degli obiettivi di business e miglior accettazione da parte degli utenti.

Tuttavia, non dobbiamo dimenticare che le organizzazioni che non saranno in grado di gestire il rischio AI avranno molte più probabilità di dover gestire esiti negativi e violazioni dell’AI a fronte di modelli che non funzioneranno come previsto e causeranno problematiche in termini di: sicurezza, privacy, perdite finanziarie, danni alla reputazione e alle persone. Senza dimenticare che l’AI, eseguita in modo errato, può anche indurre le organizzazioni a prendere decisioni aziendali sbagliate.

Conclusioni

Le imprese che desiderano impiegare l’AI nella propria organizzazione devono garantire che l’algoritmo del modello sia oggettivo ed etico e prenda la decisione “giusta”. Si tratta di fatto di implementare una AI “responsabile” attraverso il monitoraggio dei rischi fin dalla fase di ideazione degli algoritmi. In quest’ottica è stato sviluppato il framework AI TRiSM che vuole fungere da supporto alle organizzazioni affinché la tecnologia sia adeguatamente presidiata e garantisca il risultato atteso attraverso un processo iterativo di gestione del rischio per l’intero ciclo di vita del sistema, evitando modelli che non funzionino come previsto, fallimenti di sicurezza, perdite finanziarie e danni alla reputazione Ovvero, l’AI dovrà diventare necessariamente “trustworthy“; i prodotti e i servizi dovranno essere basati su dati sicuri; le basi di dati su cui saranno addestrati gli algoritmi dovranno essere prive di bias e il loro funzionamento non più opaco, bensì trasparente e spiegabile.

L’AI TRiSM fornisce, quindi, un approccio strutturato per identificare e mitigare i rischi ed è in grado di garantire che i sistemi di AI siano sicuri e conformi alle normative. Tuttavia, l’implementazione del framework può essere impegnativa e le aziende possono incontrare ostacoli in termini di: mancanza di comprensione dell’IA, risorse limitate e complessità dei sistemi di IA.

Inoltre, è importante che le aziende rimangano informate e aggiornate sugli ultimi sviluppi di AI TRiSM e si consultino con esperti del settore durante l’attuazione del quadro. Pertanto, si dovrà perseguire uno sviluppo tecnologico intelligente “umano centrico”, a misura di democrazia e diritti individuali e sociali. Il tutto senza trascurare il ruolo che le Autorità regolamentari hanno nella definizione dei rischi e dei requisiti tecnici e sociali che tali sistemi devono soddisfare.