AMD ha presentato MI300X, la sua sfida alla GPU di punta di Nvidia, l’H100. MI300X può eseguire un modello da 40 miliardi di parametri su un solo chip. Nvidia è da tempo il leader indiscusso delle GPU AI. Ora AMD è pronta ad accaparrarsi una fetta di mercato, dato che le GPU di Nvidia scarseggiano.

MI300X è stato progettato specificamente per i carichi di lavoro dell’AI generativa, in grado di alimentare modelli linguistici di grandi dimensioni come il Falcon-40 su un singolo chip, o ciò che AMD chiama “acceleratori”. Il modello Falcon-40, giustamente chiamato così, vanta 40 miliardi di parametri, circa 150 miliardi in meno rispetto all’ormai obsoleto modello GPT-3 di OpenAI.

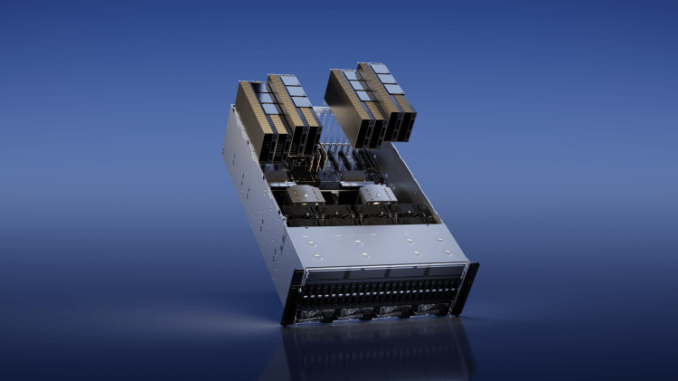

L’azienda sta anche cercando di offrire una scheda OCP-compliant chiamata Instinct Platform che comprenderà otto MI300X, non troppo dissimile dall’offerta HGX di Nvidia.

Indice degli argomenti:

MI300X, l’architettura hardware

L’hardware è basato sull’architettura CDNA 3 di AMD e supporta fino a 192 GB di memoria HBM3. Tuttavia, non sono stati resi noti benchmark o prezzi reali, anche se l’azienda ha tenuto a sottolineare che la sua nuova offerta fornirà ai clienti “un portafoglio di prodotti hardware dal cloud, all’edge, all’endpoint, con una profonda collaborazione software del settore, per sviluppare soluzioni AI scalabili e pervasive”.

Alexander Harrowell, analista principale per l’elaborazione avanzata presso la società di ricerca sorella Omdia, ha affermato che i chip sono in qualche modo simili, ma ciò che contraddistingue il MI300X rispetto al MI300A è la sua cache di memoria on-chip più grande.

Ha dichiarato: “192 GB (per il MI300X) – rispetto ai 128 GB del MI300A e ai 120 GB dell’H100 – e si tratta di una GPU pura, mentre il MI300A è in realtà più simile al Grace Hopper di Nvidia, un modulo multichip contenente sia una CPU che una GPU”.

“AMD lo sta facendo, Nvidia lo sta facendo, Intel lo stava facendo ma è stato rimandato. Entrambi i componenti sono estremamente potenti (migliaia di TOPS) e anche molto caldi: quello di Nvidia ha un TDP di 700W, mentre AMD lo supera con 750W”.

Il vantaggio dell’H100 come GPU

Tra le differenze principali tra l’H100 e il nuovo MI300X di AMD c’è il fatto che il primo ha un vantaggio. Nvidia ha rivelato l’H100 lo scorso settembre e ha iniziato a distribuire ufficialmente i sistemi DGX H100 ai clienti all’inizio di maggio.

I clienti hanno avuto molto più tempo per familiarizzare con il chip di punta di Nvidia e con la sua posizione dominante precostituita nelle GPU AI, è difficile che il MI300X arrivi e sconvolga subito le cose.

Detto questo, tutti sono alla ricerca di GPU in questo momento. L’esplosione dell’interesse per l’AI generativa dopo il successo di ChatGPT ha portato le aziende di tutto il mondo a cercare di investire nell’AI e sta rendendo più difficile ottenere i chip.

Aziende del calibro di OpenAI, Microsoft, Adobe e persino Twitter si stanno affrettando ad acquistare GPU a destra e a manca per addestrare modelli di fondazione di grandi dimensioni. Questi attori su larga scala hanno le risorse per acquistare enormi quantità di chip, con gli H100 che costano circa 30mila dollari l’uno.

TikTok ha speso 1 miliardo di dollari quest’anno in GPU Nvidia

Prendiamo ByteDance, la società madre di TikTok, che quest’anno ha speso circa 1 miliardo di dollari in GPU Nvidia, suddivise tra le A100 e le A800 specifiche per il mercato cinese (essenzialmente, una H100 depotenziata a causa delle regole di esportazione degli Stati Uniti), secondo quanto riportato dalla pubblicazione cinese Jitwei.

Le GPU scarseggiano, tanto che gli investitori hanno deciso di acquistarle per le startup per accelerare il loro lavoro.

L’ex CEO di GitHub Nat Friedman e l’investitore seriale Daniel Gross hanno acquistato migliaia di GPU per formare il cluster Andromeda. Questo mastodontico sistema di calcolo contiene 2.512 H100 che le startup possono utilizzare per addestrare una versione da 65 miliardi di parametri del modello di intelligenza artificiale LLaMA, artificiale in soli 10 giorni.

AMD potrebbe sfidare il leader del mercato con il suo MI300X? Per il momento, AMD ha dichiarato di voler far provare i chip solo a “clienti chiave” a partire dal terzo trimestre. AMD ha iniziato a far provare ai clienti il suo MI300A, che può alimentare carichi di lavoro HPC e AI, ma chi vuole il MI300X potrebbe essere costretto ad aspettare – nel frattempo, Nvidia ha iniziato a spedire i suoi H100.

Per Harrowell, il problema non è tanto l’hardware, quanto la capacità di AMD di convincere gli sviluppatori ad adottare il suo software.

“L’SDK di Nvidia, CUDA, è lo standard del settore e su di esso è stata costruita un’enorme gamma di strumenti per l’addestramento di modelli di grandi dimensioni, l’inferenza, l’ottimizzazione, l’apprendimento per trasferimento, la gestione dell’infrastruttura e l’automazione delle operazioni e molte applicazioni verticali specifiche”.

“Al contrario, l’equivalente di AMD, ROCm, ha faticato. Ci sono stati alcuni miglioramenti, ma è stato significativo il fatto che AMD abbia avuto poco da dire al riguardo durante la ‘prima’ che ha tenuto per annunciare il nuovo chip”.

L’analista di Omdia ha dichiarato che il suo team si aspettava una ripresa della crescita delle GPU e che per AMD “è utile entrare in gioco ora” anche se i suoi prodotti “non si diffonderanno fino alla fine di quest’anno e all’inizio del prossimo”.

“È probabile che ci siano ritardi per tutti, ma Nvidia è arrivata prima – un grande vantaggio. AMD produce anche le sue CPU server Epyc, leader di mercato e assolutamente fondamentali per il suo business, utilizzando lo stesso processo di packaging, quindi dovrà pensare bene a quanti wafer dedicare agli MI300, che sono un rischio, e a quante CPU, che sa di poter vendere”.

AMD investirà 135 milioni di dollari in quattro anni in Irlanda

AMD ha inoltre annunciato l’intenzione di investire 135 milioni di dollari in quattro anni in strutture in Irlanda. I fondi serviranno a finanziare progetti di R&S e a creare 300 posti di lavoro nel campo dell’ingegneria e della ricerca. I progetti di ricerca riguarderanno “l’AI di prossima generazione”, i data center e il 6G.

L’investimento di AMD è sostenuto dal governo irlandese attraverso IDA Ireland, un gruppo di consulenza che cerca di incoraggiare gli investimenti nel Paese da parte di aziende di proprietà straniera. L’investimento “rafforzerà” il settore tecnologico del Paese e creerà opportunità di carriera a lungo termine, ha dichiarato Simon Coveney, ministro irlandese per le Imprese, il Commercio e l’Occupazione.

La presenza di AMD in Irlanda deriva dall’acquisizione di Xilinx nel 2022. Il Paese è ora sede di uno dei più grandi siti di ricerca e sviluppo di AMD in Europa e ha fornito prodotti con un successo commerciale “significativo”, come la famiglia di semiconduttori AMD Zynq UltraScale+ RFSoC.