Si scrive CM3leon e si pronuncia “chameleon”: è la nuova AI multimodale di Meta, la prima addestrata da modelli linguistici di solo testo. Il nuovo approccio impiegato dai ricercatori di Meta AI permette al nuovo modello di raggiungere prestazioni e accuratezza generativa elevata, pur mantenendo un profilo di efficienza che richiede risorse di calcolo cinque volte inferiori rispetto ai modelli tradizionali.

I risultati sono interessanti; il nuovo concept permette a CM3leon di eseguire compiti molto diversi, superando l’ostacolo della specializzazione nelle AI monomodali. Il nuovo modello di Meta può generare sequenze di testo che descrivono il contenuto di un’immagine e immagini partendo da un prompt testuale.

Indice degli argomenti:

Cos’è un’AI multimodale

Gli strumenti di intelligenza artificiale stanno integrando nel linguaggio d’uso quotidiano, una serie di termini tecnici specialistici, che dobbiamo imparare a comprendere per padroneggiare meglio gli strumenti smart di nuova generazione.

Per intelligenza artificiale multimodale si intende un modello di AI capace di comprendere, analizzare e sintetizzare dati provenienti da più modalità, denominate tecnicamente “canali”. Queste diverse modalità d’interazione possono includere testo, immagini, suoni e altri stimoli esterni. La stessa rete neurale multimodale può elaborare simultaneamente dati di diverse tipologie, generando un output coerente. Ad esempio, un’AI multimodale potrebbe essere in grado di analizzare sia il contenuto verbale di un video (attraverso il riconoscimento della voce o del linguaggio naturale) sia il contenuto visivo (attraverso il riconoscimento di immagini o video).

Invece, un’AI monomodale si focalizza su una sola tipologia di dati e si specializza nell’elaborare una risposta a un tipo specifico di prompt. Potrebbe, ad esempio, essere specializzata nel riconoscimento di un prompt testuale, nel riconoscimento vocale o nell’analisi di immagini.

La principale differenza tra l’AI monomodale e quella multimodale risiede nell’architettura e, di conseguenza, nel metodo di addestramento. Modelli con differenti connotazioni hanno diverse capacità di elaborare e integrare vari tipi di dati. Mentre l’AI monomodale può avere una comprensione più profonda di uno specifico canale, l’AI multimodale ha la capacità di fornire un contesto più ampio e una comprensione più completa attraverso l’analisi di diverse tipologie di dati.

Come funziona CM3leon

L’idea concettuale alla base di CM3leon è abbastanza semplice, si tratta di sviluppare un modello efficiente e versatile combinando le tecniche di training dei modelli linguistici di solo testo con dataset multimodali. Il risultato è un sistema capace di generare sequenze di testo e immagini partendo da prompt che contengono altri contenuti testuali e visivi. Tale flessibilità estende le potenzialità d’uso delle intelligenze artificiali generative monomodali, che restano ancorate a un’unica tipologia di prompt.

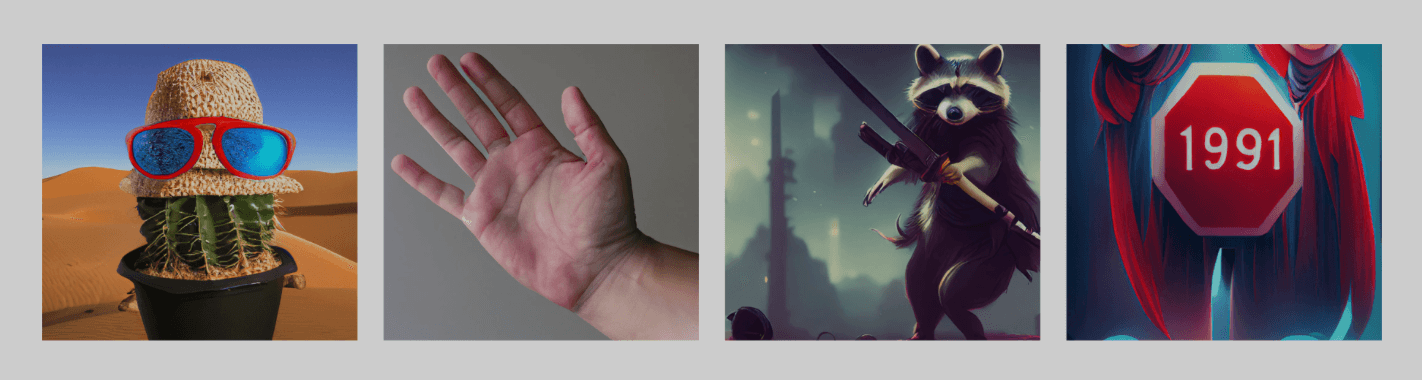

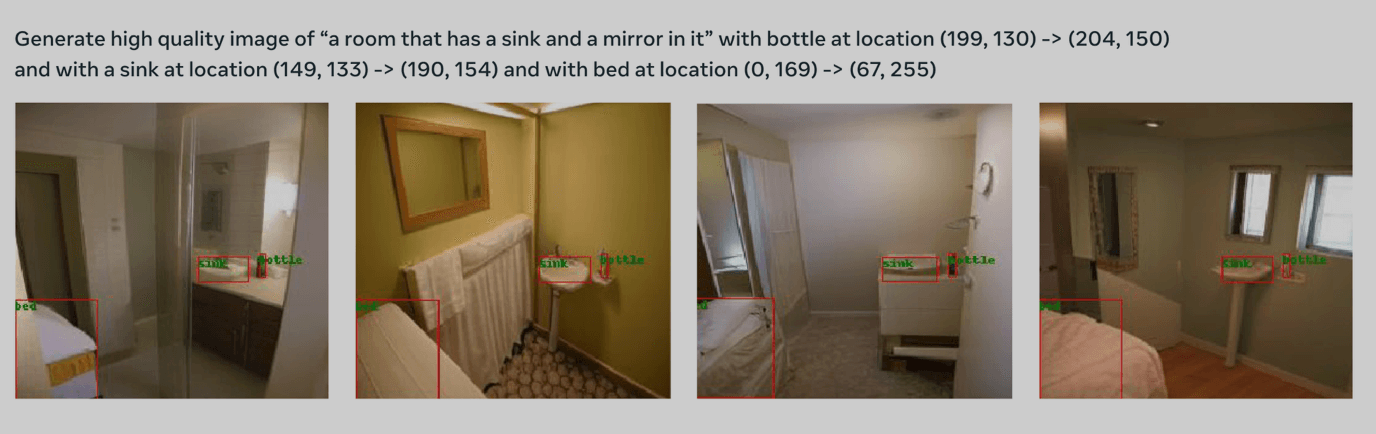

La versatilità di un modello multimodale come CM3leon diventa chiara quando viene impiegato per la generazione di immagini da prompt testuali complessi, composti da numerose descrizioni dettagliate. Le intelligenze artificiali generative monomodali, solitamente utilizzate per generare immagini, non sono in grado di gestire efficacemente tutte le informazioni presenti in prompt complessi, con conseguenti risultati strani e poco pertinenti alla richiesta dell’utente. L’intelligenza artificiale di Meta, invece, ha dimostrato performance superiori alla media anche con prompt complessi e ricchi di specializzazioni e dettagli.

L’aumento della complessità dei modelli generativi comporta anche un incremento dei rischi associati all’etica e alla privacy. Queste intelligenze artificiali apprendono dalle immagini e dai testi, scoprendo correlazioni complesse tra gli elementi presenti nelle informazioni utilizzate per l’addestramento. Questo rende fondamentale la scelta del giusto set di dati per l’addestramento, al fine di limitare i bias, garantire la privacy delle persone e evitare conflitti con il diritto d’autore. Per garantire la trasparenza del progetto, Meta ha deciso di addestrare CM3leon utilizzando un set di dati con licenza, un passo importante verso la spiegabilità e l’eticità dei modelli di intelligenza artificiale.

Cosa si può fare con CM3leon

L’intelligenza artificiale multimodale, come CM3leon, ha come tratto distintivo la flessibilità. Questo significa che costituisce lo strumento ideale per eseguire una varietà di compiti. Esaminiamone alcuni.

Generazione guidata delle immagini

È sempre una sfida trovare il giusto input per generare un’immagine di alta qualità. Con CM3leon, è possibile integrare dettagli sofisticati nel comando senza dover ricorrere a trucchi particolari. E se il risultato ottenuto non è ancora all’altezza delle aspettative, può essere avanzato ulteriormente con indicazioni addizionali che guidano l’AI su come modificare l’immagine, così da meglio adattarla alle esigenze dell’utente.

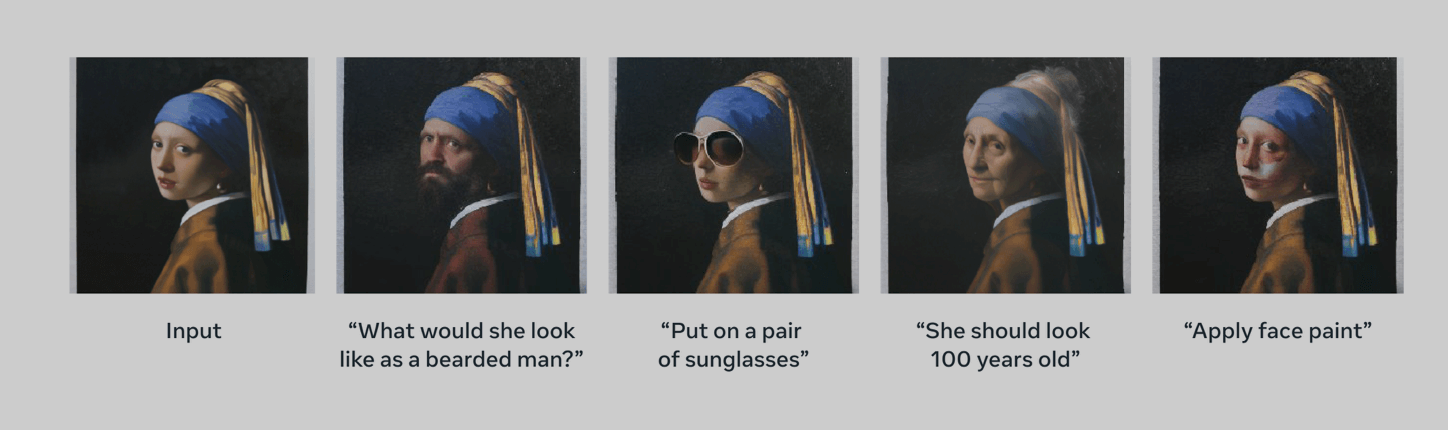

Editing di immagini

La multimodalità offre all’utente la possibilità di usare l’AI per modificare immagini pre-esistenti con delle semplici istruzioni testuali. CM3leon, a differenza dei competitor, usa lo stesso modello sia per la generazione che per l’editing, semplificando l’intero processo e migliorando la qualità dell’output. Le modifiche dell’AI tengono conto non solo del prompt testuale ma anche dell’intera struttura generale dell’immagine originale, generando modifiche visivamente coerenti e appropriate con il contesto.

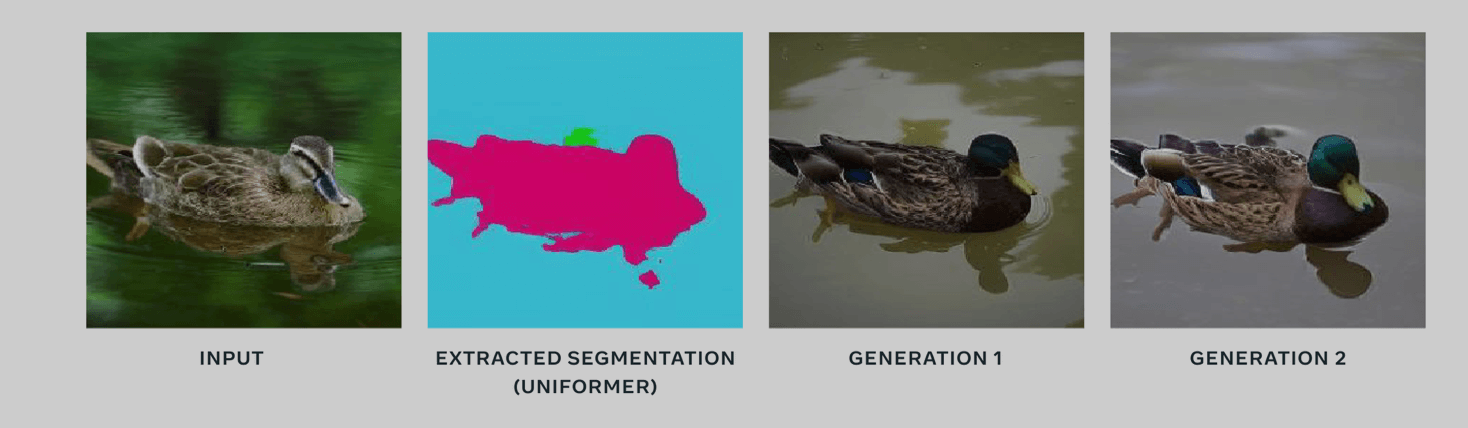

Segmentazione

La segmentazione delle immagini è un processo utilizzato in computer vision che consiste nel dividere un’immagine digitale in regioni che contengono un oggetto uniforme. Questa forma di classificazione è fondamentale, perché permette alle macchine di riconoscere gli oggetti in un’immagine o in un video. CM3leon può segmentare un’immagine partendo da una descrizione testuale e può anche classificare gli oggetti presenti in una immagine e annotarla con un input testuale.

Generazione testuale

Se il prompt è una immagine, CM3leon può generare diversi testi descrittivi, e può anche rispondere a domande specifiche sull’immagine in questione. I risultati sono superiori a quelli di AI concorrenti che hanno richiesto addestramenti molto più complessi ed esosi di risorse rispetto a quelli del modello di Meta.

Multimodalità ed evoluzione orizzontale dell’AI

Ci sono due correnti evolutive che l’AI sta seguendo nella rivoluzione contemporanea. Una è quella della verticalizzazione, con sistemi smart che acquisiscono capacità rilevanti nel completare un task specifico e quanto più definito possibile. Un’altra è quella dell’orizzontalizzazione, della multimodalità, dell’espansione delle capacità dell’AI di analizzare un contesto complesso sfruttando una varietà di “sensi” che fungono da sorgenti dati. Entrambi i filoni di ricerca compiono progressi promettenti, ma forse potrebbe esserci all’orizzonte un nuovo modo di concepire lo sviluppo delle reti neurali, arrivando al generalista partendo da una serie di sottosistemi specifici che collaborano per arrivare all’analisi di contesto e quindi all’azione-risposta corretta.

Reti neurali sempre più complesse, trovano e amplificano correlazioni latenti nei dati usati per l’addestramento. Questo intensifica i bias e le problematiche etiche che sorgono nell’utilizzo di questi dati. Una soluzione valida al problema è la generazione di dati sintetici, che non è comunque sufficiente a soddisfare la fame d’informazioni di intelligenze artificiali sempre più complesse. L’explainability, ovvero la trasparenza di funzionamento, è un altro fattore cruciale per normare e validare il funzionamento dell’AI prima di applicarlo a casi di vita reale.

In quanto all’uso che se ne fa, invece, il giudizio deve rimanere sospeso. Non abbiamo ancora uno storico sufficiente per comprendere tutte le implicazioni dell’innovazione dell’AI, e non abbiamo nemmeno una programmazione sociale per ammortizzarne gli effetti già nel breve termine e, con meno urgenza, nel lungo periodo.