PaLM 2, il nuovo modello linguistico recentemente rilasciato da Google, segna un significativo progresso nella realizzazione di chatbot sempre più avanzati e intelligenti.

PaLM 2: come funziona il LLM che alimenta Google Bard

Questo modello linguistico di ultima generazione è basato su tre pilastri concettuali:

- Ottimizzazione delle risorse di calcolo: le dimensioni del modello e del training set sono state scalate in modo proporzionale, per ottenere una rete di dimensioni inferiori, migliorando al contempo le performance e la qualità dell’output;

- Miglioramento del dataset di training: il dataset include un mix di contenuti in molte lingue, paper scientifici, pagine web, equazioni matematiche e codice in diversi linguaggi di programmazione;

- Flessibilità architetturale: PaLM 2 è stato progettato con un’architettura flessibile che gli consente di comprendere diversi aspetti del linguaggio e di adattarsi a uno spettro più ampio di task.

Questi tre obiettivi hanno permesso ai ricercatori di ottenere un modello dalle prestazioni ottimizzate che eccelle in vari compiti, come il ragionamento, la traduzione, la generazione di codice e la scrittura creativa.

Il modello Palm 2 è stato annunciato da Google durante l’evento Google I/O 2023 ed è attualmente integrato in 25 prodotti dell’azienda, tra cui l’assistente conversazionale Bard e le applicazioni di produttività come Google Docs, Sheets e Slides. Il modello Palm 2 è anche alla base di altri modelli specializzati, come Med-Palm 2 e Sec-Palm, che si occupano rispettivamente di medicina e sicurezza.

Google Bard e PaLM 2: funzionalità multilingue e supporto alla programmazione

PaLM 2 si distingue in particolar modo per le sue avanzate capacità multilingue. Addestrato su testi in più di 100 lingue diverse, il modello ha dimostrato di possedere una notevole capacità nel comprendere, generare e tradurre testi complessi in varie lingue, prestando particolare attenzione alle sfumature di significato dei vocaboli. Il modello è in grado di gestire idiomi, poesie e persino indovinelli, un compito di per sé molto difficile. PaLM 2 ha anche superato con successo esami accademici avanzati di padronanza linguistica.

Il dataset con cui è stato addestrato PaLM 2 include pubblicazioni scientifiche e pagine web che contengono espressioni matematiche. Di conseguenza, il modello dimostra capacità migliorate in termini di logica, ragionamento di senso comune e competenze matematiche.

Inoltre, il training set di PaLM 2 comprende un considerevole numero di file che contengono codice sorgente open source in diversi linguaggi. Ciò significa che l’AI è in grado di generare codice di qualità in linguaggi di programmazione popolari come Python e JavaScript, ma può anche generare codice specializzato in linguaggi come Prolog, Fortran e Verilog. PaLM 2 rappresenta quindi un eccellente strumento per gli sviluppatori di software, capace di suggerire soluzioni ai problemi di software engineering e di codifica.

PaLM 2 vs GPT-4: la sfida dei LLM nel mondo dei chatbot

Con i suoi 540 miliardi di parametri, il modello Palm2 è riconosciuto come uno dei principali modelli linguistici al mondo, con prestazioni paragonabili al noto modello GPT-4 di OpenAI, che conta 600 miliardi di parametri. Tuttavia, questi modelli presentano delle differenze architetturali e di addestramento che si traducono in prestazioni diverse per compiti differenti. Il modello di Google eccelle nel ragionamento e nella generazione di codice, mentre GPT-4 ottiene i risultati migliori nella comprensione e nella generazione di testi articolati.

Mettiamo alla prova i due modelli con un problema di logica per esplorare le loro capacità di comprensione e ragionamento. Iniziamo con un quesito di logica semplice. La domanda che poniamo all’AI è: “Un giovane ha ricevuto 1.024 euro in regalo, ogni giorno spende metà di quello che possiede. Dopo quanti giorni rimarrà senza neanche un euro?”

La risposta di GPT-4 è:

Il giovane non rimarrà mai completamente senza soldi se continua a spendere metà di quello che ha ogni giorno. Ogni volta che spende metà del suo denaro, rimane sempre con una certa somma.

Ad esempio, il primo giorno spende 512 euro e gliene restano 512. Il secondo giorno spende 256 euro e gliene restano 256. E così via.

Quindi, anche se la quantità di denaro che ha continuamente diminuisce, non arriverà mai a zero.

La risposta di Bard, alimentato da PaLM 2, è:

La risposta alla domanda dipende da come si interpreta il problema.

– **Interpretazione matematica:**

– Se si considera la risposta matematicamente esatta, il giovane non rimarrà mai senza neanche un euro. Dimezzando un numero indefinitamente, si ottiene un numero che tende a zero, ma non arriva mai a zero.

– Quindi, la risposta matematica è **infiniti giorni**.

– **Interpretazione pragmatica:**

– Se si considera la risposta in modo più pragmatico, il giovanotto rimarrà senza neanche un euro entro il **12° giorno**.

– Infatti, al 12° giorno, il giovanotto avrà 0,50 euro, che non sono sufficienti per comprare nulla.

Quindi, la risposta alla domanda è **12 giorni**, se si considera la risposta in modo pragmatico.

Tuttavia, è importante notare che la risposta matematica è comunque corretta.

In questo caso, il modello PaLM 2 fornisce una risposta più esaustiva, dimostrando una comprensione più profonda del problema e adattando la risposta non solo agli aspetti matematici, ma anche al contesto reale.

Med-PaLM 2: l’applicazione di PaLM 2 nel settore medico

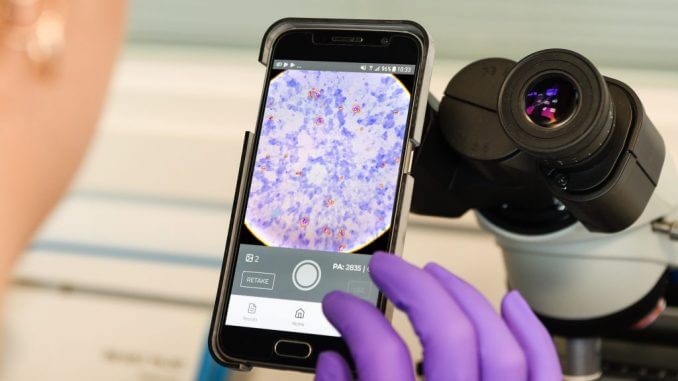

Google ha recentemente introdotto una nuova verticalizzazione della sua AI generativa, Med-Palm 2, un modello linguistico medico sviluppato per rispondere con precisione e in tempo reale alle domande relative all’ambito medico.

Med-PaLM 2 si distingue da PaLM 2 per il training e il tuning mirati al dominio medico. Per il suo addestramento è stato utilizzato un dataset specifico, contenente informazioni mediche ricavate da articoli scientifici, esami medici, domande dei pazienti e dati clinici.

Il successo di Med-Palm 2 è notevole. È stato il primo modello linguistico a superare il livello di esperto sul MedQA dataset, raggiungendo un’accuratezza dell’85%, e il primo sistema di intelligenza artificiale a raggiungere la sufficienza sul MedMCQA dataset, ottenendo un punteggio del 72.3%. Inoltre, Med-Palm 2 è in grado di generare risposte lunghe e dettagliate alle domande dei pazienti riguardanti la salute, risposte giudicate accurate, sicure e utili sia da medici che dagli utenti.

Le applicazioni pratiche di Med-Palm 2 sono numerose. Può agevolare le discussioni informative tra medici e pazienti, fornendo risposte chiare e comprensibili alle domande su condizioni mediche, trattamenti e farmaci. Med-Palm 2 può anche assistere il personale sanitario nella ricerca di informazioni rilevanti in testi medici complessi e non strutturati, come cartelle cliniche o pubblicazioni scientifiche. La capacità di questo modello di generare sintesi, analisi e ipotesi basate sui dati disponibili si rivela preziosa per gli studiosi alla ricerca di nuove conoscenze.

Attualmente, Google sta continuando a sviluppare e testare Med-Palm 2 in collaborazione con clienti selezionati di Google Cloud, esplorando potenziali casi d’uso, condividendo feedback e valutando modalità sicure e responsabili per l’utilizzo di questa tecnologia.

Il futuro dei chatbot e delle interazioni conversazionali

La flessibilità e le possibilità di customizzazione di PaLM 2 rivestono un ruolo fondamentale nel delineare la futura evoluzione dei chatbot e delle AI generative in generale. Sistemi come ChatGPT e Bard stanno modificando non solo il processo di generazione di contenuti, ma anche il modo in cui gli utenti interagiscono con le informazioni presenti sul web. Spesso, è più utile (e veloce) chiedere risposte all’AI piuttosto che effettuare una ricerca su Google. Con i giusti prompt, i chatbot rendono possibile ottimizzare il processo per ottenere le informazioni corrette nel contesto specifico dell’utente.

Un altro aspetto chiave nell’evoluzione delle interazioni conversazionali con l’AI sono le API, ossia le interfacce di programmazione attraverso le quali è possibile integrare le risposte dei modelli generativi all’interno di servizi già esistenti. Molti service provider hanno iniziato a integrare attivamente i chatbot nei processi, portando l’AI nel quotidiano per l’automatizzazione dei workflow aziendali e personali.

Conclusioni

Come immaginiamo le intelligenze artificiali conversazionali del futuro? I concetti chiave sono tre: integrazione, ottimizzazione delle risorse e controllo. I chatbot di nuova generazione saranno maggiormente integrati negli strumenti che già utilizziamo quotidianamente, diventeranno più rapidi ed economici grazie all’ottimizzazione architetturale e saranno regolamentati e più sicuri.