Le piattaforme Data science e Machine learning, note con l’acronimo Dslm, mettono in grado le organizzazioni di sviluppare modelli e strategie basate sui dati, adottando così una mentalità e una cultura digitale orientate alla competitività nel termine più ampio.

Unire Data science e Machine learning è oggi imprescindibile per le organizzazioni che mirano alla competitività. I dati diventano centrali e saperne fare uso prevede l’intersezione di discipline diverse. Ecco cosa sapere per scegliere in modo ragionato

Benché vadano a braccetto, Data science e Machine learning presentano differenze tra loro e non soltanto concettuali. La Data science studia i dati per estrarne valore, mentre il Machine learning è deputato alla costruzione di metodi e modelli che fanno leva sui dati per ottenere prestazioni migliori, anche in ottica previsionale.

Il Machine learning e le Intelligenze artificiali (AI) svolgono un ruolo fondamentale nell’analisi dei dati ma resta un confine labile: il Machine learning fa parte della Data science perché non può esistere senza dati e, senza dati di qualità, non c’è tecnologia in grado di dare i risultati attesi.

Indice degli argomenti:

Panoramica sulle piattaforme di Data science e Machine learning

Quando si tratta di trovare una definizione capace di racchiudere un concetto di ampio spettro ci si imbatte sempre in una difficoltà di estetica letteraria: le piattaforme di Data science e Machine learning (Dslm) sono ambienti che integrano librerie, framework e prodotti hardware e software per supportare quelle che, in gergo, si chiamano pipeline di dati e di analisi. È opportuno soffermarsi un attimo sulle pipeline.

Le pipeline

Cominciamo con il dare un significato al termine pipeline, del quale si fa spesso un uso debole, offrendolo a interpretazioni diverse. In italiano vuol dire tubatura, ed è proprio evocando il principio di conduttura che si usa in informatica laddove, almeno originariamente, indicava la parallelizzazione di flussi di elaborazione affinché i microprocessori elaborassero istruzioni più velocemente. Un concetto implementato da IBM alla fine degli anni Sessanta che poi, seguendo diverse declinazioni, è stato ereditato da altri ambienti sempre afferenti l’informatica.

Traslando il concetto di pipeline nel mondo della Data science si fa riferimento a un metodo grazie al quale i dati vengono prelevati da fonti diverse tra loro e fatti confluire in un unico database (per esempio un data lake o un datawarehouse) per poi venire analizzati. Il concetto di pipeline non esclude a priori che i dati vengano elaborati in qualche modo prima di essere convogliati verso il punto di analisi. I dati, per esempio, possono essere puliti, resi omogenei o persino cancellati.

Tornando alle piattaforme Dsml, il loro risultato ultimo è quello di consentire l’estrazione di dati, creare modelli e permettere di trarne valore. Compiti dei quali si occupano i Data scientist, figure professionali che rispondono a profili e attitudini diverse.

Le caratteristiche chiave delle piattaforme di Data science e Machine learning

Poiché l’uso di una piattaforma Dsml è destinato a diverse figure professionali, è necessario che consenta la cooperazione di ogni profilo coinvolto.

Per onore di chiarezza, cerchiamo di individuare quali sono le competenze che una piattaforma Dsml deve potere coinvolgere e agevolare. Questo, oltre a fare maggiore chiarezza in un ambito vasto, aiuta a comprendere quali caratteristiche sono imprescindibili:

Consideriamo l’ambito della Data science, ossia quello in cui si determinano processi e sistemi utili a trasformare i dati in strumenti utili all’impresa. In questo caso le discipline di cui c’è bisogno sono:

- statistica

- programmazione

- uso di database

- nozioni di Machine learning

- visualizzazione dei dati

Sul fronte del Machine learning, ossia sul fronte delle AI impiegate per emulare le capacità dell’uomo affidandosi a modelli e algoritmi, possiamo schierare queste conoscenze:

- programmazione

- prototipazione

- matematica (soprattutto statistica e probabilistica)

- creazione modelli

Si tratta di elenchi non esaustivi ai quali occorre aggiungere alcune voci, considerando che essendo il Machine learning una parte della Data science, fa uso di algoritmi allenati con i dati forniti dalle figure competenti. Nella loro sovrapposizione, gli ambiti della Data science e del Machine learning necessitano di ulteriori capacità:

- conoscenze ampie di analisi matematica

- predisposizione al lavoro con i dati e con la loro analisi

Partendo da questi elenchi, possiamo stilare le peculiarità di cui ogni piattaforma Dsml deve essere fornita:

- prevedere l’impiego di tutte le conoscenze e delle figure professionali necessarie

- permettere la totale governance dei dati in ognuna delle fasi necessarie, tra raccolta (e quindi anche l’importazione lungo la pipeline di dati), preparazione, esplorazione e relativa analisi

- creazione, test, distribuzione e riutilizzo dei modelli

- creazione, importazione e impiego di algoritmi

- integrazione (input e output) nei sistemi, nelle applicazioni e nei processi aziendali.

Ciò non esclude che queste caratteristiche possano essere fornite da due diverse piattaforme, magari integrando soluzioni Open source ad altre proprietarie, specialmente se ingegnerizzate all’interno dell’azienda che fa uso della piattaforma Dsml.

Benché l’integrazione di due piattaforme resti sostanzialmente un tabù per molte aziende, occorre valutare le realtà più piccole che possono avere budget limitati e che, in ogni caso, vogliono rimanere competitive sui mercati di riferimento.

Vantaggi dell’utilizzo di una piattaforma di Data science e Machine learning per le aziende

I vantaggi immediati sono due, uno conseguenza dell’altro. Le organizzazioni che fanno uso di piattaforme Dsml tendono ad aumentare il livello di organizzazione interna, perché ogni comparto aziendale può trarne beneficio, a partire dalla catena di approvvigionamento fino al marketing e alle vendite. Non è un caso che un Data scientist, sia sul piano funzionale sia su quello organizzativo, dovrebbe essere inquadrato tra i manager aziendali, perché è proprio a tutti i manager dell’azienda che deve parlare per fare passare i valori della scienza dei dati e del Machine learning. Il secondo vantaggio immediato è la competitività che l’uso delle discipline dei dati e della loro analisi permette di mantenere, quando non porta persino un vantaggio netto sulla concorrenza.

Ci sono vantaggi meno immediati i quali sono substrato di quelli più evidenti. Tra questi si possono citare:

- la possibilità di prendere decisioni migliori e più tempestive

- la capacità di identificare opportunità

- testare gli effetti delle decisioni prese con conseguente ridefinizione delle decisioni, laddove necessario

- rimodellare i flussi interni ed esterni

- migliore definizione (o ridefinizione) del target dei singoli prodotti o servizi

- effettuare assunzioni più mirate, capendo con chiarezza quale profilo serve in quale comparto aziendale.

Un elenco, anche in questo caso, non esaustivo ma puramente indicativo. I vantaggi variano a seconda del mercato in cui opera un’azienda, così come variano dalla cultura digitale che vige nell’impresa ma anche tra gli stakeholder.

I principali fornitori di piattaforme di Data science e Machine learning

Definire l’offerta ampia è persino eufemistico. Tra i leader del settore compaiono sempre i soliti noti (in rigoroso ordine alfabetico): Alphabet (Google), Amazon Web Services, IBM, Microsoft, Oracle e SAS.

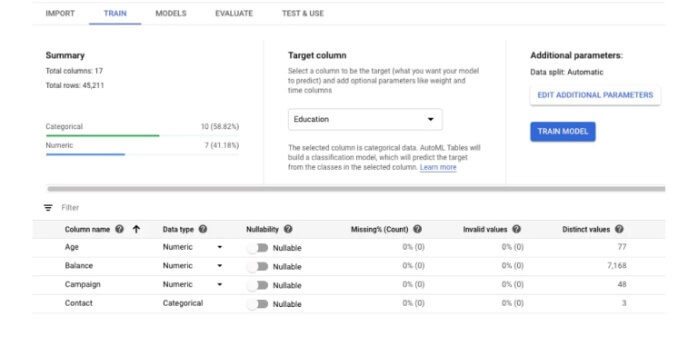

La piattaforma AutoML di Google merita un approfondimento. È una suite che si presta alle organizzazioni che hanno poca esperienza nell’ambito del Machine learning e, più in generale, nell’uso dei dati. Rende molto facile la creazione di modelli e l’interfaccia grafica richiama quella di qualsiasi suite con il marchio di BiG. L’abbiamo inserita in questo elenco perché può essere provata gratuitamente e questo consente alle aziende più restie di farsi un’idea con gli strumenti Dsml.

Ci sono soluzioni meno note che però, almeno a nostro avviso, devono essere citate. Le proponiamo soprattutto per le aziende meno orientate all’uso dei dati e, anche per questo motivo, ci siamo concentrati su piattaforme Cloud che non richiedono installazioni all’interno dell’azienda, limitando così i costi operativi.

Piattaforme di data science e machine learning, le altre soluzioni

H2O.ai

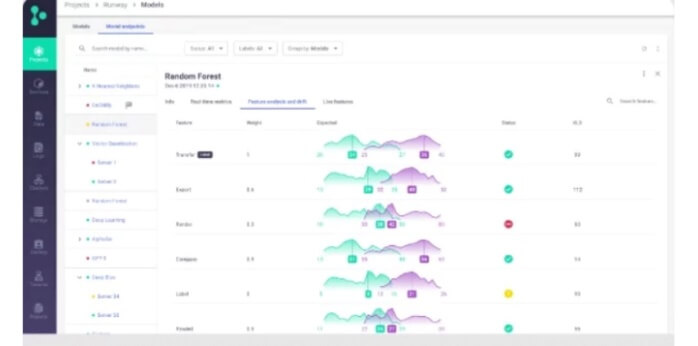

H20.ai mette a disposizione una vasta gamma di prodotti per la Data science e per l’AI e l’automatizzazione degli scenari eseguendo tutti gli algoritmi per individuare i modelli migliori. Si tratta, al pari delle soluzioni più conosciute, di una suite di prodotti che possono essere acquistati separatamente.

Uno dei punti di forza è la chiarezza restituita dalle dashboard, accessibili e interpretabili con facilità anche da chi è meno avvezzo all’uso di strumenti simili. Scendendo più in profondità, questa caratteristica contribuisce alla democratizzazione della Data science all’interno di un’organizzazione, anche grazie all’alto livello di automazione che fa leva su algoritmi statistici pronti all’uso. I prezzi sono rilasciati a chi ne fa richiesta e a seconda della configurazione necessaria.

Iguazio Data Science Platform

Altra piattaforma interessante è Iguazio Data Science Platform che copre le esigenze di data trasformation, scelta dei modelli di addestramento, le operazioni di sviluppo e dispiego e il monitoraggio dei modelli e dei risultati ottenuti. Una soluzione completa che però richiede un minimo di cultura data-driven e quindi la figura di Data scientist che conoscono il Python. Riteniamo che possa essere una piattaforma alla portata di qualsiasi organizzazione, perché la comunità di supporto del linguaggio Python rende disponibile codice per ogni necessità, senza bisogno quindi di scriverlo ex novo.

Come scegliere la piattaforma di Data science e Machine learning per l’azienda

Si parte da tre principi, il primo dei quali è inalienabile, mentre gli altri due hanno un aspetto variabile. Il primo è la semplicità d’uso. La cultura data-driven non dovrebbe essere soltanto appannaggio di pochi specialisti, dovrebbe invece pervadere tutta l’azienda, scegliere una soluzione che possa coinvolgere i collaboratori di ogni reparto aziendale è una scelta saggia.

I parametri variabili dipendono invece dalla disponibilità di figure specializzate (Data scientist) e dalla disponibilità di dati all’interno dell’azienda. Per quanto sia banale lo ripetiamo: senza dati di qualità non c’è soluzione Dsml in grado di svolgere appieno il proprio compito. Individuare gli utenti principali guida alla scelta della piattaforma, così come il loro grado di preparazione in materia di Data science. A seguire ha un peso il linguaggio di programmazione in uso nell’azienda, fermo restando che le piattaforme Dsml fanno largo ricorso a Python, R e Scala, linguaggio di coding diffusi tra chi si occupa di dati.

Fatte queste due considerazioni e trovate le debite risposte si può quindi optare per piattaforme più o meno automatizzate o che integrano funzionalità di pulizia, arricchimento e omogeneizzazione dei dati.

Allo stesso modo, a fare pendere l’ago della bilancia, contribuisce la necessità di combinare tra loro più fonti di dati e la necessità di integrare altri applicativi alle piattaforme Dsml. In genere le soluzioni Cloud rispondono affermativamente a tali requisiti.

Non da ultimo, c’è la questione della conformità dei dati, che approfondiremo in seguito ma che ha un peso specifico.

Le scelte possono essere pilotate dai budget disponibili ma, questa, è una considerazione che dovrebbe essere marginale perché, nelle organizzazioni in cui la cultura dei dati è diffusa, si comprende che si tratta di un costo che aiuta a generare profitti.

Piattaforme di Data Science e Machine Learning per l’analisi predittiva

Quando si parla di analisi predittiva si fa riferimento a un termine contenitore al cui interno vi sono diverse tecniche di statistica, di modellazione, di estrazione dei dati e di apprendimento automatico. Il fulcro è l’analisi dei dati storici per predire ciò che può potenzialmente accadere, identificando sia i rischi sia le opportunità. Ci si muove nell’ambito puramente statistico ma riuscire a fare analisi predittive è cruciale per prendere decisioni consapevoli.

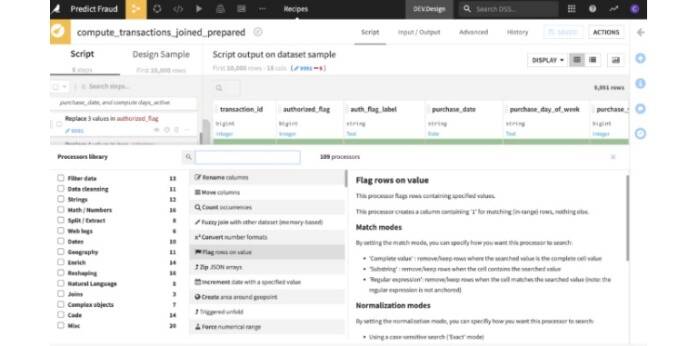

Dataiku

Dataiku si presta molto bene all’analisi predittiva, oltre a essere una piattaforma completa che permette di attingere dati da diverse fonti e a proporre soluzioni no-code per l’analisi, dedicate a chi non ha nozioni di programmazione. Tuttavia, considerando le potenzialità di Dataiku, è indicata a quelle aziende in cui ci sono Data scientist e la cultura dei dati è radicata. Anche in questo caso, la politica dei prezzi è resa nota a chi ne fa richiesta e varia a seconda delle necessità.

Tibco Data Science

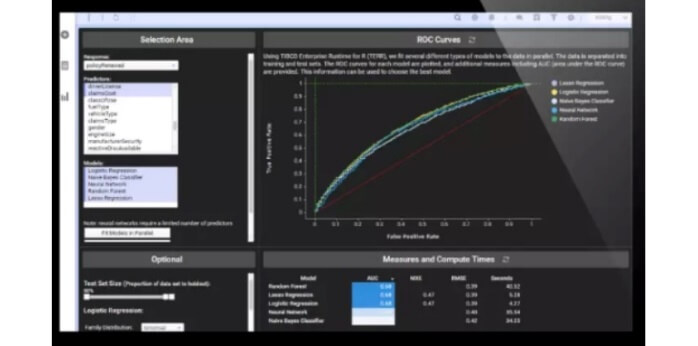

Altra soluzione sulla quale vale la pena riflettere è Tibco Data science che, oltre a mettere a disposizione i canonici tool per la creazione di modelli basati su dati, ha una vocazione all’analisi predittiva.

Si tratta di una piattaforma che predilige il “drag & drop” e che si rivolge anche a chi non ha nozioni di programmazione. Include anche decine di modelli pronti all’uso, senza escludere però l’intervento di sviluppatori e Data scientist, ai quali l’applicazione permette ampi spazi di manovra, anche nel campo dell’analisi dei dati, al cui proposito Tibco ha costruito un proprio motore – chiamato Tibco Enterprise Runtime for R (Terr) compatibile con il linguaggio R.

I prezzi vengono comunicati a chi ne fa richiesta, è però possibile provare la soluzione per 30 giorni.

Integrazione delle piattaforme di Data Science e Machine Learning con strumenti aziendali

Le soluzioni Dsml sono per lo più in Cloud, anche se ne esistono on-premise, ossia da installare fisicamente su server locali. In entrambe le configurazioni, l’integrazione delle piattaforme Dsml è data per scontata, giacché tutte prevedono di attingere dati da diverse fonti e di restituire informazioni all’interno dei flussi aziendali, interagendo tramite apposite interfacce o Api di facile implementazione e dispiego.

Le aziende che non hanno know-how interno devono fare affidamento sull’assistenza di chi fornisce la piattaforma e, in questo caso, ci si trova davanti a un’incognita. È vero che gli standard sono molto elevati e chi vende piattaforme Dsml ha tutto l’interesse a fornire un supporto di altissimo livello, è vero anche ha un senso – laddove l’azienda non ha sufficienti conoscenze interne – procedere con una versione demo della soluzione che si intende acquistare e, nella misura del possibile, fornire le informazioni più dettagliate circa la necessità di integrazione con applicazioni proprietarie la quale, va ribadito, non rappresenta di norma un problema insormontabile.

Sicurezza e conformità delle piattaforme di Data science e Machine learning

Sicurezza e compliance sono temi di indubbio spessore, ed è proprio per questo che le piattaforme Dsml offrono solide garanzie a riguardo. Occorre, tuttavia, approfondire l’argomento perché dal punto di vista della serietà, dell’immagine e della responsabilità, nessuna organizzazione può permettersi di non assumersi in prima persona la responsabilità del trattamento dei dati, scaricandolo alla peggio su enti terzi ed esterni.

Le piattaforme offrono degli standard di sicurezza Https, con l’autenticazione, la protezione e l’integrazione di dati mentre sono in transito. A ciò si aggiunge la possibilità di creare profili utente con accessi di diverso livello, per evitare che un collaboratore possa accedere a informazioni non in linea con il suo inquadramento professionale.

Ciò non basta, perché affrontando la questione della conformità l’argomento si complica. A titolo di esempio – il tema è davvero vasto – si sottolinea che in virtù del Gdpr – il Garante per la privacy portoghese ha multato a dicembre del 2022 l’ente di statistica nazionale (quindi un ente di natura pubblica ha multato un suo pari) per diversi motivi di conformità, tra i quali anche il fatto di non avere idea del percorso geografico seguito dai dati. Non si può lasciare questa responsabilità sulle spalle del fornitore di soluzioni Dsml, occorre quindi sapere dove i dati vengono archiviati ed elaborati, oltre a sapere qualche percorso seguono per arrivare a destinazione.

In materia di privacy non può valere la scontata filosofia secondo la quale, più un dato è sensibile e più va protetto: tutti i dati vanno protetti nel medesimo modo, a prescindere. Un simile approccio evita amare sorprese.

Piattaforme di Data science e Machine learning Open source

Ci sono soluzioni Open source le quali, in un modo o nell’altro, comportano dei costi. Pure scegliendo software completamente gratuiti, la loro implementazione necessita di hardware performante. Nasce quindi la sempiterna filosofia che divide i costi ammortizzabili da quelli da inserire nel conto economico. Scegliere una soluzione on-premise e sfruttare software Open source impatta sulle attività di bilancio, pagare un fee (per quanto alto) a chi offre servizi Cloud corrisponde ad avere una voce completamente spesabile e come tale a carico del conto economico.

Al di là delle disquisizioni economico-contabili, ci sono soluzioni diverse.

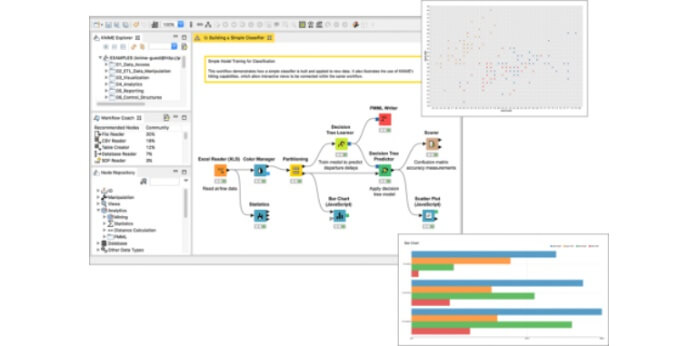

Knime

Una di queste è Knime, una soluzione Cloud che, nella sua versione gratuita, impedisce il lavoro in collaborazione. Delle versioni a pagamento sono apprezzabili la scalabilità, il controllo dei flussi e gli algoritmi di analisi predittiva. Necessita di figure con conoscenze approfondite di Python e R per customizzare l’esperienza d’uso.

Anaconda

Anaconda offre diversi prodotti, per lo più Open source, fruibili in modo gratuito con diverse limitazioni e, in alternativa, acquistabile a prezzi tutto sommato contenuti a seconda della formula desiderata. I prezzi della versione Enterprise sono resi noti a chi ne fa richiesta, ed è comunque pensata per organizzazioni di una certa grandezza.

Permette l’installazione on-premise e mette a disposizione client per computer con a bordo Windows, macOS e Linux. È una piattaforma votata all’uso di Python e R ma mette a disposizione pacchetti e moduli di facile istallazione che rendono abbordabile l’analisi dei dati anche a chi non ha approfondite conoscenze della materia. È una soluzione che si presta tanto alle piccole quanto alle grandi organizzazioni e si rifà, a seconda della versione, sia a chi ha poche conoscenze sia a chi ne ha di approfondite.

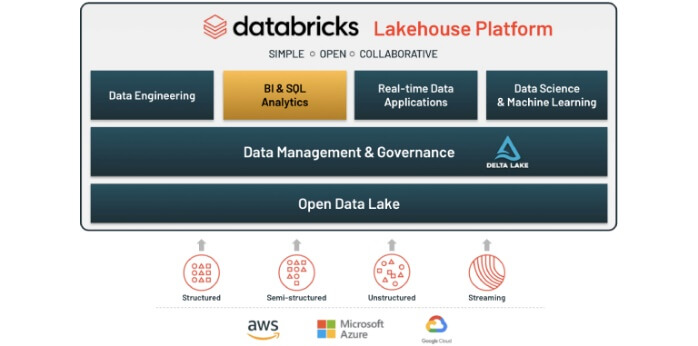

Databricks

Databricks, altra soluzione Open source, può essere provata gratuitamente e poi persegue una politica di tipo pay per use, con fatturazione corrispondente all’uso che se ne fa.

È una piattaforma Cloud implementata su Apache Spark e offre diverse suite: Databricks Workspace per il training e il dispiego di modelli, Databricks Runtime per la preparazione dei dati e per l’impiego di modelli di Machine learning.

Permette di usare diversi framework – anche questi Open source – ed è da considerare collaborativa nell’accezione più ampia del termine, garantendo l’integrazione con diverse librerie. L’apparente complessità dell’ambiente nel suo insieme non deve trarre in inganno: una delle leve positive di Databricks è la democratizzazione della tecnologia di analisi.

I test che abbiamo svolto hanno dimostrato la facilità con cui, per esempio, i risultati possono essere integrati in un ambiente R (e Java) in modo immediato e, da qui, elaborati e restituiti a un tool di rappresentazione grafica come Tableau.