Oggi le aziende sfruttano i dati come meccanismo per veicolare l’innovazione, i processi decisionali e affinare i prodotti e i servizi offerti, non solo nell’ottica di massimizzare i profitti e potenziare la propria presenza nel mercato, ma anche allo scopo di garantire, il più possibile, la soddisfazione dei consumatori. L’analisi dei dati consente di individuare meglio le effettive esigenze dei clienti, nonché di orientare, sulla base di queste ultime, le offerte e comprendere l’andamento dei mercati. Le aziende che fondano la propria strategia sul consumo dei dati sono definite data-driven company. Fino a pochi anni fa, esse utilizzavano prevalentemente dati reali, ossia informazioni basate su fenomeni ed eventi del mondo reale o relative a persone fisiche. Attualmente è possibile produrre dati sintetici.

Indice degli argomenti:

Data-driven company, cosa sono, come agiscono

Le aziende che fondano la propria strategia sul consumo dei dati sono definite data-driven company. In sostanza, organizzazioni di questo tipo impiegano grandi quantità di dati, costantemente raccolti in modo da garantirne “l’attualità”, con l’obiettivo di offrire prodotti e servizi aderenti agli effettivi trend dei mercati. Tipico è il caso delle società il cui core business consiste nelle attività di digital marketing: tendenzialmente, tali organizzazioni utilizzano e analizzano i dati reperiti dalle interazioni con il mercato per costruire relazioni più profonde e durature con i propri clienti.

Come affermato da Ginny Rometti, CEO di IBM, “l’uso dei Big data segnerà la fine della segmentazione delle fasce di mercato e costringerà le aziende a pensare a ogni cliente come singolo individuo”.

L’impiego di dati nell’ambito dei processi aziendali, dunque, non è più considerato, come accadeva nell’ambito di precedenti modelli di business, quale costo per l’impresa, bensì quale “fattore produttivo” idoneo a costituire fonte di orientamento strategico nell’ambito dei mercati.

In ogni caso, l’uso massiccio di dati non è limitato al solo mondo del customer engagement ma, anzi, si è esteso anche ad ambiti più produttivi; si pensi, ad esempio, all’utilizzo di algoritmi predittivi per meglio quantificare i lotti di produzione manifatturiera e quindi gli approvvigionamenti, o all’impiego di sonde IoT per la raccolta su larga scala in telemetria di dati relativi all’uso di macchine industriali o apparati elettronici, in base ai quali determinare non solo l’esecuzione di manutenzioni preventive e predittive ma orientare, altresì, la scelta sulla progettazione di nuove componenti.

Nello spostarsi dal fisico al digitale, l’utilizzo di grandi moli di dati per fornire prodotti e servizi sempre più conformi alle esigenze dei consumatori può essere colto negli algoritmi in base ai quali le piattaforme di erogazione di contenuti digitali propongono nuovi media ai clienti.

L’addestramento di intelligenze artificiali e algoritmi di supporto alla decisione, ad esempio, nell’ambito della c.d. computer vision, intesa come l’insieme dei processi volti a creare un modello approssimato del mondo reale (3D) partendo da immagini bidimensionali (2D) con lo scopo principale di riprodurre la vista umana, richiedono dataset immensi per una corretta esecuzione.

Diffusione dei dati sintetici

Attualmente è possibile, dunque, produrre dati sintetici di natura testuale, ad esempio mediante l’utilizzo di modelli di apprendimento automatico e scrittura testi, o, ancora, di natura audiovisiva, producendo immagini, video o suoni particolarmente vicini a quelli reali o, anche, dati sintetici di natura tabellare o transazionale, mediante simulazione di azioni, atti e fatti di qualsiasi natura (e.g. anagrafiche personali, dati medici, transazioni finanziarie).

Di recente, anche in considerazione delle esigenze di protezione dei dati personali emerse con l’entrata in vigore del Regolamento UE 2016/679, noto anche come GDPR, si sta assistendo a un progressivo aumento dell’impiego dei dati sintetici, utilizzati sia in via complementare ai dati reali che in sostituzione a questi ultimi. La circostanza per cui i dati sintetici siano esenti, quasi del tutto, dal campo di applicazione della normativa privacy, li rende, come vedremo nel prosieguo, particolarmente appetibili e li ha trasformati in vere e proprie opportunità per le imprese.

Dati sintetici: quali vantaggi per le aziende

Il fatto che i dataset sintetici siano, per l’appunto, creati artificialmente comporta una serie di vantaggi connessi al loro utilizzo in alternativa o congiuntamente ai dati reali.

Il primo vantaggio ravvisabile nell’impiego dei dati sintetici consiste, sicuramente, nella maggiore disponibilità di set di tali dati che, peraltro, possono essere prodotti on-demand, in base alle specifiche esigenze perseguite dal business.

Tali dati, inoltre, non dovendo essere raccolti sul campo, possono essere generati in grandi volumi relativi ad eventi, atti e fatti anche infrequenti in natura o il cui reperimento risulti tipicamente eccessivamente complesso e oneroso.

Un dataset reale presenterà, per sua stessa natura, una frequenza più bassa di esemplari relativi a eventi desueti. Per questo motivo il suo utilizzo per modelli di apprendimento automatico e validazione può portare a risultati inattesi all’approssimarsi di casi limite. Immaginiamo, ad esempio, uno strumento di visione artificiale da addestrare al supporto dell’agricoltura di precisione. Questo prodotto analizzerà immagini delle componenti della pianta andando alla ricerca di pattern di colore, texture o forme che ci diano informazioni sullo stato di salute del raccolto.

I dati su cui lo strumento viene addestrato presenteranno più campioni differenti relativi a eventi più frequenti (ad esempio parassiti o malattie comuni) e meno campioni differenti relativi a eventi più rari. Questo può determinare che l’addestramento dell’AI risulti carente o che la validazione non sia sufficientemente precisa, in quanto lo strumento viene sottoposto a un quantitativo di casi relativi agli eventi più infrequenti troppo basso.

Creando dati sintetici è possibile superare tale limite, inserendo immagini simulate degli eventi meno frequenti in modo da riequilibrare il dataset e consentire un addestramento anche in relazione a casi più rari.

In aggiunta a ciò, più tipicamente nel caso di dati sintetici tabellari, è possibile creare scenari di simulazione di trend futuri ipotizzabili, ma non ancora manifestatisi per validare la reazione dei sistemi decisionali a tali situazioni. Immaginiamo, ad esempio, un processo di gestione delle identità.

Nell’arco degli ultimi anni, la gestione delle credenziali si è spostata dall’uso di username e password a processi con autenticazione forte (e.g. autenticazione a due fattori o biometrica). In fase di test risulta necessario monitorare come lo strumento di gestione delle identità reagisca alla variazione delle frequenze relative delle tipologie dei metodi di autenticazione o addirittura a variazioni normative o di buone prassi. Un dataset sintetico può, in questo senso, generare moli di segreti di autenticazione compliant rispetto a trend o proposte normative in modo da consentire di testare lo strumento per renderlo future-proof.

Infine, altrettanto rilevante è la maggiore precisione ottenibile nella annotazione dei dati artificiali rispetto ai dati reali. Per poter essere consumati da processi di apprendimento, i dati devono prima essere annotati. Con tale ultima operazione, un dato o una porzione di esso viene categorizzato ed etichettato per ogni caso d’uso specifico.

Esempi di annotazione possono essere lo stato emotivo espresso, l’intento, la richiesta effettiva di un testo, il riconoscimento di dettagli, condizionati al caso d’uso, all’interno di un video o di un’immagine o di parole all’interno di un audio.

Maggiori sono la specificità e la precisione dell’annotazione, migliore è la qualità del modello ottenuto. Nel caso di dati reali questa operazione deve essere eseguita manualmente, con la conseguenza che la stessa rischia di risultare frequentemente imprecisa e comunque eccessivamente onerosa in virtù dell’esigenza da ripeterla in relazione a ogni specifico caso d’uso. I dati sintetici, invece, possono essere generati a partire dall’annotazione che devono avere, consentendo quindi un’annotazione precisa, contestualizzata al caso d’uso e soprattutto evitando l’attività manuale.

Si pensi, ad esempio, a un dataset artificiale di frasi che esprimono il livello di customer satisfaction; in tal caso, l’algoritmo di generazione che andrà a costruire il testo potrà già in partenza selezionare le label corrette per le quali produrre esempi di testo, senza incorrere quindi in errori di classificazione.

Dati sintetici a prova di GDPR

Come anticipato, uno dei fattori di maggiore slancio nell’impiego dei dati sintetici da parte delle aziende è rappresentato dalla tendenza, relativa a tale tipologia di informazioni, a sfuggire al campo di applicazione della normativa in materia di trattamento dei dati personali e, in particolar modo, del già menzionato GDPR.

Si ricorda, infatti, che la normativa privacy si applica alle operazioni di trattamento compiute sui dati personali relativi a persone fisiche identificate o identificabili, laddove, ai sensi dell’art. 4 del GDPR, “si considera identificabile la persona fisica che può essere identificata, direttamente o indirettamente, con particolare riferimento a un identificativo come il nome, un numero di identificazione, dati relativi all’ubicazione, un identificazione online o a uno o più elementi caratteristici della sua identità fisica, fisiologica, genetica, psichica, economica, culturale o sociale”.

A differenza dei dati personali, che rientrano ovviamente nel novero dei dati reali, i dati sintetici, in quanto artificialmente generati, non sono, quantomeno di regola, riconducibili a specifiche persone fisiche.

Inoltre, occorre precisare che il Considerando 26 del GDPR statuisce che “i principi di protezione dei dati non dovrebbero pertanto applicarsi a informazioni anonime, vale a dire informazioni che non si riferiscono a una persona fisica identificata o identificabile o a dati personali resi sufficientemente anonimi da impedire o da non consentire più l’identificazione dell’interessato. Il presente regolamento non si applica pertanto al trattamento di tali informazioni anonime, anche per finalità statistiche o di ricerca.” In quest’ottica, pertanto, la creazione di dati sintetici, sganciati dalla realtà effettiva e quindi anche da specifiche persone fisiche, consente di evitare il rischio di una violazione della normativa privacy, in particolar modo causata, ad esempio, dal verificarsi di una delle ipotesi riconducibili al concetto di “data breach”, come quella della perdita, del furto dei dati personali o dell’accesso e acquisizione non autorizzata degli stessi da parte di soggetti terzi.

Inoltre, l’utilizzo dei dati sintetici appare soddisfare in toto il c.d. principio di minimizzazione dei dati, in base al quale non devono essere raccolti e trattati dati non necessari rispetto alla finalità per la quale vengono raccolti e trattati. Del resto, nell’ambito dell’esecuzione di un bilanciamento di interessi che coinvolga, da un lato l’iniziativa imprenditoriale ad individuare la migliore strategia di mercato per affermare o rafforzare la proprio presenza nell’ambito dello stesso e, dall’altro, il diritto del singolo a non vedere eccessivamente violata la propria sfera di riservatezza, prevale, senza dubbio, quest’ultimo interesse, con la conseguenza che la strada più facilmente percorribile dalle aziende, al fine di operare in modo il più possibile conforme con la normativa privacy vigente, resta quella di avvalersi dei synthetic data.

Sotto il profilo puramente privacy, uno dei settori nell’ambito del quale l’utilizzo di questa tipologia di informazioni appare particolarmente vantaggioso è sicuramente quello farmaceutico e, comunque, sanitario in genere, considerato, infatti, che il trattamento dei dati di natura sanitaria subisce, ai sensi dell’art. 9 del GDPR, forti restrizioni e condizionamenti connessi alla particolare “sensibilità” dei dati stessi.

Creazione dei dati sintetici

Ad oggi, le modalità di generazione dei dati sintetici risultano essere molteplici. L’onerosità di tali metodologie dipende, ovviamente, dal livello di complessità del set di dati artificiali da produrre.

I metodi più semplici di creazione dei dati sintetici si fondano sulla generazione casuale di dati che abbiano una distribuzione statistica simile a quella nota per i dati reali, al fine di non differire troppo da questi ultimi. Tale ultimo meccanismo, per quanto efficace, in particolar modo in relazione a dataset semplici, soffre del seguente limite: la precisione dell’esito dell’operazione è direttamente dipendente dal livello di conoscenza del modello di riferimento da parte dell’analista.

Altro sistema applicabile in fase di creazione dei data set sintetici è il c.d. metodo Monte Carlo, applicabile laddove siano disponibili dati reali e il modello di distribuzione sia noto. Tale sistema consente di creare dati determinando l’associazione del dato sintetico al caso più probabile. In tal caso, il rischio è quello di creare dati “sovraspecializzati” in funzione della composizione originaria del dataset.

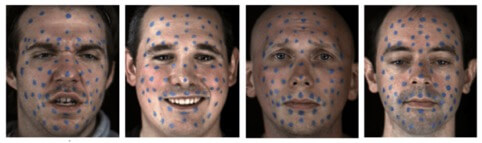

I modelli di creazione più contemporanei si basano su tecnologie di Deep learning. Uno dei modelli di maggiore interesse è quello delle generative adversarial network (GAN). In una GAN esistono due reti neurali in competizione tra di loro: un generatore e un discriminatore. Il generatore crea nuove istanze di dato sintetico a partire da input casuali, il discriminatore, una rete neurale addestrata a riconoscere set di dati reali, cerca di capire se le istanze di dato che gli invia il generatore siano reali o sintetiche.

Durante le prime iterazioni, il generatore produrrà dati poco verosimili che il discriminatore riuscirà a riconoscere facilmente come falsi. Alcuni dei dati prodotti dal generatore saranno, però, sufficientemente simili a quelli reali da ingannare il discriminatore. Il generatore cercherà quindi di produrre dati che abbiano caratteristiche comuni con quelle che hanno ingannato il discriminatore e il discriminatore stesso verrà addestrato nel riconoscere le differenze tra i dati reali e quelli sintetici. Il processo continua fino a che il generatore non produrrà istanze di dati che il discriminatore non può più distinguere dai dati reali. Al momento esistono GAN in grado di creare immagini realistiche di volti, oggetti, scrittura a mano libera, video, audio, dati tabellati.

Esempi di utilizzo dei dataset sintetici

Negli ultimi anni, il mercato dei dati fittizi si è dimostrato di particolare interesse per il settore dell’AI e del data management; sono molte, infatti, le società che hanno deciso di soppiantare, quasi in toto, nell’ambito dei propri processi, i dati reali con i dataset sintetici.

Tra le aziende che, ad oggi, fanno largo uso di tali tipologie di dati si annovera la John Deere, che impiega foto sintetiche per addestrare le proprie AI a riconoscere le piante infestanti in condizioni atmosferiche non ottimali e Amazon, che ricorrere ai dati sintetici per il training di sistema di riconoscimento del linguaggio di Alexa.

American Express, invece, impiega tali dati ai fini del riconoscimento delle transazioni fraudolente. Aziende come Google, Amazon, BMW e Tesla, inoltre, addestrano i loro sistemi di automotive su modelli quasi interamente composti dei dati sintetici.

Un esempio ulteriore è fornito dal caso della compagnia assicurativa svizzera La Mobilière, la quale ha scelto di portare avanti l’analisi predittiva sull’abbandono assicurativo utilizzando dati sintetici statisticamente rappresentativi, in modo da limitare il rischio relativo al trattamento di dati personali riconducibili alle categorie particolari di dati personali di cui all’art. 9 del GDPR.

Conclusioni: limiti e prospettive in materia di dataset sintetici

L’utilizzo di dati sintetici porta con sé intrinseche criticità legate ai metodi di loro generazione. Uno dei rischi maggiori è dato dalla circostanza per cui la creazione automatizzata di set di dati sintetici tende a determinare insiemi di input biased, in funzione del metodo di creazione e del set di dati reali di partenza. Nella pratica, questa criticità è spesso contemperata dall’introduzione periodica di dati reali nei processi di creazione e, quindi, da un impiego ibrido delle categorie di dati in oggetto. Questa soluzione, seppur efficace, diminuisce il vantaggio dato dall’esclusivo impiego dei soli dati sintetici e legato, come in precedenza detto, dalla mancata soggezione dei dati sintetici alla normativa in materia di protezione dei dati personali.

Altro rischio riscontrabile in fase di generazione dei dati sintetici è rappresentato dall’eventualità che il modello di analisi e di riduzione dimensionale del dataset reale non prenda in considerazione casi limite presenti nei dati reali e, quindi, non riesca ad addestrare correttamente rispetto a relazioni presenti ma non individuate dal modello. Questo rischio, minimo nei set di dati di scarsa complessità (si pensi, ad esempio, ai set fittizi di dati transazionali), si amplifica in relazione a dati il cui trattamento risulti complesso, come accade nel caso delle immagini o dei video.

Nonostante la sussistenza di tali criticità, la disponibilità on-the-fly di dati sintetici, nonché la loro maggiore semplicità di trattamento e la possibilità di produrre volumi di informazioni fittizie anche relative ad atti e fatti naturalmente infrequenti, rendono il settore dei synthetic data di estremo interesse per il business contemporaneo.

In tal senso, occorre rilevare come lo spazio delle soluzioni business di produzione di dati sintetici, che negli ultimi tre anni ha attirato 210 milioni di dollari di investimento, si stia popolando velocemente, con data provider che investono la propria attenzione a seconda del modello di dati (strutturati, testuali, tabellari, audio e video), degli use case (creazione di dati statisticamente correlati ai dati reali per condivisione o testing, generazione di dati sintetici per l’addestramento o validazione di modelli di AI o Machine learning, vendita di librerie di generazione) o del segmento industriale di riferimento (e.g. sanità, computer vision, modelli percettivi bidimensionali o tridimensionali, automotive, search and rescue indoor).