I contenuti multimediali sono diventati estremamente importanti nella vita di tutti i giorni. Quotidianamente persone da tutto il mondo condividono un enorme numero di immagini e video sui social network, dove questi contenuti possono facilmente diventare virali. La diffusione di strumenti di cattura a basso costo come smartphone, tablet, dispositivi indossabili e IoT ha contribuito ancor di più a rendere i contenuti multimediali uno dei principali veicoli di informazione. Nel frattempo, con la crescente domanda di fruizione e generazione di contenuti, si sono diffusi potenti strumenti di editing che consentono di manipolare immagini e video con estrema facilità. Sebbene tali applicazioni siano di grandissimo valore per molti professionisti nel mondo della fotografia, della grafica o della comunicazione, esse possono essere utilizzate anche per la generazione e diffusione di contenuti falsi o per scopi criminali. Recentemente, l’utilizzo di sofisticate tecniche di intelligenza artificiale ha attratto l’attenzione di moltissimi esperti e dei grandi player nel mondo informatico. Le più recenti reti neurali consentono infatti la creazione di contenuti completamente nuovi e fotorealistici, i cosiddetti Deepfakes, che sono in grado di ricreare volti di personaggi pubblici o generare volti artificiali completamente da zero. Un esempio interessante è questo video.

L’incredibile livello di accuratezza di queste tecnologie apre degli scenari fino a pochissimo tempo fa inimmaginabili, che potrebbero presto trovare applicazioni in molti campi come quello della medicina – dove i modelli generativi possono essere utilizzati per produrre dataset super realistici – o del cinema e delle arti creative in generale.

Sebbene queste tecnologie potranno contribuire allo sviluppo di molti settori [ vedi note B – C – D], esse al tempo stesso porteranno con sé molti nuovi problemi. La possibilità di creare contenuti iperrealistici genera nuovi rischi per molti processi di business in cui è richiesta un’analisi di contenuti multimediali. Mercati come quello assicurativo o della sicurezza potrebbero essere i primi e i più colpiti dai malintenzionati. Essere pronti e sapersi difendere da queste nuove potenziali minacce non è più un’opzione: presto molte corporate dovranno correre ai ripari, così come grandi colossi quali Google, Facebook e Microsoft stanno già facendo.

Figura 1. Esempio di deepfake riferito al presidente degli Stati Uniti Donald Trump.

Indice degli argomenti:

Come funziona un modello generativo

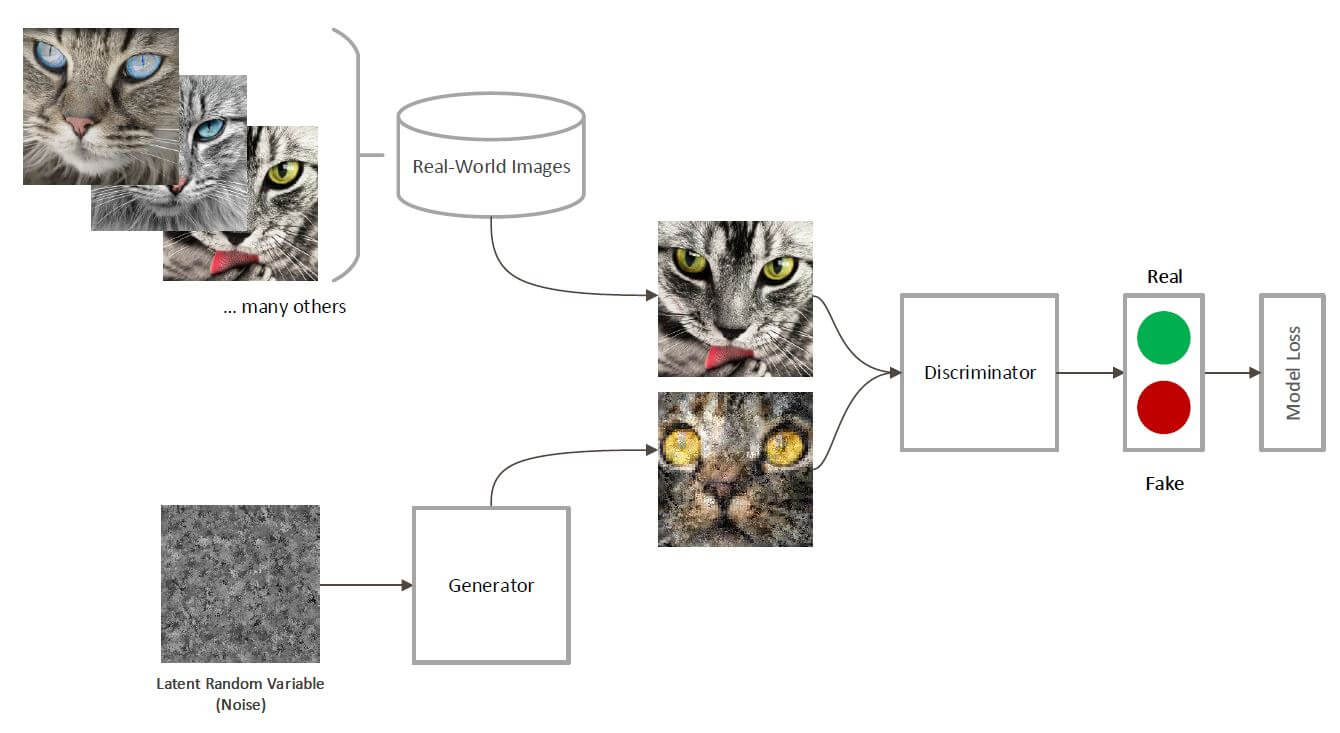

Ma come funziona un modello generativo? Non tutti sono perfettamente uguali, ma una famiglia di questi modelli ha sicuramente attratto l’attenzione più di altri: le Generative Adversarial Networks (o GAN, Goodfellow et al., 2014). Questo particolare tipo di rete neurale è costituita da due componenti: un generatore, cioè una rete neurale che impara a generare contenuti, e un discriminatore, cioè una rete neurale che impara a distinguere tra contenuti visivamente “reali” e contenuti generati. L’esempio in Fig. 2 mostra chiaramente uno di questi modelli in azione. Il generatore impara a generare foto di gatti, mentre il discriminatore distingue tra contenuti reali e falsi. In questa sfida, quando il generatore sarà divenuto abbastanza efficace, il discriminatore non sarà più in grado di distinguere tra il vero e il falso.

Innovazione e sicurezza nel digital banking: come guidare la trasformazione

Figura 2. Un esempio di modello generativo. Nelle Generative Adversarial Networks (GANs), il generatore impara a generare contenuti, mentre il discriminatore distingue tra contenuti veri (real) e contenuti falsi (fake). Nell’esempio, il generatore genera ancora gatti poco realistici. Una volta che questa rete avrà completato il suo addestramento, il generatore sarà capace di generare contenuti indistinguibili da quelli reali.

Deepfakes, i metodi per combattere le frodi digitali

Gli esperti di multimedia forensics studiano soluzioni per il riconoscimento di contenuti contraffatti da circa venti anni. Solitamente, i problemi vengono ricondotti a due grandi interrogativi:

- la verifica dell’autenticità, che ha lo scopo di capire se un’immagine o un video è stato manipolato con strumenti di editing come il più famoso Photoshop e, più di recente, riconoscere se un contenuto è stato generato artificialmente;

- la ricostruzione della sorgente del contenuto, vale a dire capire da quale modello di fotocamera o dispositivo è stato catturato il contenuto, o addirittura riconoscere se un file multimediale è stato scaricato da piattaforme social (Amerini et al., 2017) o applicazioni di messaggistica come WhatsApp.

Tutto questo è possibile attraverso elaborate tecniche di computer vision e signal processing, che insieme alle più recenti tecniche di intelligenza artificiale consentono di guardare immagini e video con occhi totalmente diversi. Il segreto, nella maggior parte dei casi, è nascosto nella parte invisibile (per noi umani) di questi contenuti.

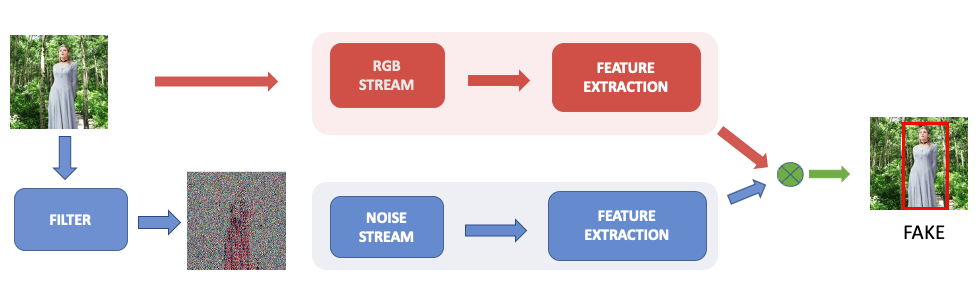

Attraverso l’utilizzo di particolari filtri, è possibile analizzare il file nel dominio della frequenza, dove le sottili tracce di manipolazione lasciano solitamente un’impronta. Negli ultimi anni, questo approccio è stato perfezionato grazie alle deep neural networks, che, attraverso una serie di trasformazioni dell’immagine fornita in input, riescono ad estrarre le informazioni più rilevanti e distinguere tra contenuti reali e contenuti manipolati (Amerini et al., 2019) (Mayer and Stamm, 2020). Analizzando le piccole differenze tra contenuti autentici e manipolati, le reti neurali profonde imparano a classificare correttamente le contraffazioni e a ricostruire l’area della manipolazione.

La sfida nello sviluppare misure di contrasto ai contenuti contraffatti deriva soprattutto dal numero molto esiguo di esempi di manipolazione. Per poter apprendere correttamente, le tecniche di machine learning possono richiedere migliaia o centinaia di migliaia di esempi. Generare un tale numero di manipolazioni risulta quindi molto spesso difficile se non impossibile. Di conseguenza, un trend molto recente è quello di analizzare le immagini anche con tecniche di anomaly detection per riconoscere disomogeneità rispetto a contenuti autentici (Wu et al., 2019).

Figura 3. Un esempio di architettura per il riconoscimento di immagini manipolate. La rete neurale è composta da due stream che analizzano l’immagine in due modi diversi. Uno stream analizza errori “semantici”, ovvero aree con degli elementi poco reali, mentre un altro stream analizza delle informazioni estratte tramite un filtro. Questo “rumore” consente di guardare l’immagine a un livello diverso rispetto a quello RGB, mettendo in risalto differenze tra la parte manipolata e la parte autentica dell’immagine. Nella figura, la donna aggiunta nell’immagine viene messa in risalto rispetto al resto dell’immagine dopo l’applicazione del filtro, generando un classico deepfake.

I benefici della fake/forgery detection per il business

Sapersi difendere dalle frodi digitali diventa necessario per moltissime realtà. A partire dalle fake news che possono facilmente rovinare la reputazione di un brand fino ai tentativi di frode nei casi in cui un’immagine o un video costituiscano una prova di risarcimento da parte dei consumatori, dai sistemi di videosorveglianza ai processi di autenticazione digitale, sapersi difendere vuol dire tutelare la propria azienda da diversi possibili attacchi.

Per esempio, tra i progetti innovativi portati avanti per conto del Consorzio ELIS da ELIS Consulting & Labs (consulting.elis.org) e dalla ELIS Digital University (digitaluniversity.elis.org), stanno portando al conseguimento di evidenti benefici il disegno e l’implementazione di:

- funzionalità di verifica automatica dell’integrità di carte di identità elettroniche e di riconoscimento di manipolazioni effettuate sullo stesso tipo di documenti;

- funzionalità di riconoscimento automatico di manipolazioni su volti fotografati, in base a disomogeneità riscontrate rispetto ai landmark caratteristici dei volti stessi;

- funzionalità di riconoscimento automatico di manipolazioni sul materiale fotografico relativo ai sinistri stradali per identificare eventuali tentativi di alterazione illecita atti a modificare e/o amplificare i danni mostrati dal veicolo fotografato.

I maggiori benefici per le aziende conseguenti all’utilizzo dell’intelligenza artificiale in questo contesto risultano essere i seguenti:

- rilevazione dei tentativi di frode assicurativa;

- automazione dei processi di riconoscimento delle manomissioni.

Ricerca e innovazione nei deepfakes

La tecnologia corre a una velocità sempre costante, e con essa la necessità da parte di molte corporate di reinventarsi ed innovare. Guardare al futuro è importante, e saper cogliere le giuste sfide al momento più opportuno può fare la differenza. L’open innovation ha aperto nuovi scenari di collaborazione tra il mondo industriale e il mondo accademico. La collaborazione tra questi due mondi si è rivelata fondamentale per ritrovare la capacità di innovare e reinventare il futuro. Università e industria parlano a volte linguaggi diversi e viaggiano su binari paralleli, ma dalla congiunzione dei due possono nascere collaborazioni molto interessanti.

I Joint Research Project del Consorzio ELIS sono un esempio di successo di questa collaborazione: 10 università e più di 30 aziende hanno raccolto i temi per avviare progetti di ricerca congiunta. La seconda edizione di questa iniziativa è in avvio nel periodo novembre/dicembre 2020, con l’obiettivo di definire un nuovo concetto di conoscenza intesa come ecosistema dell’apprendimento, all’interno del quale le imprese e le università coinvolte producano e scambino valore, favorendo la nascita di una prolifica community tra dottorandi, professori e referenti aziendali.

Sitografia

[C] https://www.technologyreview.com/2020/08/28/1007746/ai-deepfakes-memes/

Riferimenti bibliografici

Cyber-sicurezza avanzata: manuale per la protezione dei dati critici

- Ian Goodfellow, Jean Pouget-Abadie, Mehdi Mirza, Bing Xu, David Warde-Farley, Sherjil Ozair, Aaron Courville e Yoshua Bengio, Generative Adversarial Nets, 2014.

- Amerini, Irene and Galteri, Leonardo and Caldelli, Roberto and Del Bimbo, Alberto, Deepfake Video Detection through Optical Flow Based CNN, 2019

- Amerini, T. Uricchio and R. Caldelli, “Tracing images back to their social network of origin: A CNN-based approach,” 2017 IEEE Workshop on Information Forensics and Security (WIFS), Rennes, 2017, pp. 1-6, doi: 10.1109/WIFS.2017.8267660.

- O. Mayer and M. C. Stamm, “Forensic Similarity for Digital Images,” in IEEE Transactions on Information Forensics and Security, vol. 15, pp. 1331-1346, 2020, doi: 10.1109/TIFS.2019.2924552.

- Y. Wu, W. AbdAlmageed and P. Natarajan, “ManTra-Net: Manipulation Tracing Network for Detection and Localization of Image Forgeries With Anomalous Features,” 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), Long Beach, CA, USA, 2019, pp. 9535-9544, doi: 10.1109/CVPR.2019.00977.