La nascita di piattaforme digitali per lo sviluppo di contatti professionali e lavorativi ha portato a una evoluzione nelle operazioni di ricerca di un posto di lavoro. Come naturale conseguenza di questa evoluzione, l’ambito dei processi di human resource (HR), cavalcando l’onda della digital transformation, si è saputo rinnovare registrando grandi sviluppi. In particolare, se fino a poco tempo fa era più facile che l’headhunting e il recruiting si basassero su scelte pilotate dall’intuito degli addetti ai lavori o effettuate sulla base di credenziali dichiarate e non sempre perfettamente validate, oggi i processi HR si basano su analisi attente e obiettive che consentono di valutare quantitativamente il potenziale dei candidati e di orientare i processi di crescita, tenendo anche conto dei trend del business e quindi delle competenze di cui l’azienda potrebbe avrebbe bisogno in futuro. Ma qual è stato il motore di questa crescita? Dove è localizzato l’epicentro che ha dato origine a tale “onda di innovazione digitale”?

La risposta è: Big data. Queste due parole nell’ultimo decennio sono diventate la maggiore fonte di ricchezza della maggior parte delle aziende. Le enormi quantità di dati che possediamo (destinate a raddoppiare ogni due anni) non possono e non devono essere ignorate per sviluppare piani di business di successo. È in questa selva di dati che spesso l’expertise degli addetti ai lavori invoca l’aiuto dell’artificial intelligence (AI) e del machine learning (ML). Nell’epoca dei Big data infatti, oltre all’occhio, all’intuito e alle attente analisi degli esperti del settore, algoritmi di AI e di ML possono supportare l’automazione di task particolarmente onerosi in termini di tempo, ottimizzando così i processi di HR.

Indice degli argomenti:

NLP, gli algoritmi più efficaci

La pressante richiesta di soluzioni nell’ambito HR ha portato la ricerca scientifica verso lidi ancora inesplorati grazie all’applicazione e al perfezionamento degli algoritmi di Natural Language Processing (NLP).

L’NLP rappresenta quella branca dell’AI che riunisce le tecniche volte a fare in modo che una macchina possa interpretare, elaborare e comprendere il linguaggio umano (o linguaggio naturale), con il fine di riportare le informazioni scritte o parlate in una forma di dato ben strutturato e utile a successive analisi. Già da questa breve descrizione, si può capire come tale processo non sia affatto banale a causa delle molte regole nonché delle frequenti eccezioni e della continua mutevolezza del linguaggio. Per questo motive, gli algoritmi di NLP che ad oggi garantiscono robustezza risultano molto articolati e con molti livelli paralleli di processamento delle informazioni.

Non è più pensabile gestire l’enorme mole di CV in assenza di meccanismi che riescano ad automatizzare le operazioni di individuazione ed estrazione delle competenze. Nel caso delle attività di recruiting e people management, il supporto dell’NLP è relativo proprio all’elaborazione delle informazioni scritte nei CV o nei profili personali.

Come anticipato, la robustezza degli algoritmi di NLP è garantita da una parallelizzazione della struttura architetturale che consente loro di processare i dati esaminandoli dai seguenti punti di vista.

- Analisi Lessicale: scomposizione di un’espressione linguistica nei suoi elementi atomici (in questo caso le parole o token) per poi applicare algoritmi di matching con basi di dati standardizzate Direct Matching.

- Analisi Grammaticale: marcatura in maniera supervisionata di una parola (token) in un testo come corrispondente a una parte specifica del discorso Part of Speech (PoS) Tagging.

- Analisi Sintattica: riconoscimento di pattern ricorrenti nella struttura del periodo Rule-Based Text Mining.

- Analisi Semantica: assegnazione di un significato alla parola non in quanto “entità atomica a sé stante”, ma afferente al contesto dell’espressione linguistica da cui viene estratta, per evitare eventuali ambiguità nell’interpretazione Bidirectional Encoder Representations from Transformers (BERT) Embeddings.

In questo scenario, ELIS Innovation Hub (EIH) – Che cosa facciamo – Elis – si inserisce per fornire, alle corporate del Consorzio ELIS, un supporto che affonda salde radici nelle ultime frontiere della ricerca scientifica, in collaborazione con le università e i maggiori centri di ricerca in Italia.

In particolare, un team composto da due ingegneri automatici (Valerio Paduano e Federico Kieffer) e guidato da un dottorando in ingegneria informatica (Jesus Cevallos) ha realizzato due soluzioni, proposte nel seguito di questa sezione, per una gestione ottimizzata del patrimonio informativo delle competenze, esperienze e interessi dichiarati esplicitamente dai dipendenti aziendali.

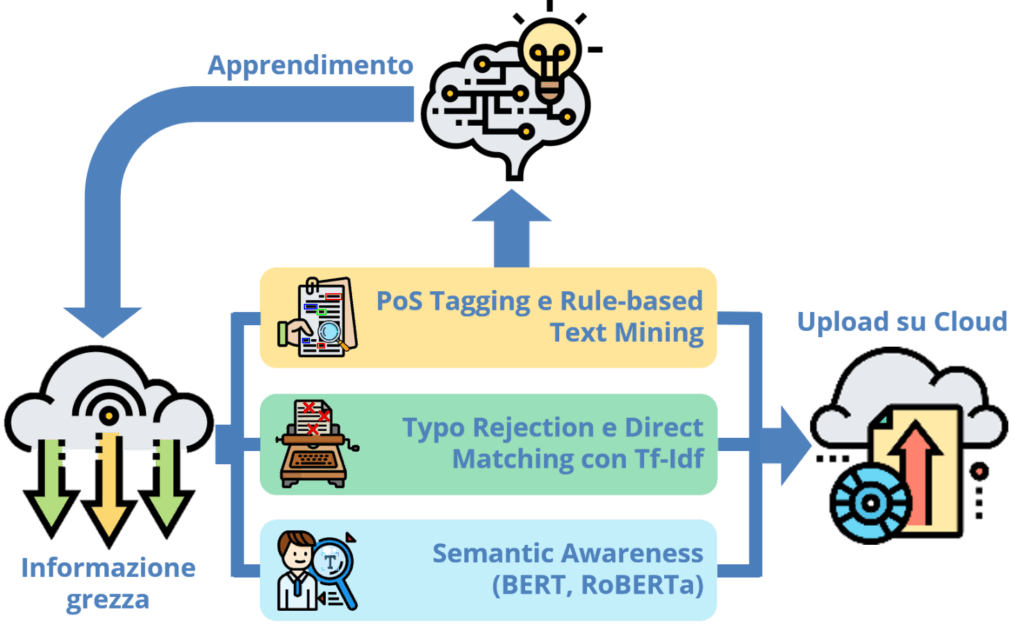

In Figura 1 è riportata la prima architettura sviluppata dal team di EIH e caratterizzata dagli elementi funzionali sopra introdotti (analisi lessicale, analisi sintattica, analisi grammaticale e analisi semantica). L’architettura funzionale è costruita a partire da database standardizzati che costituiscono un dizionario di competenze, qualifiche e occupazioni valido come riferimento per la comunità internazionale (come, per esempio, ESCO e O*NET).

Figura 1: Architettura funzionale per l’estrazione e la standardizzazione delle competenze dichiarate dai dipendenti/candidati nel loro CV

In particolare, l’architettura è strutturata su tre livelli o layer paralleli che processano informazioni relative alle competenze dichiarate dai dipendenti aziendali e raccolte dall’azienda nel proprio dataframe distribuito (per esempio, Cloudera, Azure Databricks, Google Cloud). Nello specifico, i tre livelli sono definiti come segue.

- Livello 1: tramite reti neurali, viene eseguita l’analisi grammaticale offerta dal PoS tagging, ulteriormente accompagnata da regole di identificazione di pattern sintattici ricorrenti. In questo layer è anche presente una fase in cui l’AI apprende come riconoscere nuove competenze non presenti nei database standard di riferimento.

- Livello 2: tramite tecniche di Machine Learning viene eseguita l’analisi lessicale e il successivo Direct Matching. In particolare, un algoritmo di TF-IDF (Term Frequency – Inverse Document Frequency), tramite l’applicazione di metriche di similarità, permette di ricavare uno score di somiglianza tra la singola competenza dichiarata dal dipendente nel CV e la corrispondente competenza disponibile nel database di riferimento. Questo layer è preposto a rendere l’algoritmo robusto anche rispetto ad eventuali refusi nei dati di input (cioè l’informazione grezza relativa alle competenze dichiarate dal dipendente aziendale e disponibili sul dataframe).

- Livello 3: tramite reti neurali bidirezionali profonde, viene analizzato il contesto della frase in input. Più nel dettaglio, utilizzando encoder bidirezionali vengono calcolati gli embeddings necessari per poter effettuare un confronto semantico tramite convoluzione vettoriale. Questo layer è preposto a rendere l’algoritmo robusto anche rispetto a criticità semantiche che si possono presentare nell’input.

Da questi tre livelli vengono quindi estratti tre insiemi di competenze infine riunificati opportunamente e riorganizzati sull’ infrastruttura cloud.

Il raggio d’azione dell’NLP non si limita alla, seppur consistente e robusta, estrazione e standardizzazione di informazioni. Le potenzialità di queste tecnologie sono ancora innumerevoli e per certi versi ignote, perché ancora oggetto di ricerca scientifica.

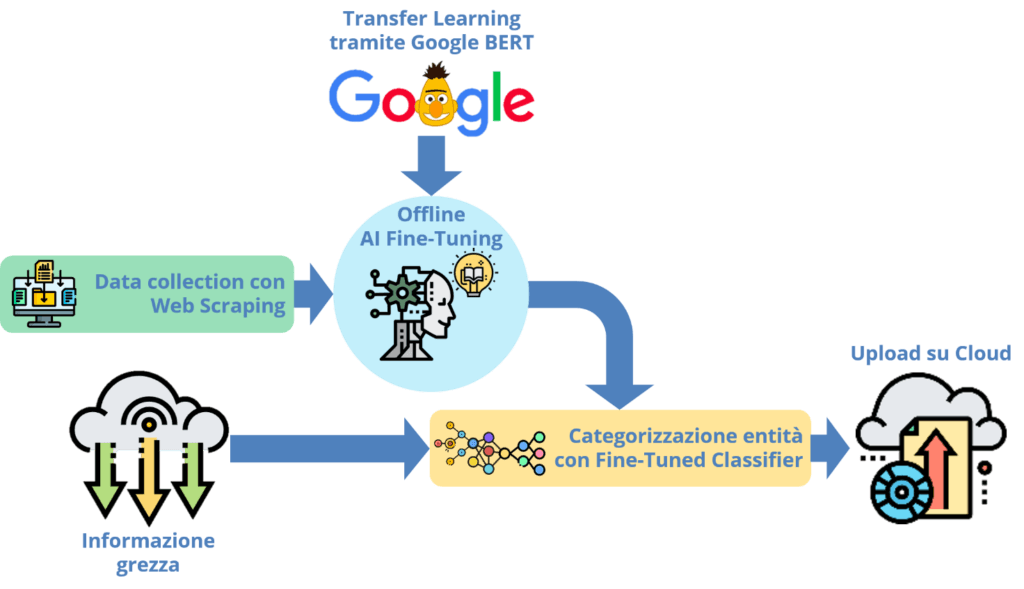

Proprio muovendosi in una direzione estremamente innovativa, il team di EIH ha realizzato la soluzione proposta in Figura 2 relativamente all’inferenza di competenze a partire da entità diverse come: esperienze formative, accademiche, lavorative, nonché interessi ed hobbies dichiarati dal dipendente/candidato.

In particolare, sfruttando tecniche di Transfer Learning a partire dall’algoritmo Google BERT (BERT (language model) – Wikipedia), è stato effettuato un fine-tuning che ha permesso l’apprendimento efficace delle correlazioni che ci sono tra le suddette entità dichiarate e le competenze (sia hard che soft) raccolte nei dizionari di riferimento.

Figura 2: Architettura funzionale per l’inferenza delle competenze a partire da esperienze e interessi dichiarati dal dipendente/candidato

Le performance osservate sono già molto incoraggianti nonostante la penuria di dataset in questo ambito. È proprio questo l’unico limite: la mancanza di dataset ben strutturati che permettano di connettere competenze con altre entità tipicamente valutate, nelle fasi di recruiting e staffing, dagli esperti del settore HR. Questo limite può tuttavia trasformarsi in una ghiotta opportunità nel momento in cui si riesca a instaurare una collaborazione virtuosa tra esperti di analisi dati ed esperti HR.

Human resource in una visione data driven

Il percorso verso una visione data-driven, come già ampiamente sottolineato, “obbliga” le aziende a concepire i dati non più come elementi tecnici finalizzati a “nascere, crescere e morire” nelle sezioni IT, ma come fulcro strategico degli investimenti. Per un concreto cambiamento di passo, questa cultura del dato sta ormai pervadendo ogni funzione aziendale, inclusa quella HR.

In tale contesto, le opportunità conseguenti all’applicazione delle tecniche di NLP analizzate sono molteplici, come per esempio le seguenti.

- Supporto all’upskilling e al reskilling. Si parla spesso di continuous learning o lifelong learning ma la grande e variegata offerta formativa di cui le organizzazioni spesso dispongono è a volte difficile da valutare, clusterizzare e suggerire in relazione al profilo professionale di ognuno di noi. Le soluzioni mostrate sopra possono abilitare la pianificazione sistematica di interventi formativi personalizzati. In altri termini, è possibile predisporre dei piani/corsi di formazione calibrati sul profilo specifico della persona.

- Supporto alla creazione di team Agile ben bilanciati. Le soluzioni di intelligenza artificiale proposte possono abilitare l’ottimizzazione dei processi di staffing, rendendo questi ultimi adattivi in funzione delle esigenze dell’azienda, con conseguente aumento di efficienza ed efficacia nella fase di definizione del team di lavoro, le cui performance potranno in tal modo essere maggiormente rispondenti alle aspettative.

- Consolidamento dell’assessment delle competenze della popolazione aziendale. L’estrazione automatica delle competenze dei dipendenti e/o di futuri collaboratori consente di velocizzare e oggettivizzare la rilevazione delle conoscenze, punti di forza e aree di miglioramento di ciascun dipendente, favorendo la job rotation, sia orizzontale (cioè la rotazione su ruoli di pari livello all’interno di uno specifico settore aziendale) sia verticale (in vista di promozione a ruoli di responsabilità crescente).

Ricerca e innovazione

Chi tra i lettori già conosce EIH saprà che ormai da un anno è in corso l’iniziativa dei Joint Research Project, esempio di successo della collaborazione tra università e industria. Al seguente link si può trovare una descrizione dettagliata per conoscere meglio l’iniziativa: Joint Research Project – Mindset revolution (elis.org)

La terza edizione dei Joint Research Project sta prendendo il via in questi mesi, questa volta in seno al programma Open Italy 2021 (Open Italy (elis.org). Si tratta di un programma di Open & Collaborative Innovation all’interno del quale stakeholder eterogenei si confrontano e lavorano insieme per incentivare l’introduzione e lo sviluppo di soluzioni innovative nel tessuto economico italiano, favorendo la cultura dell’open innovation.

Con riferimento a otto perimetri di innovazione (tra i quali anche quello del Digital HR) saranno avviati nuovi progetti di ricerca e sviluppo, all’interno dei quali le imprese e le università coinvolte produrranno e scambieranno valore su numerose tematiche emergenti, alimentando una prolifica community di dottorandi, ricercatori, professori e referenti aziendali.