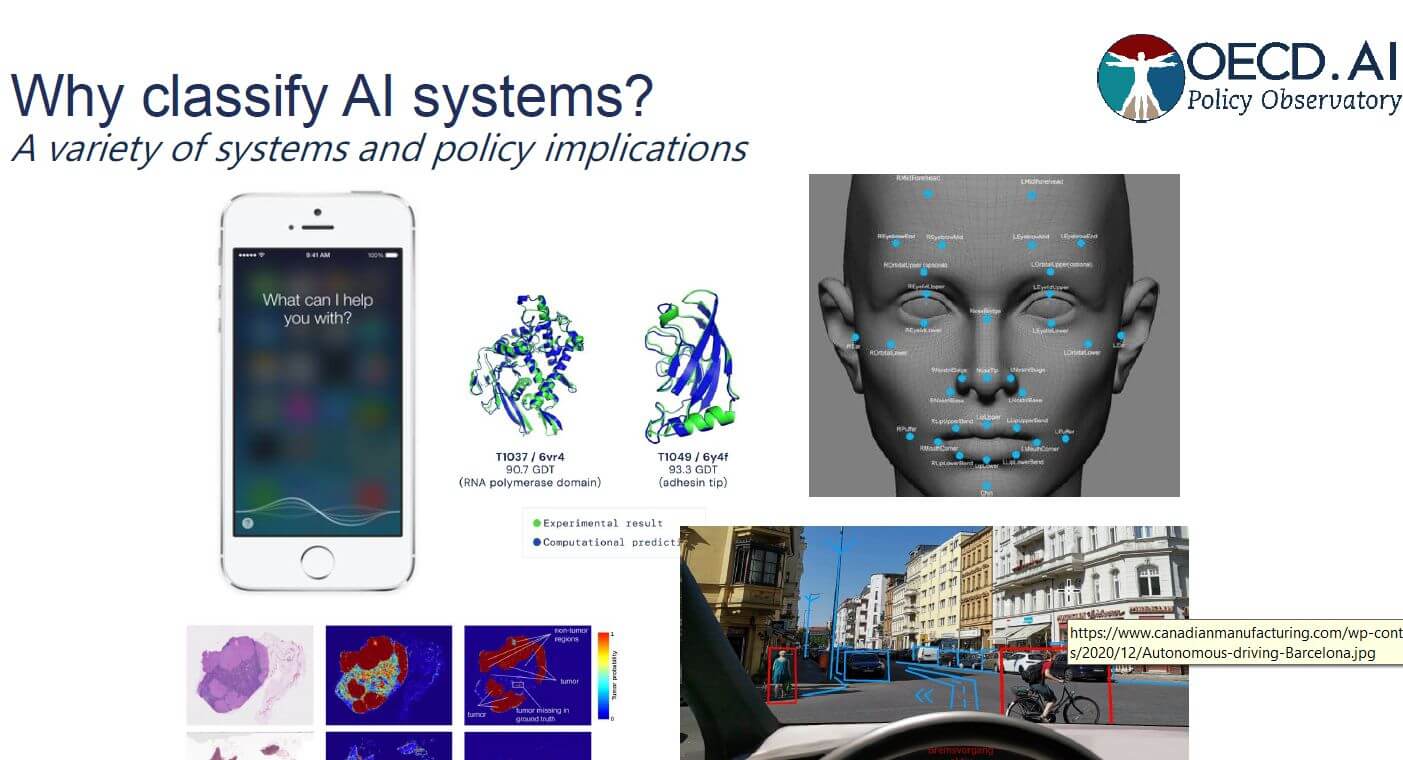

I sistemi di AI, che man mano si diffondono nei più vari settori, hanno bisogno di essere valutati e classificati in un’ottica di rischio e beneficio. È questo l’obiettivo del framework sviluppato dall’Ocse (Oecd) che è stato concepito per fornire uno strumento utile a regolatori e legislatori dei paesi membri per orientarsi in questa nuova complessa materia.

Indice degli argomenti:

Framework Ocse AI: il quadro generale

Scopo principale del lavoro Ocse, lanciato il 22 febbraio 2022, è caratterizzare l’applicazione di un sistema AI implementato in un determinato contesto e progetto. Anche se il framework può avere validità nel contesto di un’analisi più generale sull’impatto dell’intelligenza artificiale.

Secondo i “Principi AI” dell’Ocse, adottati nel maggio 2019, un sistema AI è “un sistema basato sull’utilizzo di una macchina” che, per una determinata serie di obiettivi definiti dall’uomo, è in grado di fare previsioni, raccomandazioni o assumere decisioni che hanno effetti su ambienti reali o virtuali. Esso impiega input che provengono da altre sorgenti-macchina o direttamente dall’uomo, per percepire ambienti reali e/o virtuali. Trasforma altresì tali percezioni in modelli astratti (in maniera automatizzata, per esempio con un trattamento-processo ML o manualmente) e usa modelli di deduzione logica per formulare scelte, al fine di ottenere un’informazione o definire un’azione. I sistemi AI sono, del resto, progettati per operare con diversi livelli di autonomia.

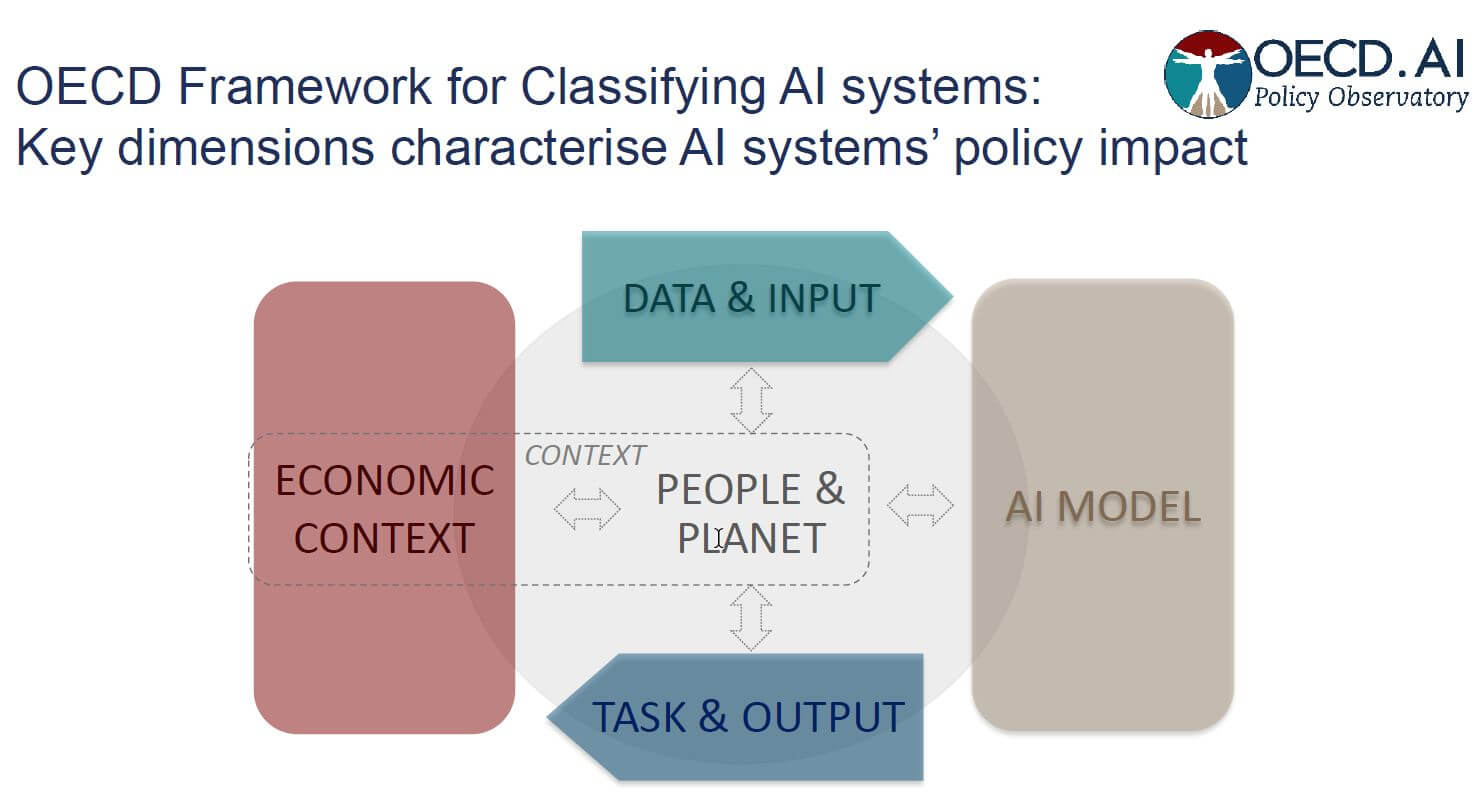

Framework Ocse AI: le cinque dimensioni

Il framework Ocse, che si ricollega ai Principi e ha una natura dinamica, perciò passibile di periodiche revisioni, classifica i sistemi AI secondo cinque differenti dimensioni:

- People & Planet

- Economic Context

- Data & Input

- AI Model

- Task & Output.

Ogni dimensione ha distinte proprietà e attribuiti, o sotto-dimensioni, che concorrono nelle valutazioni di policy associate a un particolare sistema AI.

Lo scopo della divisione in dimensioni è quello di aiutare a organizzare la classificazione degli aspetti fondamentali di un sistema AI, a chiarirne il funzionamento, dove si collocano le responsabilità e in che modo le sue applicazioni possono incidere su persone e ambienti in cui operano.

Persone & Pianeta

La dimensione People & Planet è centrale nel framework. Sulla sua base, si considera come i sistemi AI possano essere sviluppati in accordo con i valori umani e a vantaggio di persone e pianeta.

In questo quadro, si individuano i soggetti, individui e gruppi, che interagiscono (utenti) o sono interessati (stakeholders), direttamente o indirettamente, dall’applicazione di un sistema AI in un determinato contesto. Gli utenti, distinti dagli sviluppatori o da coloro che implementano l’AI, possono avere vari gradi di competenza, da quello amatoriale al livello di esperto – il che è importante per i termini di responsabilità, trasparenza e AI spiegabile (XAI) – mentre gli stakeholder possono essere ad esempio singoli consumatori, lavoratori oppure aziende, associazioni e agenzie governative che non necessariamente interagiscono con il sistema d’intelligenza artificiale. Un altro aspetto di valutazione è quanto opzionale sia l’applicazione AI per utenti e stakeholder, o se il coinvolgimento sia attivo ovvero passivo.

In un senso più ampio, viene esaminato il possibile impatto, negativo o positivo, di un sistema AI su benessere sociale, ambiente, e diritti umani, che discrimina situazioni di alto o basso rischio.

Sotto questo aspetto, nel documento si citano esempi di applicazione AI in un ambito di decisione giudiziaria, o nel campo del recruiting. In tali settori, in cui il rischio può essere alto, sono necessari meccanismi formali di responsabilità e trasparenza, che ricomprende il tema del ruolo AI e del coinvolgimento umano nel processo. In questa dimensione, viene presa in considerazione l’aumentata capacità AI di automatizzare compiti e di incrementare la produttività che hanno effetti sul lavoro umano, anche nella sfera dei colletti bianchi.

Contesto economico

Questa dimensione fa riferimento all’ambiente economico e settoriale nel quale si implementa un sistema AI. In generale, si valuta l’applicazione dell’AI e si descrive l’ambito organizzativo e funzionale per i quali un sistema AI è sviluppato. Viene inoltre definito il settore in cui l’AI è implementata (esempio: sanità o finanza) chiarendone funzione e modello di business, aspetti critici, e maturità tecnologica. Ogni settore industriale evidenziato costituisce un differente contesto che ha differenti implicazioni in termini di struttura e regolazione per i sistemi AI. Stessi tipi di sistemi AI possono essere impiegati in più settori e svolgere compiti simili in diverse aree funzionali.

Ma le implicazioni sul piano degli orientamenti da adottare non sono le stesse. Un algoritmo predittivo utilizzato per ottimizzare la logistica può non avere uguali effetti se applicato al campo del recruiting.

Attori chiave di questa dimensione sono gli operatori di sistema che pianificano, progettano, gestiscono e monitorano i sistemi d’intelligenza artificiale.

Il framework integra l’approccio sul rischio proposto nelle nuove regole e azioni stabilite dalla Commissione europea nell’aprile 2021, volti a garantire fiducia, efficienza e affidabilità per i sistemi AI.

Dati & Input

La dimensione Dati & Input concerne i dati e gli input di esperti (conoscenza umana codificata in regole), entrambi generati da esseri umani o da algoritmi di apprendimento automatico, con i quali un modello AI realizza una rappresentazione del contesto e dell’ambiente.

In questa dimensione rileva che dati e input siano considerati in base alla provenienza, al metodo di collezione ad opera della macchina, sensori e/o dell’uomo e all’origine. Conta anche la struttura, il formato e la proprietà dei dati così come qualità e adeguatezza e caratteristiche tecniche.

I dati possono essere raccolti ed elaborati sia nella fase di training di un sistema AI (in the lab) sia durante la produzione (in the field).

Il framework valuta l’evoluzione dei sistemi AI che partendo da una intelligenza artificiale simbolica, basata su sistemi logici costruiti dagli uomini, sono diventati sempre più statistici e probabilistici e alimentati da un crescente varietà di dati. La maturità delle “reti neurali”, tecnica di modellizzazione dell’apprendimento automatico (ML), insieme alla disponibilità di grandi quantità di dati ed a una incrementata potenza di calcolo, è all’origine dell’espansione dello sviluppo dell’AI.

Soggetti fondamentali di questa dimensione sono chi raccoglie e processa i dati, depurandoli, etichettandoli, eseguendo controlli su completezza e qualità e indicando le caratteristiche dei dataset.

Modello AI

Per esaminare e classificare i sistemi d’intelligenza artificiale è necessario identificare gli elementi di un modello AI. In questa dimensione, vengono considerati i modelli AI e i suoi componenti fondamentali, sotto l’aspetto del modo in cui sono costruiti (con uso di conoscenza specialistica e/o machine learning), di come sono interconnessi tra loro e come sono utilizzati nella produzione, o sul campo (model inferencing). Nella sezione viene sottolineato come un modello AI assorba congetture e pregiudizi dall’ambiente circostante e non abbia un carattere universale. In realtà, si dovrebbe parlare di molti modelli AI dal momento che la maggior parte di sistemi AI si avvale di modelli compositi. Google Photo, nota app di Big G di archiviazione e ricerca di immagini, è un esempio di come si possano sfruttare più modelli.

Ai fini della definizione di una policy pubblica, questa dimensione assume importanza in quanto le proprietà chiave dei modelli d’intelligenza artificiale (livello di trasparenza e AI spiegabile, robustezza e implicazioni su diritti umani, equità e privacy) dipendono dal tipo di modello, dalla sua costruzione e dai processi d’inferenza.

Sistemi AI che utilizzano reti neurali sono, per esempio, più affidabili in termini di accuratezza ma meno in un’ottica di AI spiegabile (essendo più complessi).

Attori principali considerati in questa dimensione sono sviluppatori e coloro che costruiscono, utilizzano, verificano e convalidano modelli AI.

Compiti & Output

Si tratta di una dimensione che approfondisce i compiti che un sistema AI esegue: identificazione e classificazione dei dati; connessione data point per rilevare modelli e anomalie; previsione; personalizzazione, ossia sviluppo di un profilo individuale e adattamento; supporto all’interazione (tra macchina e uomini con ausilio multimediale di testo immagini e voce); ottimizzazione guidata da obiettivi; modellazione e simulazione. Ma si descrivono anche i risultati e le azioni che ne derivano.

In questa dimensione si descrivono i compiti di sistema, l’autonomia di azione, i sistemi che contemplano in modo combinato compiti e azioni come i veicoli a guida autonoma e la IoAI (AI e Internet delle cose) nonché le principali aree di applicazione come la visione artificiale e la robotica.

Tra i benefici quello della personalizzazione che può incidere positivamente su strutture e benessere sociale e degli algoritmi di event detection che possono avere impatti positivi su sicurezza e più complessivamente su persone e pianeta. Nei rischi, vanno annoverati quelli sui diritti umani che possono determinare i sistemi di riconoscimento di dati biometrici o quelli della stessa personalizzazione che può entrare in conflitto con il diritto all’auto-determinazione o contribuire alla disinformazione e all’effetto camera d’eco.

Ciclo di vita dei sistemi AI

La dimensione è associata alla fase di implementazione del ciclo di vita di un sistema AI che, secondo i Principi Ocse, comprende:

- pianificazione e progettazione, raccolta ed elaborazione dei dati e costruzione del modello ed interpretazione;

- verifica e convalida;

- dispiegamento

- funzionamento e monitoraggio.

Il framework Ocse utilizza questo quadro come struttura complementare per comprendere le caratteristiche tecniche chiave di un sistema AI. La classificazione dei sistemi d’intelligenza artificiale è correlata alle diverse fasi del ciclo di vita AI per identificare i differenti attori principali connessi a ciascuna dimensione, stabilendo un collegamento con responsabilità e gestione del rischio.

Conclusioni

Lo sviluppo dell’intelligenza artificiale tende a superare i confini nazionali e a collocarsi su un piano globale. Pertanto, è fondamentale che i governi, in collaborazione tra loro e con piattaforme e organizzazioni transnazionali, lavorino per stabilire standard condivisi e ci siano strumenti, questa è l’ambizione del framework Ocse, che promuovano una comune comprensione, valida sempre più internazionalmente, sui sistemi AI per ridurre rischi e creare condizioni più vantaggiose per individui, aziende e società.