Steve Benton, una delle colonne del Media Lab di Boston, diceva: “l’olografia ha due significati nel nostro mondo: la scoperta specifica dell’interferenza e della diffrazione, vincitrice del Premio Nobel, di Dennis Gabor, e la più generale “imaging 3D del futuro”, come quello previsto nei film e in Tv.” E come missione del proprio lab aggiungeva: “il nostro compito è spostare la seconda accezione di olografia, verso la realtà, senza violare più di una legge fisica alla volta”.

Indice degli argomenti:

Gli ologrammi, cosa sono

Sono qualcosa che sembra apparire nello spazio, proprio come farebbe un oggetto reale. Come? Essenzialmente, causando l’interazione delle onde di luce in un punto specifico e rendendola visibile ai nostri occhi. In questo modo essi possono creare l’illusione di un intero oggetto “fatto” di luce.

Scopri i trend AI del 2025: Scarica il report degli Osservatori del Politecnico di Milano

Cosa non è un ologramma. Non lo sono le immagini a LED rotanti, i display 3D, la realtà virtuale e l’AR. Sono tutte tecnologie simili agli ologrammi, ma non lo sono esattamente. Anche le cornici 3D di Looking Glass non sono ologrammi, sono immagini 3D senza occhiali, la stessa tecnologia che si trova su Nintendo 3DS.

L’interessante approccio del Solid Light Lab

L’approccio della startup Solid Light Lab, che è anche uno stato dell’arte, mira, fondamentalmente, a ricreare nel mondo reale oggetti con la luce. La fisica di come si pensa di farlo funzionare è in realtà semplice. Semplice nel concetto, decisamente non nell’attuazione. Il loro pannello diagonale da 28 pollici ha 2,5 miliardi di pixel. Per fare un confronto, una TV 4K ne ha 8,2 milioni. E si stanno immaginando pareti video olografiche composte da questi pannelli più piccoli, con un massimo di 245 miliardi di pixel. Questi pixel sono molto più complessi di quelli sui telefoni o sugli schermi dei Tv. Sono in grado di manipolare con precisione la fase delle onde luminose in modo che le interazioni di quelle onde creino l’effetto olografico. I pixel Lcd o OLED standard devono solo creare il rosso, il verde e il blu. I pixel di SolidLight devono creare colori specifici in un punto specifico davanti al display in modo che l’immagine sembri uscire dallo schermo.

L’olografia tramite le reti neurali

Al MIT di Boston, nei laboratori dello CSAIL e EECS , Liang Shi, Beichen Li Changil Kim, Petr Kellnhofer e Wojciech Matusik hanno addestrato delle reti neurali che permettono l’olografia.

Il laboratorio di Steve Benton già in passato aveva creato, trasmesso e visualizzato ologrammi elettronici 3D. Fare questo richiedeva la comprensione simultanea delle esigenze della visione spaziale umana, la costruzione di un frame buffer elettronico di nuovo tipo e l’invenzione di un nuovo sistema di visualizzazione ottica.

Allora si sovrapponeva il display olografico con un display tattile “touch and feel” ed era stato sviluppato un software che consentiva di “toccare, sondare un’immagine olografica”. In tal modo era stata portata una vera interattività nella tecnologia digitale.

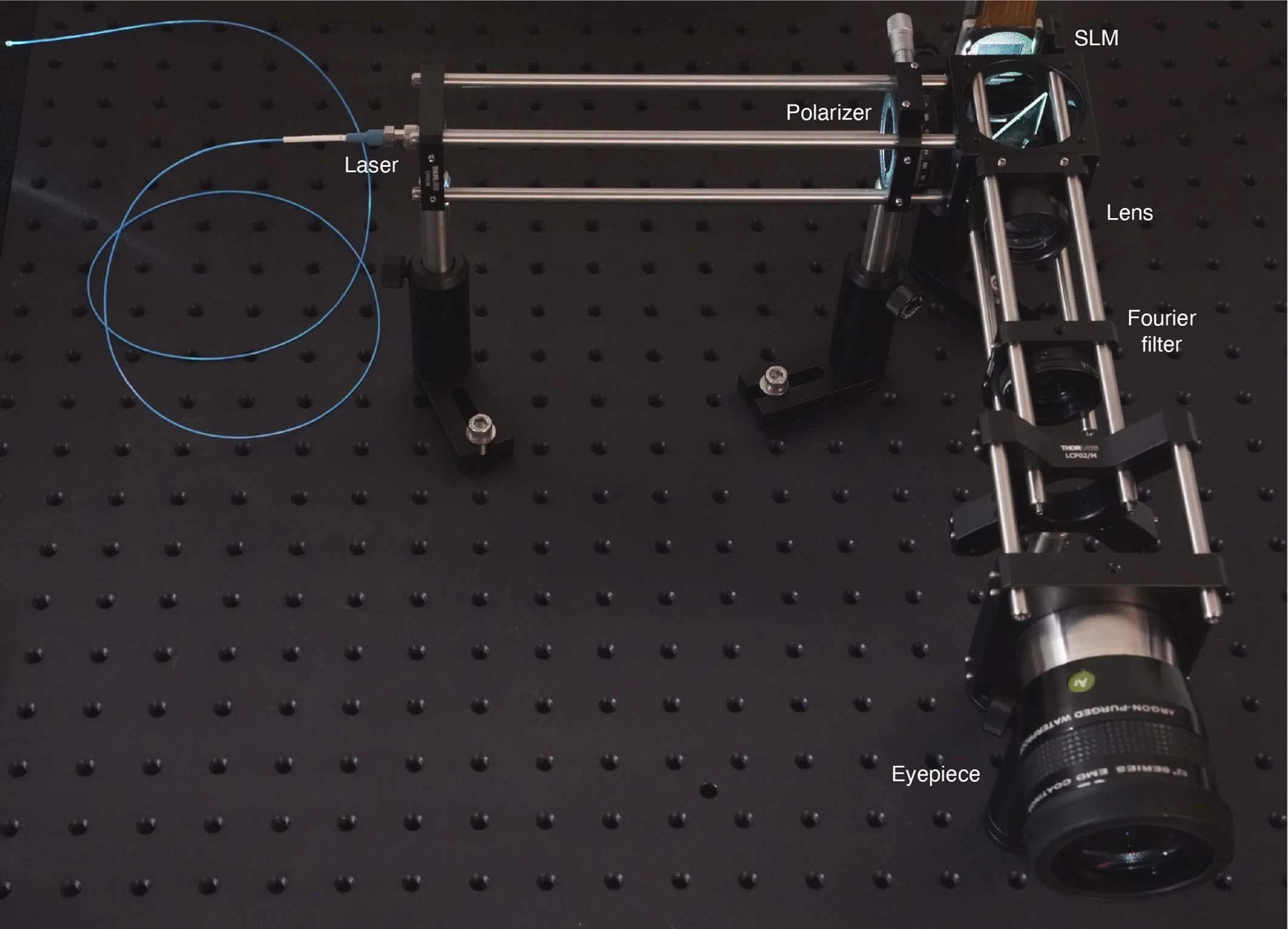

Prototipo di display olografico utilizzato per i risultati sperimentali nei laboratori dello CSAIL e EECS (foto Nature)

Si stava già da tempo, però, lavorando su sistemi 3D olografici che non richiedevano occhiali speciali per la visualizzazione. Questo si realizzava in modo che man mano che lo spettatore si spostava da un punto all’altro, venivano ricalcolate e presentate rapidamente nuove viste prospettiche, in modo che l’aspetto dell’immagine si avvicinasse a quella di un ologramma. Computazionalmente, però, il procedimento era molto pesante e non era sicuramente alla portata di personal computer o smartphone.

Oggi gli scienziati del laboratorio di Benton hanno progettato uno strumento basato su una tecnica di elaborazione che utilizza una catena di tensori addestrabili a imitare il modo in cui gli esseri umani elaborano le informazioni visive (rete neurale convoluzionale). L’addestramento di questi tipi di reti richiede un set di dati ampio e di alta qualità.

Per questo motivo, il team di ricerca ha progettato un database personalizzato di quattromila coppie di immagini generate al computer. Ogni coppia, abbinata a un’immagine, comprende le informazioni sul colore, la profondità di ciascun pixel e genera il suo ologramma corrispondente.

Nel database di ologrammi costruito, i ricercatori hanno utilizzato nuove scene con forme e colori complessi e variabili, con la profondità dei pixel distribuita uniformemente, dal background, al foreground e hanno effettuato una nuova serie di calcoli basati sulla fisica per gestire il problema dell’occlusione. Questo approccio ha portato a dati di addestramento fotorealistici. Successivamente, l’algoritmo è stato messo in funzione, e per ogni coppia di immagini ha modificato i parametri per i propri calcoli, migliorando progressivamente la sua capacità di creare ologrammi. La rete completamente ottimizzata è andata più veloce di diversi ordini di grandezza nei calcoli rispetto a quelli ottenibili per la via della fisica.

Olografia tensoriale

Questo studio ha dimostrato che, in pochi millisecondi, l’olografia tensoriale ha il potenziale per creare ologrammi da immagini con informazioni di profondità, quali quelle tipiche generate al computer e che possono essere calcolate da una semplice configurazione multi-camera. Questa è la svolta che apre la strada all’ologramma 3D in tempo reale. In particolare, l’olografia 3D in tempo reale potrebbe migliorare una serie di sistemi, dalla realtà virtuale alla stampa 3D.

Ecco la memoria apparsa su Nature (10 marzo 2021):

“La capacità di presentare scene tridimensionali (3D) con una sensazione di profondità ha un profondo impatto sulla realtà virtuale e aumentata (AR/VR), sull’interazione uomo-computer, sull’istruzione e sulla formazione. L’olografia generata dal computer (CGH) consente la proiezione 3D ad alta risoluzione spazio-angolare tramite la simulazione numerica della diffrazione e dell’interferenza. Tuttavia, i metodi esistenti basati sulla fisica non riescono a produrre ologrammi con controllo focale per pixel e occlusione accurata. La simulazione della diffrazione di Fresnel, gravosa dal punto di vista computazionale, impone inoltre un esplicito compromesso tra qualità dell’immagine e tempo di esecuzione, rendendo l’olografia dinamica tutt’altro che pratica.

Fonte: Nature

Qui dimostriamo (vedi memoria su Nature, ndr) la prima pipeline CGH basata su deep learning in grado di sintetizzare un ologramma 3D a colori fotorealistico da una singola immagine RGB-Depth (RGB-D) in tempo reale. La nostra rete neurale convoluzionale (CNN) è estremamente efficiente in termini di memoria (sotto i 620 KB) e funziona a 60 Hz per una risoluzione di 1920 × 1080 pixel su una singola unità di elaborazione grafica (GPU) di livello consumer. Sfruttando i chip dell’intelligenza artificiale (AI) sul dispositivo a bassa potenza, la nostra CNN funziona anche in modo interattivo su dispositivi mobili (iPhone 11 Pro a 1,1 Hz) e Edge (Google Edge TPU a 2 Hz), promettendo prestazioni in tempo reale nella generazione futura. Abilitiamo questa pipeline introducendo il primo set di dati CGH su larga scala (MIT-CGH-4K) con 4.000 coppie di immagini RGB-D e corrispondenti ologrammi 3D.

La nostra CNN è addestrata con funzioni di perdita differenziabili e approssima fisicamente la diffrazione di Fresnel. Con un metodo di codifica della sola fase, anti-alias, dimostriamo sperimentalmente ologrammi 3D ad alta risoluzione privi di macchie e dall’aspetto naturale. Il nostro approccio basato sull’apprendimento e il primo set di dati dell’ologramma di Fresnel contribuiranno a sbloccare il pieno potenziale dell’olografia e consentiranno nuove applicazioni nella progettazione di metasuperfici, manipolazione microscopica ottica e acustica , microscopia olografica e stampa 3D volumetrica a esposizione singola.”

Video (fonte Nature)

I ricercatori hanno messo a disposizione della comunità scientifica su GitHub sia il code (liangs111) che i data set di addestramento (MIT-CGH-4K).