Le nostre foto potrebbero essere modificate dai sistemi di intelligenza artificiale, senza la nostra volontà e senza che ce ne accorgiamo. Ancora peggio, la sofisticatezza di questi sistemi potrebbe rendere impossibile dimostrare che l’immagine risultante è falsa. Tuttavia, una buona notizia arriva dai ricercatori del MIT: un nuovo strumento chiamato PhotoGuard potrebbe prevenire tutto ciò.

Indice degli argomenti:

PhotoGuard: uno scudo protettivo per le foto

PhotoGuard funziona come uno scudo protettivo, alterando le foto in modo impercettibile all’occhio umano, ma impedendo la manipolazione da parte delle intelligenze artificiali. Se qualcuno tenta di utilizzare un’app di editing basata su un modello AI generativo come Stable Diffusion per manipolare un’immagine “immunizzata” da PhotoGuard, il risultato apparirà irrealistico o distorto.

Attualmente, “chiunque può prendere la nostra immagine, modificarla a proprio piacimento, metterci in situazioni molto sgradevoli e magari ricattarci”, afferma Hadi Salman, ricercatore PhD al MIT che ha contribuito alla ricerca. Il progetto è stato presentato alla Conferenza Internazionale sul Machine Learning a fine luglio 2023.

PhotoGuard rappresenta “un tentativo di risolvere il problema della manipolazione maliziosa delle nostre immagini da parte di questi modelli”, afferma Salman. Lo strumento potrebbe, ad esempio, aiutare a prevenire che i selfie delle donne vengano trasformati in pornografia deepfake non consensuale.

La necessità di trovare modi per rilevare e fermare la manipolazione AI non è mai stata così urgente, poiché gli strumenti AI generativi hanno reso il processo più rapido e facile che mai. In un impegno volontario con la Casa Bianca, importanti aziende di intelligenza artificiale come OpenAI, Google e Meta si sono impegnate a sviluppare metodi per prevenire frodi e inganni. PhotoGuard rappresenta una tecnica complementare a un’altra di queste tecniche, ovvero il watermarking: mentre quest’ultimo consente di rilevare contenuti generati da AI una volta creati, PhotoGuard mira a impedire l’utilizzo di strumenti AI per manipolare le immagini fin dall’inizio, utilizzando segnali invisibili simili.

Due tecniche innovative per fermare la manipolazione delle immagini AI

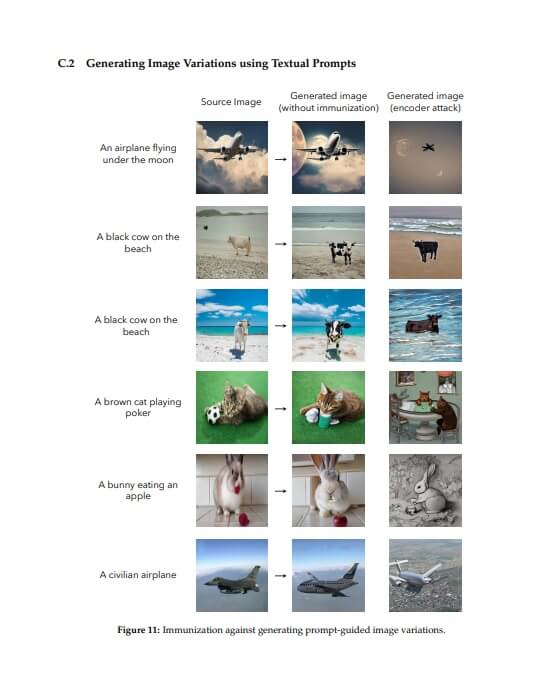

Il team del MIT ha utilizzato due diverse tecniche per impedire la modifica delle immagini utilizzando il modello di generazione di immagini open-source Stable Diffusion.

La prima tecnica si chiama attacco all’encoder. PhotoGuard aggiunge segnali impercettibili all’immagine in modo che il modello AI lo interpreti come qualcos’altro. Ad esempio, questi segnali potrebbero far sì che l’AI classifichi un’immagine di Trevor Noah come un blocco di puro grigio. Di conseguenza, qualsiasi tentativo di utilizzare Stable Diffusion per inserire Noah in altre situazioni apparirebbe poco convincente.

La seconda tecnica, più efficace, si chiama attacco alla diffusione. Questa tecnica altera il modo in cui i modelli AI generano le immagini, codificandole con segnali segreti che ne modificano il processo di elaborazione. Aggiungendo questi segnali a un’immagine di Trevor Noah, il team è riuscito a manipolare il modello di diffusione in modo da ignorare il prompt e generare l’immagine desiderata dai ricercatori. Di conseguenza, qualsiasi immagine di Noah modificata da AI apparirebbe semplicemente grigia.

Il lavoro svolto rappresenta “una buona combinazione tra un bisogno tangibile e ciò che può essere fatto ora stesso”, afferma Ben Zhao, professore di informatica presso l’Università di Chicago, che ha sviluppato un metodo protettivo simile chiamato Glaze, utilizzato dagli artisti per impedire che le loro opere vengano utilizzate nei modelli AI.

Immagine MIT

Strumenti come PhotoGuard cambiano l’economia e gli incentivi per gli attaccanti, rendendo più difficile l’utilizzo di AI in modo malizioso, afferma Emily Wenger, ricercatrice presso Meta, che ha lavorato anche a Glaze e ha sviluppato metodi per prevenire il riconoscimento facciale.

“Più alto è il livello di protezione, meno persone saranno disposte o in grado di superarlo”, afferma Wenger.

Una sfida sarà vedere come questa tecnica si applica ad altri modelli disponibili, afferma Zhao. I ricercatori hanno pubblicato una demo online che consente alle persone di immunizzare le proprie foto, ma al momento funziona in modo affidabile solo su Stable Diffusion.

E sebbene PhotoGuard possa rendere più difficile la manipolazione delle nuove immagini, non offre una protezione completa contro i deepfake, poiché le vecchie immagini degli utenti potrebbero comunque essere disponibili per un uso improprio, e ci sono altre modalità per produrre deepfake, afferma Valeriia Cherepanova, ricercatrice PhD presso l’Università del Maryland, che ha sviluppato tecniche per proteggere gli utenti dei social media dal riconoscimento facciale.

In teoria, le persone potrebbero applicare questo scudo protettivo alle loro immagini prima di caricarle online, afferma Aleksander Madry, professore al MIT che ha contribuito alla ricerca. Tuttavia, un approccio più efficace sarebbe che le aziende tecnologiche lo aggiungessero automaticamente alle immagini caricate sulle loro piattaforme.

Si tratta di una corsa agli armamenti: mentre si sono impegnate a migliorare i metodi di protezione, le aziende tecnologiche stanno ancora sviluppando nuovi e migliori modelli AI a una velocità incredibile, e nuovi modelli potrebbero essere in grado di eludere qualsiasi nuova protezione.

Il miglior scenario sarebbe se le aziende che sviluppano modelli AI fornissero anche un modo per immunizzare le immagini delle persone che funzioni con ogni modello AI aggiornato, afferma Salman.

Proteggere le immagini dalla manipolazione AI alla fonte è una opzione molto più fattibile rispetto all’utilizzo di metodi non affidabili per rilevare la manipolazione AI, afferma Henry Ajder, esperto di AI generativa e deepfake.