L’AI generativa è una delle innovazioni tecnologiche che segnerà profondamente i prossimi anni. Gartner ha inserito l’intelligenza artificiale generativa tra i 5 trend dell’AI, identificando tra i possibili ambiti di applicazione quello della creazione di media sintetici. In particolare, la tecnica del text-to-image implementata da tool come DALL-E e Midjourney consente di digitare delle istruzioni testuali (chiamate prompt) e generare in automatico immagini.

Indice degli argomenti:

AI generativa e media sintetici

A inizio 2023, CB Insight ha evidenziato l’hype finanziario attorno all’AI generativa: se il 2022 è stato un anno da record per gli investimenti in startup di AI generativa (110 investimenti per un valore complessivo di 2,6 miliardi di dollari), c’è ancora moltissimo spazio di crescita per gli investitori dal momento che più dei due terzi delle startup in questo ambito non ha ancora raccolto il round-A [1]. Un altro segnale della rilevanza del settore arriva dalle big tech. A inizio 2023 Microsoft ha annunciato un investimento di 10 miliardi di dollari in uno dei principali player, OpenAI; non si tratta di una scelta puramente finanziaria, ma di una strategia per riuscire ad acquisire un vantaggio competitivo rispetto ai competitor e in particolare Alphabet; Microsoft ha infatti integrato questa stessa tecnologia nelle proprie funzionalità del browser Edge e del motore di ricerca Bing [2]. Alphabet, lato suo, per non perdere terreno, a febbraio ha annunciato pubblicamente la sua tecnologia di AI Conversazionale: BERT, il chatbot basato sul loro modello linguistico LaMDA [3].

Le mosse di questi player sembrano confermare le previsioni di Nina Schick, autrice nel 2020 di The Era of Generative AI, saggio dedicato al trend dell’AI generativa: in questa pubblicazione Schick prevede che, entro massimo il 2030, il 90% dei contenuti su Internet sarà generato automaticamente. Non solo testi ma anche codice informatico, immagini e video, saranno sempre di più il risultato di un’attività dell’uomo svolta in collaborazione con strumenti di intelligenza artificiale basata su modelli di machine learning generativi.

Risulta quindi necessario interrogarsi sul potenziale impatto di queste tecnologie e sui possibili ambiti di applicazione, sia per il mondo della creatività, dei designer, delle agenzie di comunicazione, che hanno ora a disposizione nuovi strumenti a supporto del processo produttivo; sia più in generale per le aziende e PMI che potranno utilizzare sempre più i media sintetici come contenuti per la valorizzazione del proprio brand e per le proprie strategie di marketing e comunicazione. Un’evoluzione che necessita una consapevolezza delle specificità di queste tecnologie per poterle approcciare al meglio.

Esploriamo il panorama dei media sintetici visivi a livello di mercato internazionale, per poi fare un affondo sulla campagna di comunicazione realizzata dall’agenzia di media relation Press Play e dallo studio di design Peterman per l’azienda di ingegneria Teoresi: da qui è possibile partire per identificare opportunità e specificità della creatività basata su media sintetici.

Immagini generate dal machine learning: l’impatto sulla creatività digitale

Un ambito in cui le tecnologie di AI generativa e i media sintetici potranno avere un impatto significativo è quello della produzione di contenuti visivi. La tecnica del text-to-image implementata da tool come DALL-E e Midjourney consente di digitare delle istruzioni testuali (chiamate prompt) e generare in automatico immagini. L’impatto di questi new entrant sul mondo delle arti visive digitali è evidente dalle reazioni dei player storici. Alcuni di essi hanno un approccio collaborativo: il provider globale di foto e video autorizzati di alta qualità ShutterStock ha infatti sviluppato un proprio tool di generazione di immagini con la tecnologia di OpenAI e Dall-E 2 [4].

Altri hanno un approccio protezionistico: è il caso di Getty Image che accusa Stable Diffusion di aver utilizzato i database di immagini per allenare i suoi modelli [5]. Al centro di questo dibattito tra arti, media generati attraverso il machine learning e diritto d’autore, si posiziona anche Adobe che nega l’accusa di aver utilizzato i dati degli utenti per allenare l’AI generativa [6]. Le dimensioni di questo conflitto sono un’ulteriore conferma dell’impatto che avranno tali tecnologie e di una necessità di nuove (o forse diverse) regolamentazioni del settore.

Passando dal macro-livello che coinvolge l’intera industry alla pratica quotidiana dei progetti creativi, l’impatto del text-to-image è altrettanto evidente e, auspicabilmente, meno problematico se approcciato nel modo corretto. I tool di generazioni di immagini stanno infatti diventando uno strumento utile sia per velocizzare alcuni processi creativi, sia per generare stimoli nuovi e dare input nel processo di brainstorming. Così come è stato per altri strumenti informatici, dai software di fotoritocco a quelli per la modellazione di ambienti 3D, i tool di text-to-image non sostituiranno la figura del designer, ma lo supporteranno nel processo produttivo, tanto da poter parlare di co-creazione tra umani e macchine. Se, da un lato, hanno capacità di produzione autonoma molto elevata, allo stesso tempo richiedono interventi autoriali in preproduzione: il creativo deve infatti dare in input alla macchina un prompt funzionale a ottenere il risultato desiderato. A ciò si aggiungono le modifiche in post-produzione, in quanto l’output finale non è controllabile e può necessitare di ritocchi con tool più tradizionali per rispondere alle effettive esigenze di comunicazione.

Oltre a questo i tool di text-to-image possono avere limiti strutturali, anche se potenzialmente migliorabili nel tempo in funzione del miglioramento della tecnologia di machine learning: si pensi ad esempio alla difficoltà nel riprodurre correttamente particolari elementi, come le mani. Come conseguenza, anche se la generazione tecnica dell’immagine è a opera del tool, molta della creatività sta nella scrittura dei prompt e nel processo successivo di revisione ed eventuale post-produzione. In particolare, durante la scrittura del prompt, il creativo agisce con il proprio ruolo strategico di art director nel dare il brief e le indicazioni alla macchina sull’output da generare. Si tratta di un cambiamento radicale nell’interazione tra designer e tool in quanto, semplificando molto, nel mondo della creatività digitale tradizionale il designer dà in input al software i tratti del disegno attraverso trackpad o mouse, mentre ora deve descrivere l’immagine a parole, sviluppando quindi competenze completamente differenti da quelle del designer tradizionale.

Proprio per questo motivo il magazine statunitense The Atlantic arriva addirittura a ipotizzare che una delle più importanti competenze dei lavoratori del futuro sarà la capacità di dare istruzioni alle macchine [7].

Il ruolo del text-to-image nella comunicazione: la campagna digital di Teoresi

Le aziende hanno già cominciato a cavalcare l’onda dei media generativi per la propria comunicazione: dai Life Trends 2023 di Accenture [8] agli auguri di Natale di Saatchi & Saatchi [9], fino alla campagna social festiva del gruppo Barilla [10]. Ma non mancano anche casi di aziende italiane, come la società di ingegneria Teoresi per la quale l’agenzia di media relation Press Play e lo studio di design Peterman hanno realizzato una campagna di fine anno dove le immagini generate da AI sono state utilizzate per descrivere le tecnologie di frontiera del 2023 in cui l’azienda ha progettualità di R&D.

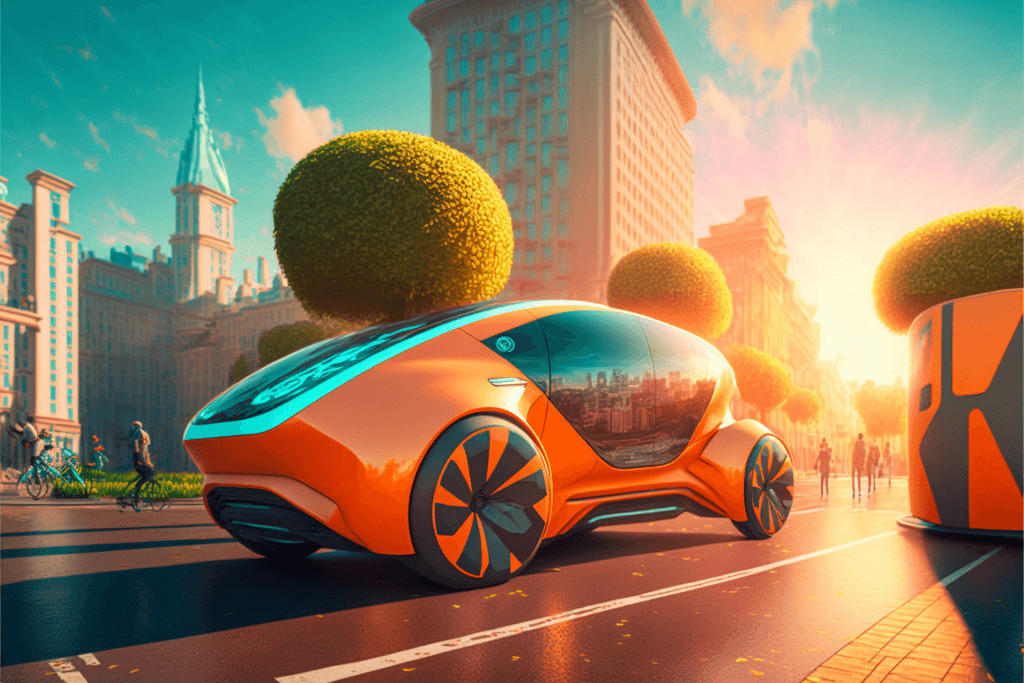

Teoresi è una società internazionale nata a Torino nel 1987 che sviluppa software embedded per il settore dei trasporti nonché per nuovi mercati come il lifescience e il fintech. L’esigenza di Teoresi era di raccontare le tecnologie di frontiera con uno stile e un’estetica in grado di interpretare il payoff “Engineering for human life”; l’obiettivo creativo era quindi allontanarsi da un immaginario in cui le tecnologie sovrastano natura e umanità per costruire, al contrario, una rappresentazione in cui intelligenza artificiale e robotica convergono armonicamente con paesaggio urbano e fisiologia umana.

Un tipo di rappresentazione che si scontra con i limiti delle immagini digitali tradizionali: i contenuti fotografici rendono infatti necessario un soggetto reale da riprendere; le foto stock rappresentano immagini stereotipate che, evocano futuri distopici o ipertecnologici; le illustrazioni ad hoc hanno costi e tempi spesso proibitivi per poter essere utilizzate in campagne di comunicazioni digital o per canali che necessitano aggiornamento frequente. Il text-to-image, dunque, non è solo un trend ma una risposta concreta a queste esigenze, in quanto concilia potenzialità espressive con l’automatizzazione dei processi di produzione.

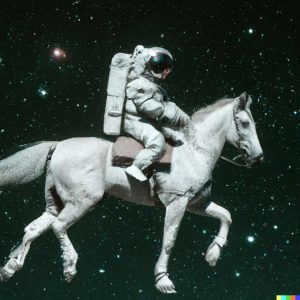

A partire da questa intuizione è nato il progetto “Buon futuro”, una campagna di comunicazione in cui l’AI è stata usata per rappresentare le tecnologie di frontiera del 2023: smart mobility, life science, railway, air urban mobility & aerospace.

Il concept

Il concept è stato ideato da Press Play, agenzia di PR che cura il posizionamento media di Teoresi e realizzato dallo studio di design Peterman. Quest’ultimo, nello specifico, ha realizzato gli asset digitali della campagna e in particolare le 4 rappresentazioni dei settori di frontiera attraverso Midjourney . Ogni software di generazione immagini possiede uno stile e una modalità propria per l’elaborazione dei dati: in questo caso la scelta di Midjourney è stata dettata dalla volontà di utilizzare un tool che privilegiasse la concept art, ovvero uno stile onirico, invece di uno stile realistico che caratterizza la maggior parte degli altri software.

La realizzazione del progetto ha portato a identificare alcune specificità nella produzione visiva supportata da tool di generazione di immagini. Da un lato la possibilità di utilizzare un tool che ha in input contenuti testuali consente a chiunque, anche senza un background da designer, di generare asset visivi; tuttavia, generare immagini esteticamente appaganti non significa avere padronanza dello strumento al punto da poter creare progetti di comunicazione per le aziende, come ha fatto Peterman per Teoresi. Per un utilizzo professionale dei software di generazione immagini, affinché siano uno strumento funzionale alla valorizzazione dei brand, è infatti necessario considerare le specificità del processo creativo: questo parte dall’acquisizione del brief dell’azienda e si caratterizza per la produzione di contenuto spesso soggetto a revisioni e integrazioni di ulteriori richieste (rework).

La specificità del text-to-image

È qui che la professionalità e la conoscenza del mondo visivo diventano decisivi: nella capacità di riuscire a tradurre gli obiettivi aziendali in output allineati con i desiderata; tanto più quando si utilizzano software basati su machine learning, che non eseguono in modo didascalico delle istruzioni ma mettono in campo la propria conoscenza del mondo visivo per produrre contenuti su cui il designer ha un controllo parziale. In questo processo si inserisce la specificità del text-to-image, che ha come output contenuti visivi, ma come input messaggi testuali: l’utente, quindi, non interviene direttamente sullo stile, sul tratto o sul colore, ma dà in input alla macchina contenuti testuali. Questo cambia radicalmente la natura stessa del lavoro del designer, che diventa di concetto. Per riuscire a descrivere nel modo più efficace possibile al software le aspettative, è fondamentale avere immaginazione e un bagaglio di conoscenza stilistica alle spalle. Risulta infatti necessario descrivere i particolari e gli stili tecnici che si vogliono applicare: ogni tecnica visiva (dall’acquarello al grandangolo fino all’Unreal Engine 3D) viene riconosciuta, processata e tradotta in immagine. A questo si aggiunge un’altra sfida, ossia creare coerenza visiva tra differenti contenuti.

La campagna di comunicazione di Teoresi, infatti, era multi-soggetto, ovvero composta da quattro diverse immagini: quando le singole rappresentazioni sono parte di un progetto più ampio è fondamentale mantenere una direzione creativa attraverso uno stile visivo coerente in grado di rappresentare allo stesso tempo immaginari futuristici, realismo, cura dei dettagli e tecnologia visionaria.

Conclusioni

Dalla descrizione di questo processo risulta quindi evidente che i tool di text-to-image, così come più in generale i software di generazione di media sintetici, sono ben lontani dal sostituire i creativi: al contrario si tratta di “strumenti” ormai immancabili nella cassetta degli attrezzi dei designer. Oltre, naturalmente, a costituire un’enorme opportunità per i brand interessati a innovare, anche dal punto di vista dei processi creativi scelti per le proprie campagne di comunicazione.

Fonti

[1] CbInsight, The state of generative AI in 7 charts – CB Insights Research

[2] Microsoft, Reinventare la ricerca: con Microsoft Bing ed Edge potenziati dall’Intelligenza Artificiale

[3] Sundar Pichai, CEO of Google and Alphabet, An important next step on our AI journey, Feb 06, 2023 An important next step on our AI journey

[4] Techcrunch, After inking its OpenAI deal, Shutterstock rolls out a generative AI toolkit to create images based on text prompts, 25 gennaio 2023

[5] Reuters, Getty Images lawsuit says Stability AI misused photos to train AI, 6 febbraio 2023

[6] Adobe, Facing Blowback, Says Customer Data Not Used to Train AI, 18 gennaio 2023

[7] Charlie Warzel, The Atlantic Talking to AI might be the most important skill of this century

[9] Saatchi & Saatchi https://allaiwantforxmas.com/

[10] Alessio Garbin, Digital Marketing Coordinator Barilla Region Italy https://www.linkedin.com/posts/alessiogarbin_intelligenzaartificiale-ai-ia-activity-7015685836172111872-zWs1