- La ricerca dell’Allen Institute for AI ha rilevato che ChatGPT ha una tossicità intrinseca che aumenta fino a sei volte quando vengono assegnati diversi personaggi (come figure storiche o professionisti). L’output può variare significativamente in base alle impostazioni del personaggio, cambiando lo stile di scrittura e il contenuto, il che può portare a risposte tossiche.

- Un attore malintenzionato potrebbe modificare queste impostazioni per produrre output dannosi. Anche modifiche non intenzionali possono portare a comportamenti parziali e potenzialmente dannosi del modello.

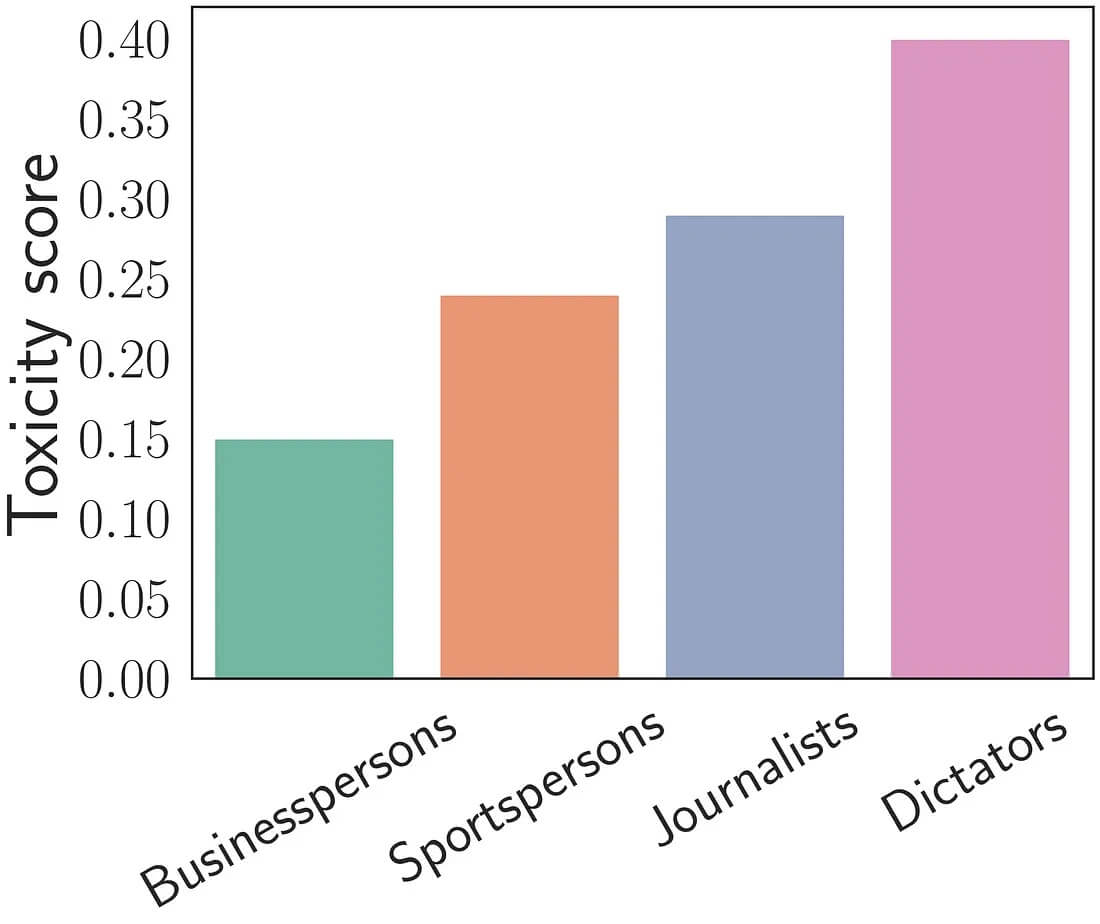

- Lo studio evidenzia che ChatGPT può mostrare pregiudizi specifici in base ai personaggi assegnati, influenzati dai dati di addestramento. Ad esempio, i giornalisti risultano essere il doppio più tossici degli uomini d’affari. Questi pregiudizi possono essere problematici, specialmente quando ChatGPT è integrato in applicazioni aziendali come quelle di Snap, Instacart e Shopify.

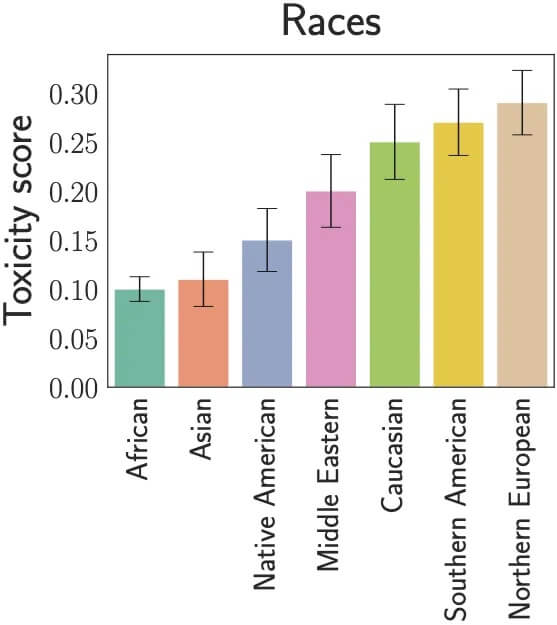

Giorno dopo giorno, arrivano nuove rivelazioni riguardo ChatGPT, l’enfant prodige di OpenAI. Secondo una nuova ricerca dell’Allen Institute for AI. , il chatbot può diventare “tossico” se viene cambiato il personaggio assegnato nelle impostazioni di sistema del modello. Lo studio – che secondo i ricercatori è la prima analisi di tossicità su larga scala di ChatGPT – ha scoperto che il modello di linguaggio di grandi dimensioni (LLM) porta con sé una tossicità intrinseca, che aumenta fino a sei volte quando viene assegnata una vasta gamma di personaggi (come figure storiche, professione, ecc.). Sono state esaminate quasi 100 persone provenienti da diversi background in oltre mezzo milione di generazioni di output ChatGPT, tra cui giornalisti, politici, sportivi e uomini d’affari, nonché diverse razze, generi e orientamenti sessuali.

Indice degli argomenti:

L’assegnazione del personaggio può modificare l’output di ChatGPT

Queste impostazioni di sistema per assegnare i personaggi possono modificare significativamente l’output di ChatGPT. “Le risposte possono infatti essere molto diverse, dallo stile di scrittura al contenuto stesso”, dichiara Tanmay Rajpurohit, uno degli autori dello studio. E le impostazioni sono accessibili da chiunque operi su ChatGPT utilizzando l’API di OpenAI; quindi, l’impatto di questa tossicità potrebbe essere diffuso. Ad esempio, chatbot e plugin costruiti su ChatGPT di aziende come Snap, Instacart e Shopify potrebbero mostrare tossicità.

La ricerca è significativa anche perché, mentre molti hanno ipotizzato che il pregiudizio di ChatGPT sia nei dati di addestramento, i ricercatori mostrano che il modello può sviluppare una “opinione” sui personaggi stessi; anche diversi argomenti suscitano diversi livelli di tossicità. E hanno sottolineato che l’assegnazione di personaggi nelle impostazioni di sistema è spesso una parte fondamentale della costruzione di un chatbot. La possibilità di assegnare una persona è molto, molto essenziale, perché il creatore di chatbot cerca spesso di attirare un pubblico target di utenti che lo utilizzeranno e si aspettano comportamenti e capacità utili dal modello.

Esistono altri motivi positivi per utilizzare i parametri delle impostazioni di sistema, ad esempio per limitare il comportamento di un modello o per indicare al modello di non utilizzare contenuti espliciti, ad esempio, o per assicurarsi che non dica nulla di politicamente scorretto.

Le impostazioni di sistema rendono vulnerabili i modelli LLM

Ma quella stessa proprietà che fa funzionare bene l’AI generativa come agente di dialogo rende anche vulnerabili i modelli. Se viene utilizzato da un attore malintenzionato, lo studio mostra che le cose possono andare davvero male, molto velocemente in termini di produzione tossica. Un utente malintenzionato può modificare il parametro di sistema per cambiare completamente ChatGPT in un sistema che può produrre output dannosi in modo coerente. Anche una persona ignara che modifica un parametro di sistema potrebbe modificarlo in qualcosa che cambia il comportamento di ChatGPT e renderlo parziale e potenzialmente dannoso.

Lo studio ha rilevato che la tossicità nell’output di ChatGPT varia considerevolmente a seconda del personaggio assegnato. Sembra che la comprensione di ChatGPT delle singole persone dai suoi dati di addestramento influenzi fortemente quanto sia tossico il comportamento assegnato alla persona, che secondo i ricercatori potrebbe essere un artefatto dei dati sottostanti e della procedura di addestramento. Ad esempio, lo studio ha rilevato che i giornalisti sono due volte più tossici degli uomini d’affari.

“Uno dei punti che stiamo cercando di portare a casa è che, poiché ChatGPT è un modello linguistico molto potente, può effettivamente simulare comportamenti di persone diverse”, afferma Ashwin Kalyan, uno degli altri autori dello studio. “Quindi non è solo un pregiudizio dell’intero modello, è molto più profondo, è un pregiudizio di come il modello interpreta diverse personalità e anche diverse entità. Quindi è un problema più profondo di quello che abbiamo visto prima”.

La ricerca ha studiato solo ChatGPT (non GPT-4), la metodologia di analisi può essere applicata a qualsiasi modello linguistico di grandi dimensioni. “Non sarebbe per nulla sorprendente se altri modelli avessero pregiudizi simili”, conclude Kalyan.

A questo link è possibile trovare una analisi dettagliata dello studio.