Possiamo considerarlo l’ultimo (in ordine di tempo) passaggio di un percorso articolato, iniziato nel mese di luglio dello scorso anno, che ha portato l’Unione Europea a pubblicare per prima le proprie linee guida per garantire un approccio etico all’intelligenza artificiale.

L’iniziativa, lanciata un anno fa sotto l’egida della “Trustworthy AI” con la creazione di un gruppo di lavoro sul tema, è proseguita tra dicembre e febbraio con una consultazione pubblica alla quale hanno preso parte cittadini, ricercatori e istituzioni, per arrivare all’8 aprile con la pubblicazione di un elenco di requisiti che consentono di anteporre quell’aggettivo – Trustworthy – al termine Intelligenza Artificiale.

Indice degli argomenti:

Perché una Trustworthy AI

Il punto di partenza è interessante: “La dimensione etica dell’Intelligenza artificiale non né un lusso né un accessorio”, si legge infatti nella dichiarazione di Andrus Ansip, vice presidente per il mercato unico digitale europeo, il quale poi aggiunge che “è solo con la fiducia che la nostra società può godere appieno dei benefici che derivano dalle tecnologie”.

Non si tratta di una questione puramente accademica.

L’Unione Europea non si limita infatti a riconoscere quanto spazio l’Intelligenza Artificiale stia trovando nel mondo delle imprese, ma ha varato essa stessa un piano di investimenti aumentando i propri investimenti nel quadro del programma Horizon 2020 portandoli a 1,5 miliardi di euro nel periodo 2018-2020 ponendosi come obiettivo quello di connettere e rafforzare i centri di ricerca in Europa, supportare lo sviluppo di una piattaforma di AI-on-demand che dia accesso a risorse rilevanti a tutti gli utenti, supportare lo sviluppo di applicazioni AI nei settori ritenuti chiave e strategici.

È evidente, prosegue nella sua nota Ansip, che solo una “Intelligenza Artificiale etica può rappresentare un vantaggio competitivo per l’Europa, che assumerebbe un ruolo di leadership verso una Intelligenza Artificiale human-centrica di cui ci possa davvero fidare”.

Essere DPO nel 2025: quali sono le competenze e i requisiti necessari

I sette requisiti per una Intelligenza Artificiale Etica

- Supervisione umana: I sistemi di intelligenza artificiale dovrebbero favorire lo sviluppo dell’equità sociale, sostenendo i diritti fondamentali, senza diminuire, limitare o fuorviare l’autonomia umana.

- Robustezza e sicurezza: La Trustworthy AI richiede algoritmi sicuri e sufficientemente robusti da contrastare gli errori e le inconsistenze durante l’intero ciclo di vita dei sistemi di Intelligenza Artificiale.

- Privacy e data governance: I cittadini dovrebbero avere pieno controllo sui propri dati, nella sicurezza che i dati che li riguardano non possano essere utilizzati a loro danno o a fini discriminatori.

- Trasparenza: Deve essere garantita la tracciabilità dei sistemi di Intelligenza Artificiale

- Diversity, correttezza, assenza di discriminazione: I sistemi di Intelligenza Artificiale dovrebbero prendere in considerazione tutte le capacità e gli skill umani, garantendo a tutti l’accessibilità.

- Benessere sociale e ambientale: I sistemi di Intelligenza Artificiale dovrebbero essere utilizzati per sostenere cambiamenti positivi, migliorare la sostenibilità ambientale e la responsabilità ecologica.

- Responsabilità: Devono essere adottati meccanismi che garantiscano la responsabilità sui sistemi di Intelligenza Artificiale e sui loro risultati.

I prossimi passi della UE

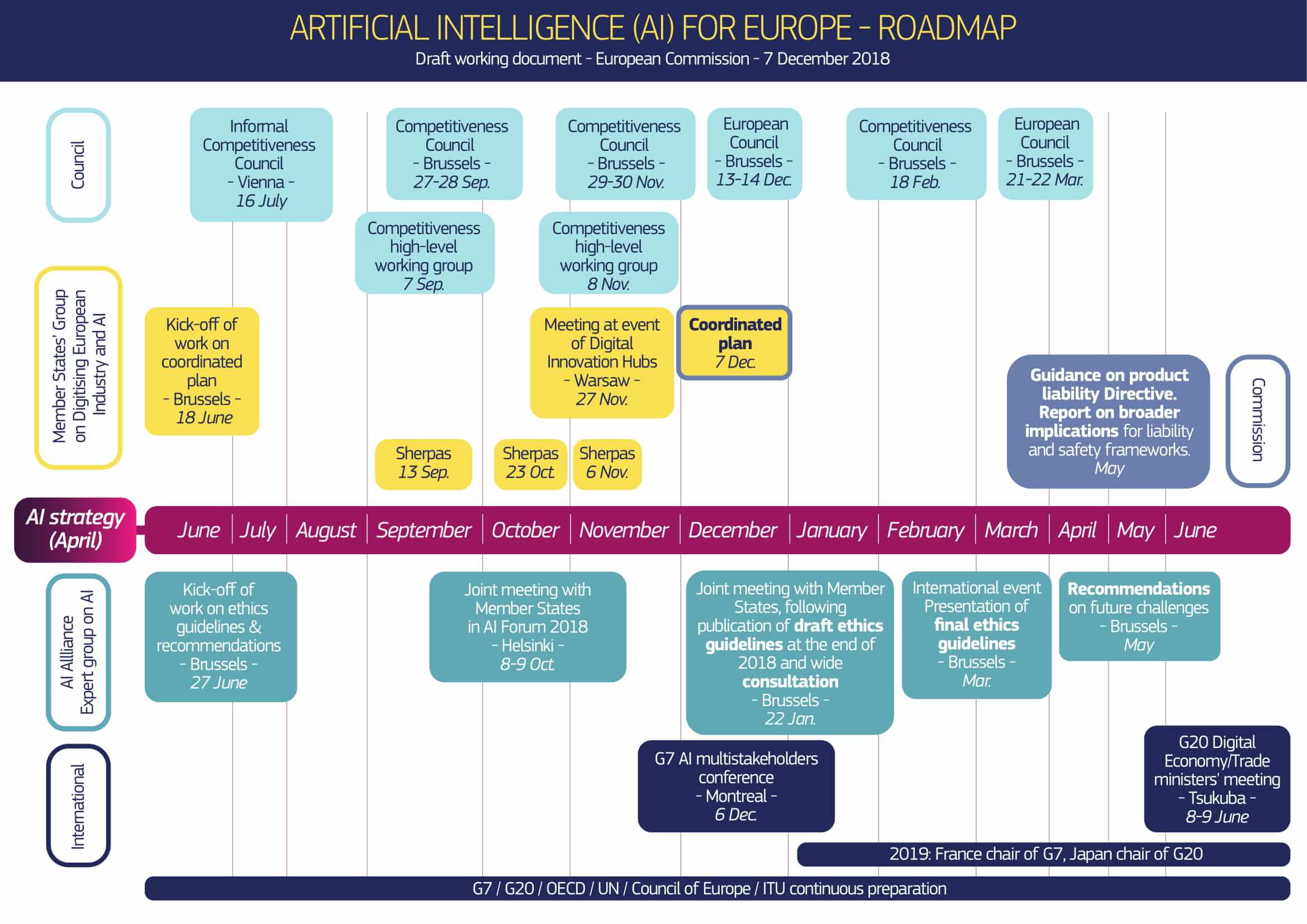

Come è facile immaginare, la Commissione Europea non si è limitata a pubblicare i sette principi della Trustworthy AI, ma li accompagna con una roadmap di azioni ben precisa.

Entro l’estate verrà dato il via a una fase pilota, nella quale verranno coinvolti numerosi stakeholder.

Gli interessati hanno la possibilità di iscriversi fin da subito alla European AI Alliance per prendere parte al progetto al momento del suo varo ufficiale, mentre chi già fa parte del gruppo di esperti che vi hanno contribuito finora aiuterà a presentare le linee guida agli stakeholder di tutti gli Stati Membri.

Ricordiamo infatti che esattamente un anno fa, la Commissione Europea aveva costituito un High-Level Expert Group on AI, del quale fanno parte 52 esperti ed accademici, e tra i quali figurano gli italiani Luciano Floridi, Chiara Giovannini, Stefano Quintarelli, Francesca Rossi.

Ma ancora non basta: per la Commissione Europea è importante che questo approccio etico all’Intelligenza Artificiale sia condiviso anche a livello superiore e per questo ha intenzione di rafforzare la cooperazione con altri Paesi che condividono la sua visione come Giappone, Canada o Singapore, impegnandosi nel contempo a giocare un ruolo attivo in consessi internazionali come G7 e G20 e a coinvolgere imprese e organizzazioni internazionali.

Tornando alla roadmap, all’inizio del prossimo anno, la lista dei requisiti e l’impianto generale sarà oggetto di un ulteriore assessment, sulla base dei feedback ricevuti nel corso della fase pilota, mentre già nel corso dell’autunno di quest’anno è intenzione della Commissione Europea lanciare una rete di centri di ricerca di eccellenza sui temi dell’Intelligenza Artificiale e una rete di hub di innovazione digitale, portando sul tavolo della discussione un ulteriore tema chiave: la definizione di un modello per la condivisione e l’utilizzo di dati e di spazi dati.

La prima iniziativa governativa

Va detto che quella europea è la prima iniziativa di questo tipo varata da un ente governativo e non è un caso che il mondo delle imprese stia guardando a questo tipo di approccio come a un modello da perseguire.

Prima tra tutti IBM, che in una nota, dopo aver sottolineato come per molte imprese sia al momento difficile spiegare ai propri clienti come l’Intelligenza Artificiale utilizza i dati, saluta l’iniziativa della UE con le parole di Martin Jetter, Senior Vice President & Chairman IBM Europe: “Le linee guida etiche per la Trustworthy AI rappresentano un modello per perseguire una Intelligenza Artificiale che sia etica e responsabile. Le linee guida della UE riflettono molti principi che IBM ha perseguito da tempo e siamo orgogliosi di partecipare al gruppo di esperti che hanno sviluppato queste stesse linee guida”.

Google fa marcia indietro

L’aspetto singolare di questo annuncio è che arriva a pochi giorni dalla chiusura di una analoga iniziativa di stampo prettamente privato.

Poche settimane fa, infatti, Google aveva annunciato la creazione di un gruppo di lavoro, con l’obiettivo di lavorare proprio sull’etica dell’intelligenza Artificiale, nominando, il 26 marzo un proprio Advisory Council che, come scritto in un blog post si sarebbe dovuto incontrare quattro volte l’anno.

Immediatamente dopo l’annuncio della costituzione del gruppo, da più parti sono state sollevate obiezioni in merito alla presenza al suo interno di Kay Coles James, presidente della Heritage Foundation, definita non semplicemente conservatrice, ma anti-LGBTQ e anti-migranti.

La presenza di Kay Coles James è risultata divisiva, tanto che pochi giorni dopo l’annuncio sia Alessandro Acquisti, professore alla Carnegie Mellon, sia Luciano Floridi, entrambi invitati a far parte del gruppo, annunciavano pubblicamente la loro decisione di non partecipare, sostenendo come la loro dedizione a una ricerca che promuova la correttezza e l’inclusione nell’AI sia incompatibile di fatto con la presenza nel gruppo di lavoro di una figura così controversa.

A seguito delle polemiche, sostenute anche da una petizione promossa dai dipendenti stessi della società, Google ha deciso per il momento di cancellare l’iniziativa: “Continueremo responsabilmente il nostro lavoro su tematiche così cruciali per l’Intelligenza Artificiale e troveremo altri modi per raccogliere opinioni e contributi esterni”.